小满OKKICRM数据集成到领猫技术案例分享

在本次技术案例中,我们将详细解析如何通过轻易云数据集成平台,实现小满OKKICRM数据快速、可靠地集成到领猫。具体的方案名称为“小满规格&领猫颜色--ok”。此次对接任务,主要需要解决以下几个关键技术难题:如何确保小满OKKICRM的数据不漏单、大量数据快速写入到领猫、定时抓取与批量处理API接口数据,以及应对分页和限流问题。

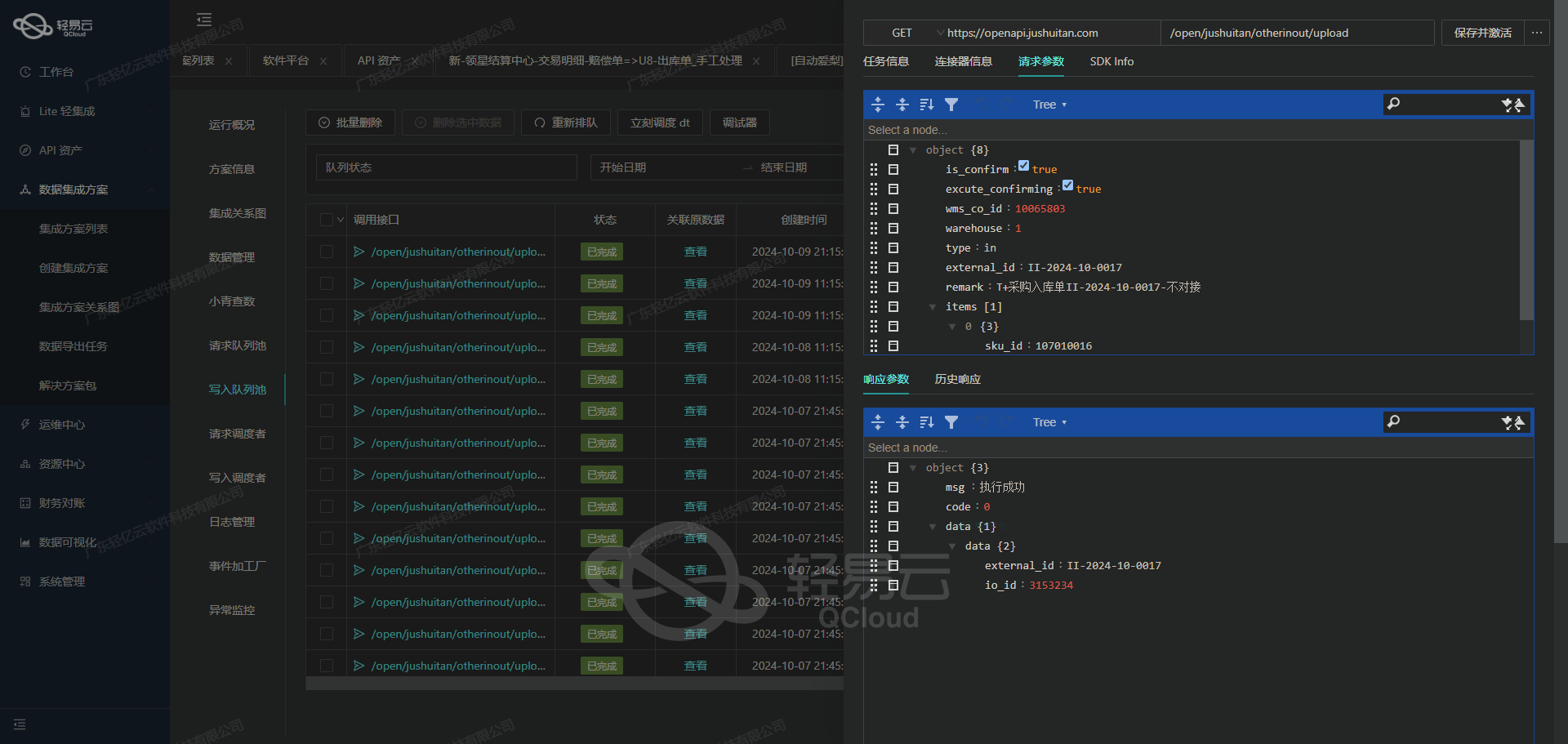

首先,为了保证从小满OKKICRM的数据能够高效无遗漏地进行抓取,我们调用了其/v1/product/sku-attribute-list API接口。为了做到准确获取所有所需数据,特别是面对高并发访问可能导致的限流问题,采用了一系列优化措施,包括分页请求和限流控制机制。在完成初步数据收集后,通过实时监控系统记录每一个接口调用的状态及日志,以便随时追踪和排查潜在异常。

然后,在将获取的数据写入到领猫平台之前,需要进行格式转换。这一过程涉及复杂的映射逻辑,因为两套系统的数据结构存在显著差异。我们运用了灵活可配置的映射规则,将从小满OKKICRM获取的SKU属性列表转化为符合领猫要求的颜色配置,并通过定制化转换功能简化这一流程。同时利用轻易云提供的一些内建工具,对常见格式差异进行了标准化处理,一方面提高效率,另一方面减少出错几率。

随后,大量清洗后的有效数据要被同步至领猫。这一环节不仅仅考验传输速度,更重要的是确保每一条记录都能准确写入。因此,我们选择使用/v1/baseconfig/updatecolor API接口来执行批量提交操作,同时设计了一整套异常处理与错误重试机制,当遇到网络波动或者服务不可用等情形时,可以自动尝试重新发送以保障最终一致性。此外,还加入了定期审计功能,周期性检查已提交的数据是否完整得当,以进一步防止遗漏或重复的问题出现。

通过上述方式,实现了小满OKKICRM与领猫之间平滑、高效且稳定的数据对接。不仅提升了业务透明度,也大幅提高了整体管理效率。在下一部分内容中,我们会更详细讲解个别实现细节,包括参数配置、具体脚本示例等,请继续关注。

调用小满OKKICRM接口/v1/product/sku-attribute-list获取并加工数据

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用小满OKKICRM接口/v1/product/sku-attribute-list获取并加工数据。

接口调用与元数据配置

首先,我们需要理解接口的基本信息和元数据配置。根据提供的元数据配置,接口调用的具体参数如下:

- API路径:

/v1/product/sku-attribute-list - 请求方法:GET

- 查询条件:字段

item_name等于"颜色" - 返回字段:

item_name(规格名称)item_id(规格ID)

元数据配置中还包含了自动填充响应和节点平铺的设置,这些设置有助于简化后续的数据处理。

数据请求与清洗

在轻易云平台上,我们首先配置一个HTTP GET请求来调用上述API。以下是具体步骤:

-

创建HTTP请求节点:

- 设置API路径为

/v1/product/sku-attribute-list - 请求方法选择GET

- 配置查询参数,使得字段

item_name等于"颜色"

- 设置API路径为

-

自动填充响应:

- 根据元数据配置中的

autoFillResponse: true,平台会自动解析并填充API响应的数据结构。这一步骤极大地简化了开发者的工作量。

- 根据元数据配置中的

-

节点平铺处理:

- 配置中提到的

beatFlat: ["node"]表示需要对返回的数据进行平铺处理,以便后续的数据转换和写入操作更加顺畅。

- 配置中提到的

数据转换与写入

在获取并清洗了源系统的数据后,下一步是对这些数据进行转换和写入目标系统。在此过程中,我们可以利用轻易云平台提供的可视化工具进行以下操作:

-

字段映射:

- 将源系统中的字段映射到目标系统所需的字段。例如,将

item_name映射为目标系统中的规格名称,将item_id映射为规格ID。

- 将源系统中的字段映射到目标系统所需的字段。例如,将

-

数据转换:

- 根据业务需求,对某些字段进行必要的转换。例如,可以将颜色值从字符串类型转换为目标系统所需的枚举类型。

-

写入目标系统:

- 配置目标系统的API或数据库连接,将转换后的数据批量写入。轻易云平台支持多种异构系统,可以无缝对接不同类型的数据库和API接口。

实时监控与调试

为了确保数据集成过程顺利进行,实时监控和调试是必不可少的。轻易云平台提供了详细的日志记录和监控功能,可以帮助我们及时发现并解决问题。例如:

- 日志记录:详细记录每一次API调用、数据清洗和转换过程中的关键步骤。

- 错误处理:当发生错误时,能够迅速定位问题所在,并提供详细的错误信息以便调试。

- 性能监控:实时监控数据流动和处理状态,确保整个流程高效运行。

通过以上步骤,我们可以高效地完成从小满OKKICRM接口获取并加工数据这一任务。在实际应用中,根据具体业务需求,还可以进一步优化和扩展这些操作,以实现更复杂的数据集成场景。

数据集成中的ETL转换与写入:从源平台到领猫API接口

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL转换,使其符合目标平台(如领猫API接口)所能接收的格式,并最终写入目标平台。这一过程至关重要,因为它直接影响数据在新系统中的可用性和一致性。

元数据配置解析

首先,我们需要理解元数据配置,以便准确地进行ETL转换。以下是我们要处理的元数据配置:

{

"api": "/v1/baseconfig/updatecolor",

"effect": "EXECUTE",

"method": "POST",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

"request": [

{"field": "code", "label": "尺码编码", "type": "string", "value": "{node_item_name}"},

{"field": "name", "label": "尺码名称", "type": "string", "value": "{node_item_name}"},

{"field": "statuz", "label": "状态", "type": "string", "describe":"1启用,0禁用,默认启用", "value":"1"},

{"field": "seq", "label":"排序", "type":"string", "describe":"正序排列,0在1前","value":"1"},

{"field":"desc","label":"描述","type":"string"},

{"field":"operator","label":"操作员","type":"string","value":"小满"}

]

}数据请求与清洗

在这个阶段,我们已经从源平台获取了原始数据,并对其进行了初步清洗。假设我们从源平台获取的数据如下:

{

"_id": 12345,

"_name": "M",

"_description": "",

"_status_code": true,

}数据转换

接下来,我们需要根据元数据配置,将这些数据转换为目标平台所需的格式。具体步骤如下:

-

字段映射:根据元数据配置,将源数据字段映射到目标字段。例如:

code和name都对应{node_item_name},即_namestatuz固定为"1"表示启用seq固定为"1"desc对应_descriptionoperator固定为"小满"

-

格式转换:确保每个字段的数据类型符合目标平台要求。例如,将布尔值

_status_code转换为字符串"1"或"0"。 -

ID 检查:根据配置中的

idCheck: true,确保每条记录都有唯一标识符。

经过上述步骤处理后的数据如下:

{

"_id": 12345,

"_name": "M",

"_description": "",

"_status_code": true,

}转换后符合领猫API接口要求的数据格式如下:

{

"code": "M",

"name": "M",

"statuz": "1",

"seq": "1",

"desc":"",

'operator':"小满"

}数据写入

最后一步是将转换后的数据通过API接口写入目标平台。根据元数据配置,我们需要使用POST方法调用 /v1/baseconfig/updatecolor 接口。

以下是一个示例HTTP请求:

POST /v1/baseconfig/updatecolor HTTP/1.1

Host: api.lingmao.com

Content-Type: application/json

{

{

code: 'M',

name: 'M',

statuz: '1',

seq: '1',

desc:'',

operator:'小满'

}

}通过上述步骤,我们成功完成了从源平台到目标平台的数据ETL转换和写入。这一过程中,充分利用了元数据配置,实现了自动化和标准化的数据处理,大大提高了效率和准确性。