小满OKKICRM数据集成到轻易云集成平台的实践案例

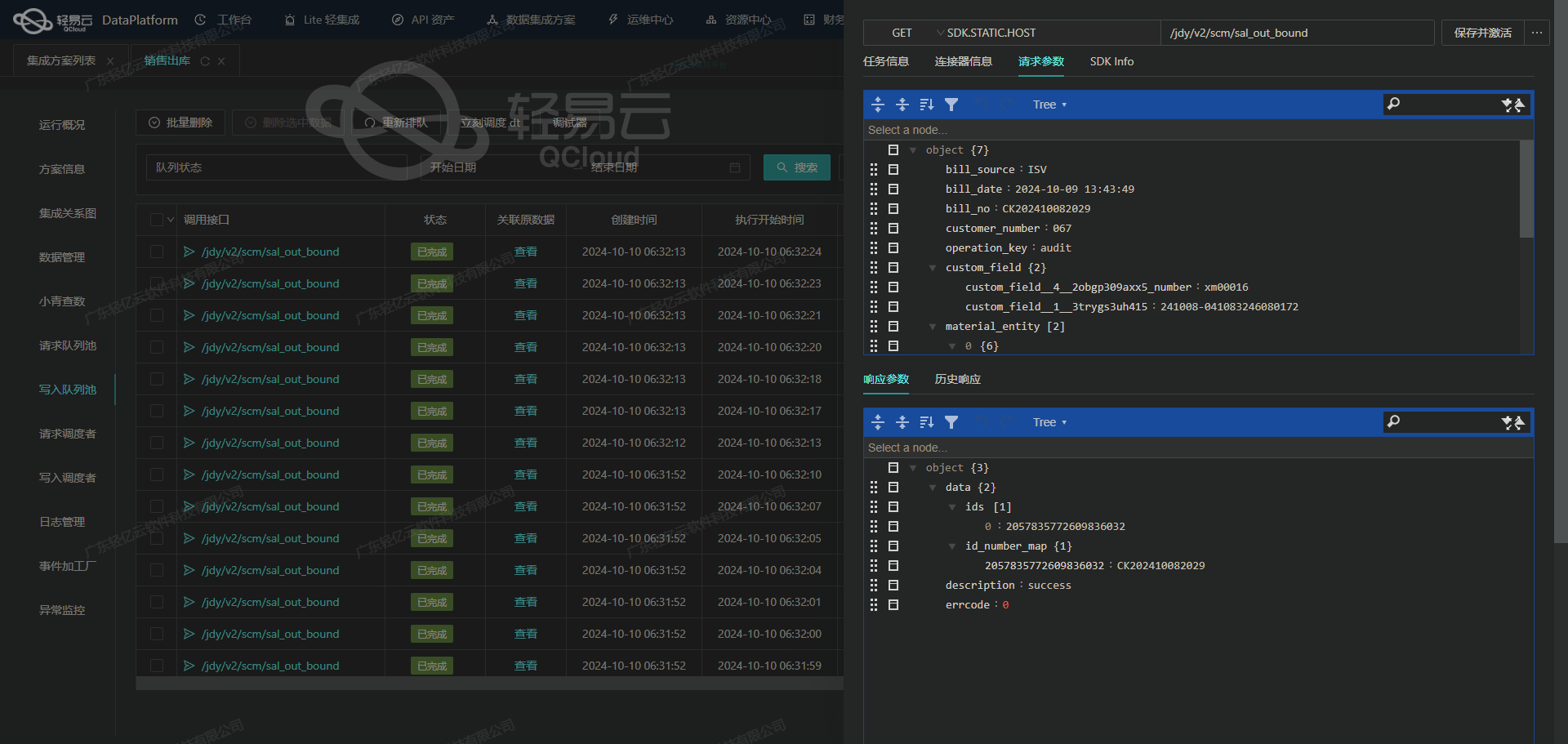

在本案例中,我们将详解如何通过轻易云集成平台实现小满OKKICRM系统的数据对接。通过API接口/v1/company/fields/selector,定时抓取客户分组信息,并快速、安全地写入轻易云集成平台。这一过程不仅能够确保数据不漏单,还能处理分页和限流问题,提供实时监控与日志记录以保障整个数据处理流程的透明性。

首先,通过调用小满OKKICRM的/v1/company/fields/selector接口,我们可以高效、稳定地获取客户分组数据。为了解决批量数据快速写入的问题,我们开发并优化了多线程写入机制,使得大规模的数据导入变得更加顺畅。同时,为了应对分页与限流等问题,设计了一套智能抓取策略,在保证系统运行平稳的前提下,提高了整体效率。

对于不同系统之间的数据格式差异,我们采用自定义映射规则,通过轻易云集成平台强大的定制化功能来转换和适配。当出现异常时,设置自动重试机制,以保证即使在网络波动或者服务器压力增大的情况下,也不影响最终的数据准确性和完整性。此外,对接过程中所产生的错误日志则被详细记录,并实时监控,以便于后续分析和改进。

综上,这个方案名为“查询小满客户分组--ok”,从初始配置到实际运行都验证了其可靠性和高效性。在该项目中应用的一些技术特性及解决方案,不仅提升了任务执行速度,还显著增强了业务透明度与可操作性。这种方法同样适用于类似场景中的其他CRM系统或第三方服务对接,从而进一步拓展企业自身的信息化水平。

调用小满OKKICRM接口/v1/company/fields/selector获取并加工数据

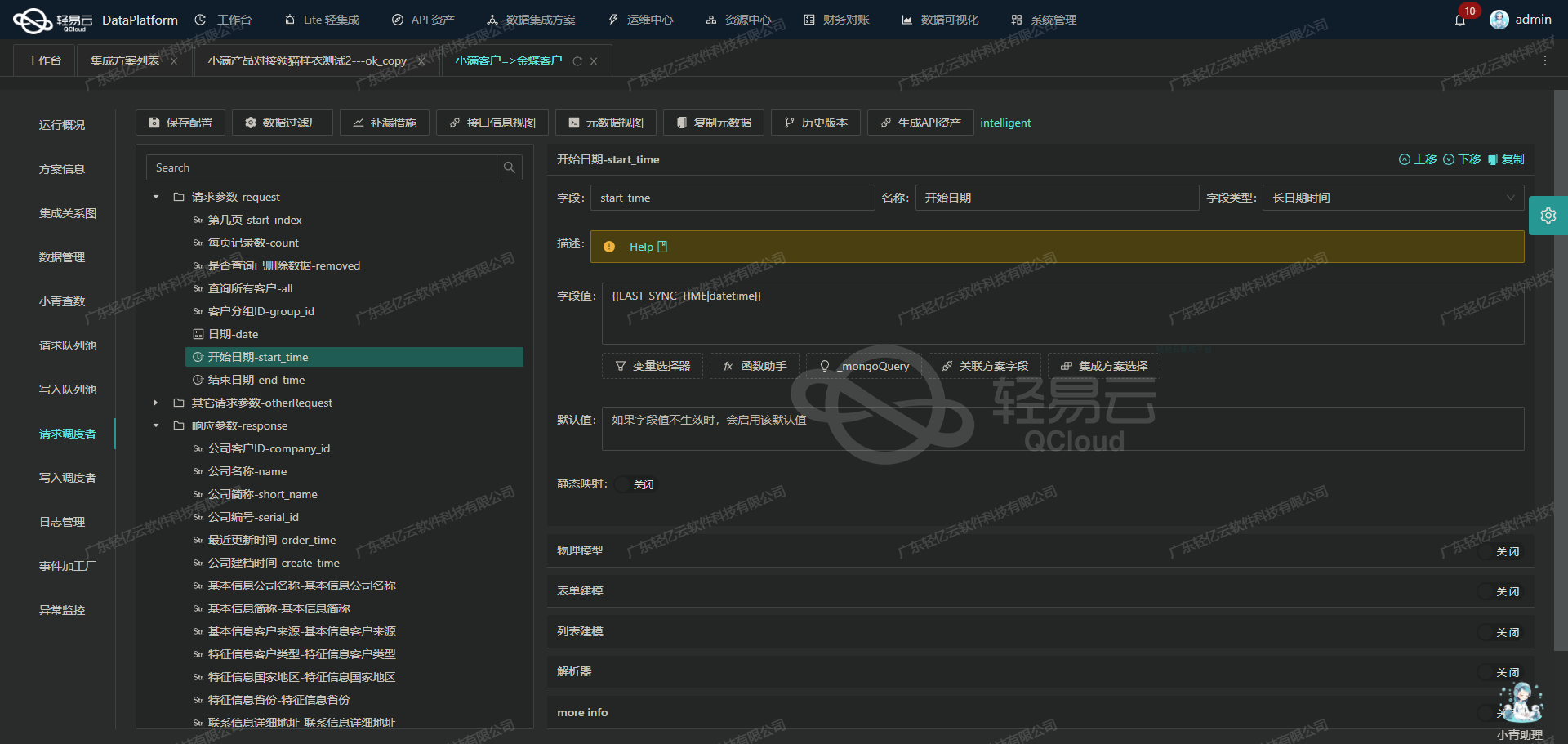

在数据集成的生命周期中,第一步是从源系统获取数据。本文将详细探讨如何通过轻易云数据集成平台调用小满OKKICRM接口/v1/company/fields/selector来获取并加工数据。

接口概述

该接口用于查询小满客户分组信息,返回的数据可以用于后续的数据清洗和转换。接口的请求方法为GET,主要参数包括字段名称和ID。

元数据配置解析

根据提供的元数据配置,我们可以了解到以下关键信息:

- API路径:

/v1/company/fields/selector - 请求方法: GET

- 字段映射:

number: nameid: id

- 请求参数:

field: group_id

实际操作步骤

-

构建请求URL

根据元数据配置,首先需要构建请求URL。由于请求方法为GET,因此参数将直接附加在URL后面。

https://api.okkicrm.com/v1/company/fields/selector?field=group_id -

发送HTTP GET请求

使用HTTP客户端(如Postman或编程语言中的HTTP库)发送GET请求。以下是使用Python的requests库发送请求的示例代码:

import requests url = "https://api.okkicrm.com/v1/company/fields/selector" params = {"field": "group_id"} response = requests.get(url, params=params) if response.status_code == 200: data = response.json() print(data) else: print(f"Failed to fetch data: {response.status_code}") -

处理响应数据

假设响应数据如下:

[ {"id": "123", "name": "Group A"}, {"id": "456", "name": "Group B"} ]我们需要对这些数据进行初步处理,以便后续的数据清洗和转换。例如,可以将这些数据存储到一个临时数据库或内存结构中,以便进一步操作。

-

数据清洗与转换

在获取到原始数据后,需要对其进行清洗和转换。这一步骤可能包括:

- 去除无效或重复的数据。

- 将字段名称标准化。

- 根据业务需求进行数据格式转换。

-

写入目标系统

最终处理后的数据需要写入到目标系统中。这可能涉及调用另一个API或者将数据存储到数据库中。在轻易云平台上,这一步骤可以通过配置相应的写入操作来实现。

示例代码:完整流程

以下是一个完整的示例代码,展示了从调用API到处理并打印结果的全过程:

import requests

def fetch_and_process_data():

url = "https://api.okkicrm.com/v1/company/fields/selector"

params = {"field": "group_id"}

response = requests.get(url, params=params)

if response.status_code == 200:

data = response.json()

processed_data = process_data(data)

print(processed_data)

else:

print(f"Failed to fetch data: {response.status_code}")

def process_data(data):

# 示例处理逻辑:去除无效项并标准化字段名称

cleaned_data = []

for item in data:

if item.get("id") and item.get("name"):

cleaned_item = {

"group_id": item["id"],

"group_name": item["name"]

}

cleaned_data.append(cleaned_item)

return cleaned_data

if __name__ == "__main__":

fetch_and_process_data()通过以上步骤,我们完成了从调用小满OKKICRM接口获取客户分组信息,到初步清洗和处理这些数据的全过程。这些操作为后续的数据转换和写入奠定了基础。

数据转换与写入:ETL在轻易云数据集成平台的应用

在数据集成生命周期中,ETL(Extract, Transform, Load)过程是关键的一步。本文将深入探讨如何利用轻易云数据集成平台,将已经集成的源平台数据进行转换,并通过API接口写入目标平台。

API接口配置与调用

在轻易云数据集成平台中,API接口的配置至关重要。以下是一个典型的元数据配置示例:

{

"api": "写入空操作",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true

}此配置表示我们将使用POST方法调用“写入空操作”API,并且需要进行ID检查(idCheck: true)。

数据转换流程

-

提取数据:从源系统提取原始数据。这一步通常涉及到对源系统API的调用,获取所需的数据集。例如,从小满客户分组查询得到的数据。

-

清洗和转换:将提取到的数据进行清洗和格式转换,使其符合目标平台API所需的格式。假设我们从源系统获取到以下JSON数据:

{ "customerGroups": [ {"id": 1, "name": "VIP客户", "members": ["Alice", "Bob"]}, {"id": 2, "name": "普通客户", "members": ["Charlie", "David"]} ] }我们需要将其转换为目标平台能够接收的格式。例如:

{ "groups": [ {"groupId": 1, "groupName": "VIP客户", "userList": ["Alice", "Bob"]}, {"groupId": 2, "groupName": "普通客户", "userList": ["Charlie", "David"]} ] } -

映射字段:确保源数据字段与目标API字段一一对应。在上述例子中,

id映射为groupId,name映射为groupName,以及members映射为userList。

写入目标平台

完成数据清洗和转换后,即可通过配置好的API接口将数据写入目标平台。以下是一个Python示例代码,用于演示如何调用轻易云API完成数据写入:

import requests

import json

# 配置API URL和Headers

api_url = 'https://api.qingyiyun.com/writeEmptyOperation'

headers = {'Content-Type': 'application/json'}

# 转换后的数据

data = {

"groups": [

{"groupId": 1, "groupName": "VIP客户", "userList": ["Alice", "Bob"]},

{"groupId": 2, "groupName": "普通客户", "userList": ["Charlie", "David"]}

]

}

# 发起POST请求

response = requests.post(api_url, headers=headers, data=json.dumps(data))

# 检查响应状态

if response.status_code == 200:

print("Data successfully written to the target platform.")

else:

print(f"Failed to write data. Status code: {response.status_code}, Response: {response.text}")ID检查机制

在上述元数据配置中,我们启用了ID检查(idCheck: true)。这意味着在写入之前,系统会验证每条记录是否包含唯一标识符,以避免重复或冲突。这一步通常通过数据库查询或缓存机制实现。

实时监控与错误处理

为了确保ETL过程顺利进行,实时监控和错误处理机制必不可少。轻易云平台提供了详细的日志记录和告警功能,可以帮助开发者快速定位并解决问题。例如,在上述代码中,我们可以添加更多的错误处理逻辑,以应对不同类型的异常情况。

通过以上步骤,我们可以高效地将源平台的数据转换并写入到目标平台,实现不同系统间的数据无缝对接。这不仅提高了业务流程的透明度和效率,也确保了数据的一致性和准确性。