钉钉数据集成到金蝶云星空的技术案例分享

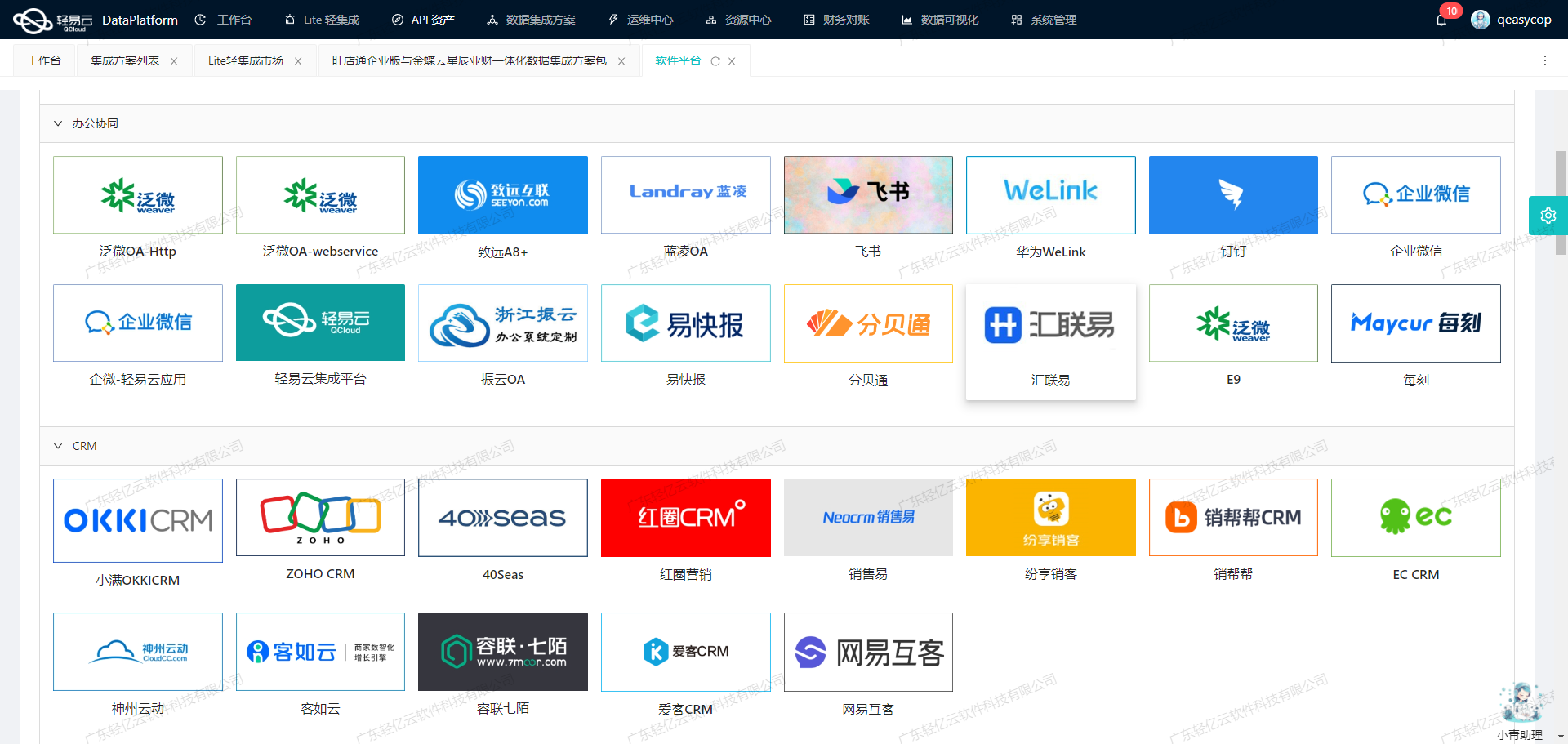

在企业信息化建设中,数据的高效流转和准确对接是关键环节。本文将聚焦于一个具体的系统对接集成案例:如何通过轻易云数据集成平台,将钉钉的数据无缝集成到金蝶云星空,实现Ioan_新借款单(费用申请单)OK方案。

首先,我们需要解决的是如何确保从钉钉获取的数据不漏单,并且能够定时可靠地抓取钉钉接口数据。为此,我们利用了钉钉提供的API接口v1.0/yida/processes/instances,通过定时任务机制,批量抓取所需的数据。这一过程不仅保证了数据的完整性,还提升了处理效率。

其次,在将大量数据快速写入到金蝶云星空时,我们采用了其提供的batchSave API接口。该接口支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标系统中,从而大幅度提升了整体业务处理的时效性。

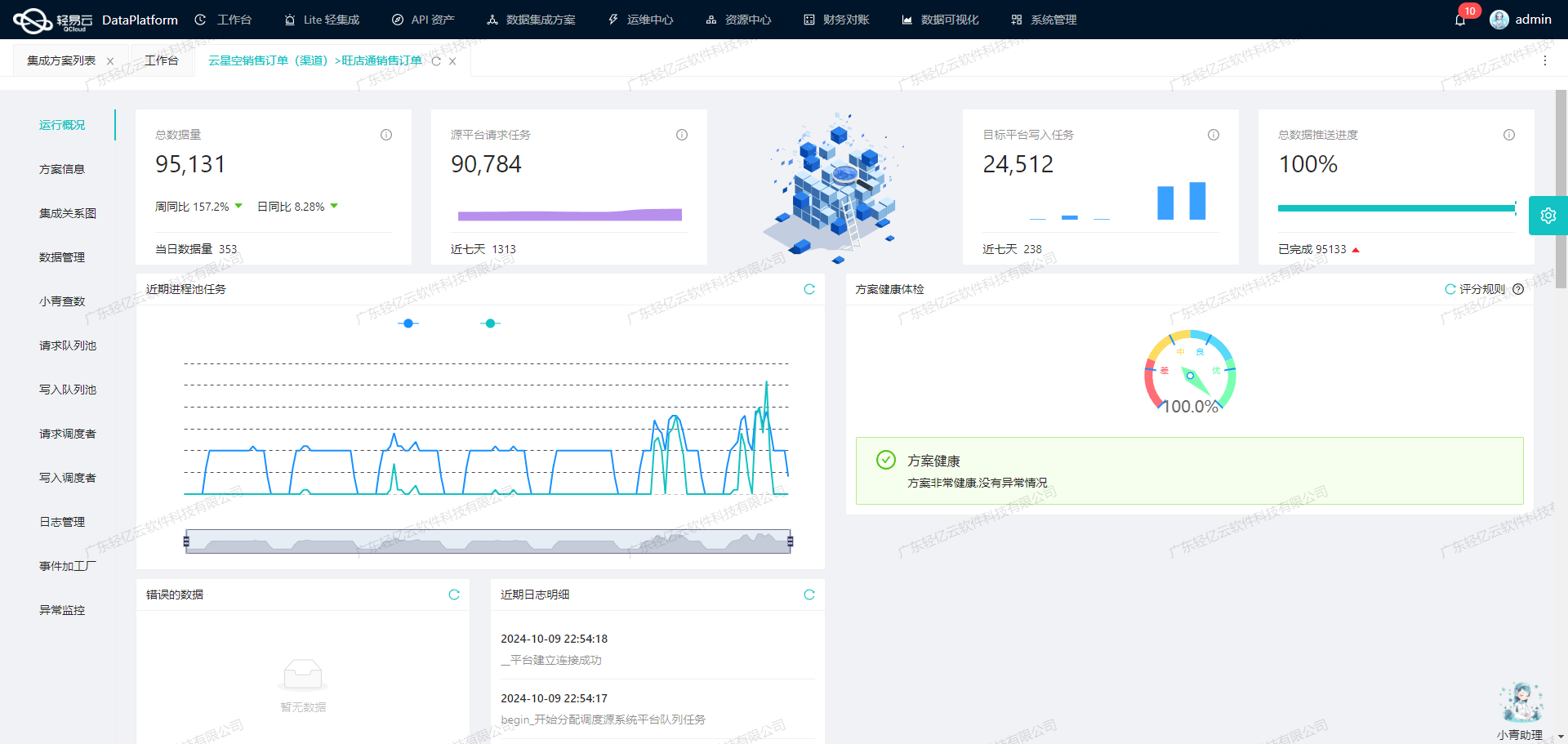

为了确保整个数据集成过程中的透明度和可控性,我们还引入了集中监控和告警系统。该系统实时跟踪每个数据集成任务的状态和性能,一旦出现异常情况,可以及时发现并处理,确保业务流程不中断。此外,通过可视化的数据流设计工具,使得整个数据处理过程更加直观和易于管理。

在实际操作过程中,还需要特别注意处理钉钉与金蝶云星空之间的数据格式差异。我们通过自定义的数据转换逻辑,对不同平台间的数据结构进行适配,以满足特定业务需求。同时,为应对分页和限流问题,我们设计了一套完善的错误重试机制,确保在各种情况下都能顺利完成数据对接任务。

总之,通过上述技术手段和策略,我们成功实现了Ioan_新借款单(费用申请单)OK方案,将来自钉钉的数据高效、准确地集成到了金蝶云星空,为企业的信息化建设提供了有力支持。在后续章节中,我们将详细介绍具体实施步骤及技术细节。

调用钉钉接口v1.0/yida/processes/instances获取并加工数据

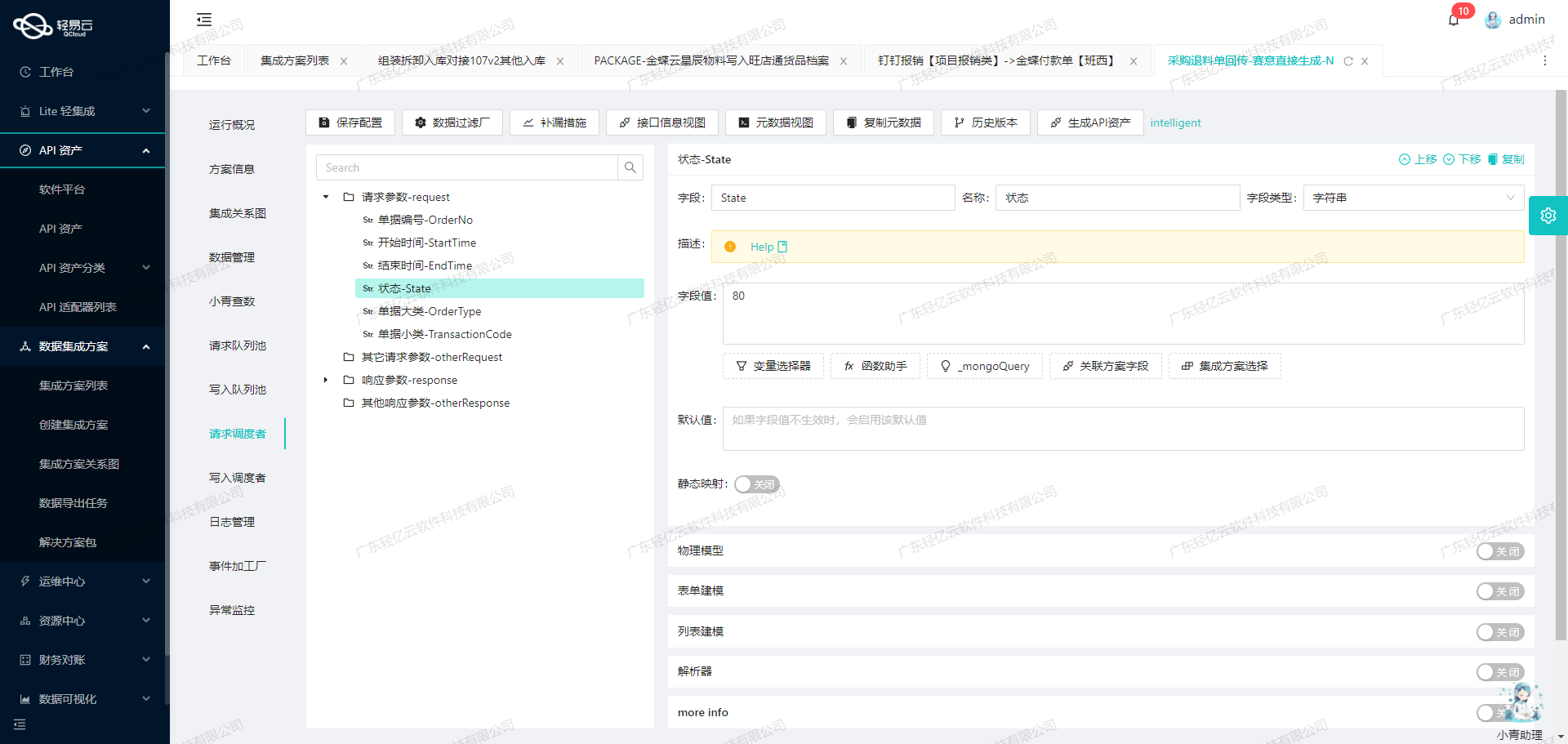

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过调用钉钉接口v1.0/yida/processes/instances来获取并加工数据,以实现高效的数据集成。

钉钉接口配置与请求参数

首先,我们需要配置钉钉接口的元数据,以确保能够正确地发起请求并获取所需的数据。以下是关键的请求参数及其配置:

- 分页页码 (

pageNumber):用于控制分页,从而避免一次性拉取过多数据导致性能问题。 - 分页大小 (

pageSize):每次请求返回的数据条数。 - 应用ID (

appType) 和 应用秘钥 (systemToken):用于验证和授权访问钉钉API。 - 用户ID (

userId):指定具体用户的操作权限。 - 语言 (

language):支持中文(zh_CN)和英文(en_US)。 - 表单ID (

formUuid):指定要查询的表单类型。 - 条件过滤 (

searchFieldJson):如部门过滤等,用于精确筛选数据。 - 时间范围过滤(

createFromTimeGMT,createToTimeGMT):根据创建时间进行筛选,确保只获取特定时间段内的数据。

这些参数通过POST方法传递给API,确保请求能够准确无误地执行。

数据清洗与转换

在成功调用API并获取到原始数据后,需要对这些数据进行清洗和转换,以便后续处理和写入目标系统。以下是几个关键步骤:

-

去重与校验:

- 使用唯一标识符(如

processInstanceId)进行去重,确保不会重复处理相同的数据实例。 - 校验必要字段是否存在且符合预期格式,如标题(

title)、流程状态(instanceStatus)等。

- 使用唯一标识符(如

-

格式转换:

- 将日期时间字段统一转换为标准格式,便于后续处理。例如,将创建时间从字符串格式转换为标准的日期对象。

- 根据业务需求,对特定字段进行重新映射或计算。例如,将审批结果字段(

approvedResult)从枚举值转换为更具可读性的文本描述。

-

异常处理与日志记录:

- 对于无法解析或不符合预期的数据,记录详细日志以便后续排查和修正。同时,可以设置告警机制,在出现异常时及时通知相关人员。

高效的数据抓取策略

为了保证高效、可靠地抓取大量数据,可以采用以下策略:

-

分页抓取:

- 通过设置合理的分页大小和页码,分批次拉取数据,有效降低单次请求的负载,同时避免超时或限流问题。

-

定时任务调度:

- 配置定时任务,定期调用API以保持数据同步。这可以通过轻易云平台提供的调度功能实现,例如每天凌晨自动抓取前一天的新建或更新实例。

-

限流与重试机制:

- 在遇到API限流或网络异常时,实现自动重试机制,并在多次失败后记录错误日志以便人工干预。这可以显著提高整体抓取过程的稳定性和可靠性。

实例状态监控与优化

在整个过程中,通过轻易云平台提供的集中监控和告警系统,可以实时跟踪每个集成任务的状态和性能。一旦发现异常情况,如长时间未完成、频繁失败等,可以及时采取措施进行优化调整。此外,通过分析历史运行日志,还可以不断优化参数配置,提高整体效率。

综上所述,通过合理配置元数据、实施有效的数据清洗与转换策略,以及采用高效的数据抓取方案,可以充分利用轻易云平台实现对钉钉接口数据的高效集成,为企业业务提供强有力的数据支持。

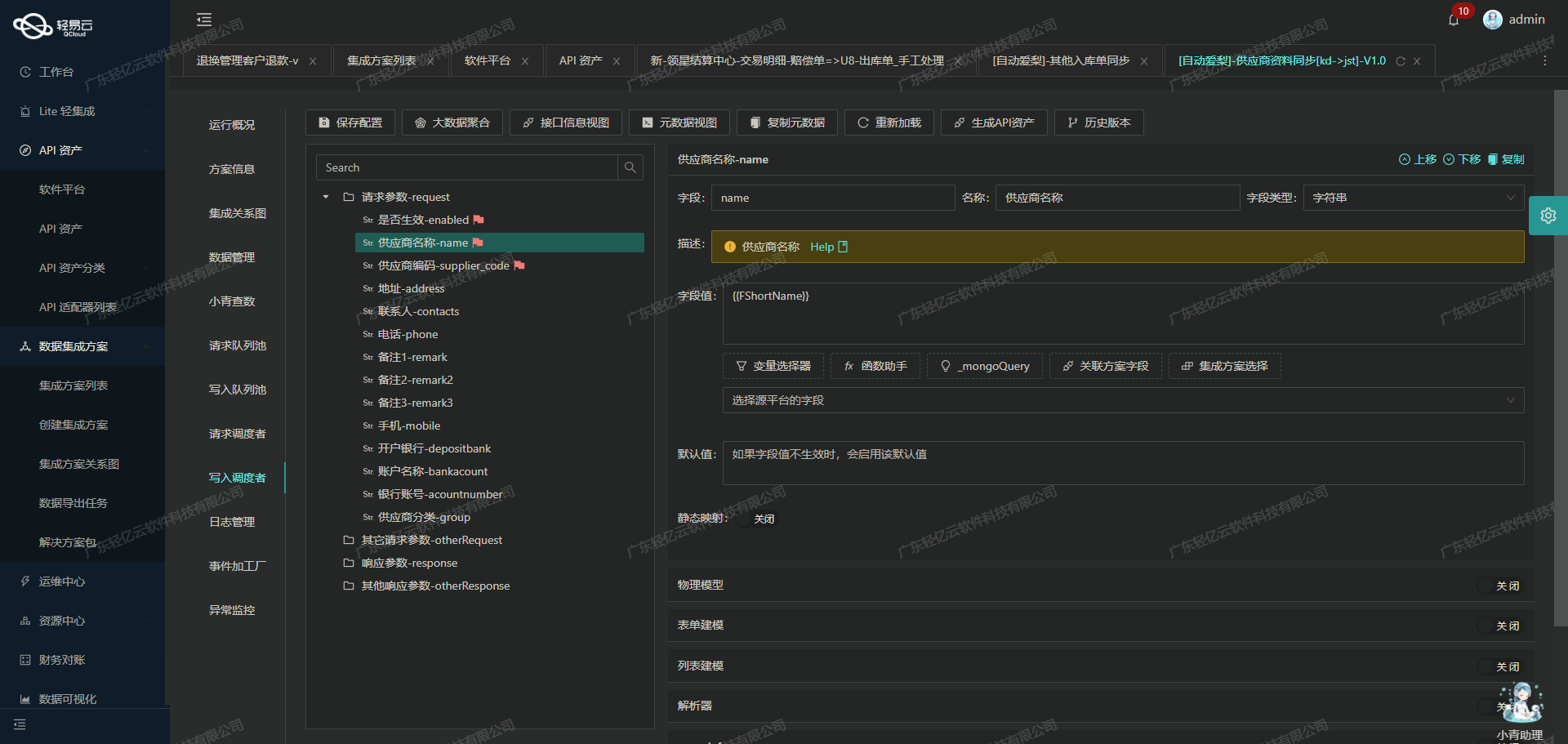

集成数据转换与写入金蝶云星空API接口

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL转换,并转为目标平台金蝶云星空API接口所能够接收的格式,最终写入目标平台。以下将详细介绍如何通过轻易云数据集成平台实现这一过程。

数据转换配置

在数据转换过程中,我们首先要进行元数据配置,以确保数据能够正确地映射到金蝶云星空API接口所需的字段格式。以下是关键字段的配置示例:

-

单据编号(FBillNo):

{"field":"FBillNo","label":"单据编号","type":"string","value":"{textField_kspgl3w6}(FYSQ)"}这里我们将

textField_kspgl3w6字段的值加上后缀“(FYSQ)”作为单据编号。 -

日期(FDate):

{"field":"FDate","label":"日期","type":"string","value":"_function FROM_UNIXTIME( ( {dateField_kmo8rpow} \/ 1000 ) ,'%Y-%m-%d' )"}日期字段需要从UNIX时间戳转换为标准日期格式。

-

申请人(FStaffID):

{"field":"FStaffID","label":"申请人","type":"string","parser":{"name":"ConvertObjectParser","params":"FSTAFFNUMBER"},"value":"{textField_krjz186m}"}使用

ConvertObjectParser解析器,将申请人的ID转换为对应的金蝶云星空系统中的员工编号。 -

申请部门(FDeptID):

{"field":"FDeptID","label":"申请部门","type":"string","parser":{"name":"ConvertObjectParser","params":"FNumber"},"value":"{{tableField_ks8a1ak1.textField_kwjz1agw}}"}同样地,使用解析器将部门信息进行转换。

API接口调用

配置完成后,接下来是通过API接口将处理后的数据写入金蝶云星空。我们使用批量保存接口batchSave,并设置请求方法为POST:

{"api":"batchSave","method":"POST"}为了确保数据完整性和一致性,我们启用ID检查,并设定每次批量保存的行数:

{"idCheck":true,"operation":{"method":"batchArraySave","rows":10,"rowsKey":"array"}}具体的请求体结构如下:

{

"FormId": "ER_ExpenseRequest",

"Operation": "BatchSave",

"IsAutoSubmitAndAudit": true,

"IsVerifyBaseDataField": false,

"Model": {

"FBillNo": "{textField_kspgl3w6}(FYSQ)",

"FDate": "_function FROM_UNIXTIME( ( {dateField_kmo8rpow} \/ 1000 ) ,'%Y-%m-%d' )",

...

"FEntity": [

{

"FExpenseItemID": "{{tableField_ks8a1ak1.textField_ks8a1ak6}}",

...

}

]

}

}数据写入与监控

在批量写入过程中,轻易云平台提供了高吞吐量的数据写入能力,可以快速将大量数据集成到金蝶云星空。同时,通过实时监控和告警系统,我们可以随时跟踪任务状态和性能,确保数据处理过程顺利进行。

此外,为了应对钉钉与金蝶云星空之间的数据格式差异,我们可以自定义数据转换逻辑,以适应特定业务需求。例如,对于日期和金额等字段,可以使用自定义函数进行格式化处理。

异常处理与重试机制

在对接过程中,可能会遇到一些异常情况,如网络故障或接口调用失败。此时,可以通过设置错误重试机制来提高系统的可靠性。例如,当某次API调用失败时,可以自动重新尝试提交请求,直到成功为止。

总结来说,通过合理配置元数据、调用API接口、实时监控以及异常处理机制,可以高效地完成从钉钉到金蝶云星空的数据集成任务。这不仅提升了业务透明度和效率,也确保了数据的一致性和准确性。