按需查询:金蝶辅助资料-区信息集成到轻易云平台的技术探讨

在进行企业数据整合与共享时,构建可靠的数据对接方案是关键。本文将分享一个具体场景:如何将金蝶云星空中的辅助资料(区信息)高效、安全地集成到轻易云数据集成平台。

在这个案例中,我们主要关注几个方面:

- 确保数据不漏单:通过精准调用

executeBillQuery接口,从金蝶云星空获取全量区信息。 - 批量写入和定时抓取:采用轻易云的批处理机制,实现大规模数据的快速导入,并设置定时任务保证数据的实时性。

- 分页与限流问题:针对API调用过程中的分页处理和限流控制,设计了一套优雅解决方案以确保稳定运行。

- 异常处理及重试机制:为应对可能出现的数据传输错误或网络波动情况,内置了可靠的异常捕获和自动重试逻辑。

API接口配置

首先需要说明的是双方系统API端点:

- 金蝶云星空获取数据的API:

executeBillQuery - 轻易云集成平台写入操作 API:

写入空

数据抽取步骤

从金蝶云星空提取特定时间段内新增或更新过的辅助资料实例,将这些数据转换成适用于轻易云平台格式,同时注意字段映射的一致性。通过调度任务周期性地触发executeBillQuery请求,把查得的数据按页分批次拉取并缓存,通过业务逻辑整合后再推送至目标存储库。

{

"request": {

"filterCondition": "...",

// 查询条件,根据业务需求设定,用于定义需要提取的数据范围。

"pageSize": 100,

"pageNumber": 1,

},

...

}编排与执行流程优化

缓解由于大量请求导致服务器压力的问题,则引入参数化配置来灵活调整每个参数值。当接口响应包含超过规定阈值条目的记录数,可利用编程手段有序分片、增量同步达到最终一致性要求。同时,为进一步提升性能,加速结果返回,还实现了并行计算模式下多线程拆分各小块再汇总上报策略。

实时监控与日志体系

为保障整个过程透明可追溯,在关键节点布置消息/日志收集器,对每一次操作详细记录。一旦发生错误事件,例如因无效输入导致JSON解析失败等情况,立即启动补救措施纠正回滚重新发送请求,直到成功结束签

调用源系统金蝶云星空接口executeBillQuery获取并加工数据

在数据集成的生命周期中,调用源系统接口获取数据是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用金蝶云星空的executeBillQuery接口来获取并加工数据。

接口配置与调用

首先,我们需要了解executeBillQuery接口的基本配置和调用方式。根据元数据配置,接口采用POST方法进行请求,主要用于查询操作(effect为QUERY)。

{

"api": "executeBillQuery",

"effect": "QUERY",

"method": "POST",

"number": "FDataValue",

"id": "FEntryID",

"name": "FNumber"

}请求参数解析

请求参数分为两部分:request和otherRequest。其中,request部分定义了主要的查询字段:

[

{"field":"FEntryID","label":"FEntryID","type":"string","describe":"id","value":"FEntryID"},

{"field":"FNumber","label":"编码","type":"string","describe":"编码","value":"FNumber"},

{"field":"FDataValue","label":"名称","type":"string","describe":"名称","value":"FDataValue"}

]这些字段分别对应金蝶系统中的ID、编码和名称。在实际调用时,我们需要确保这些字段能够正确映射到目标系统的数据结构中。

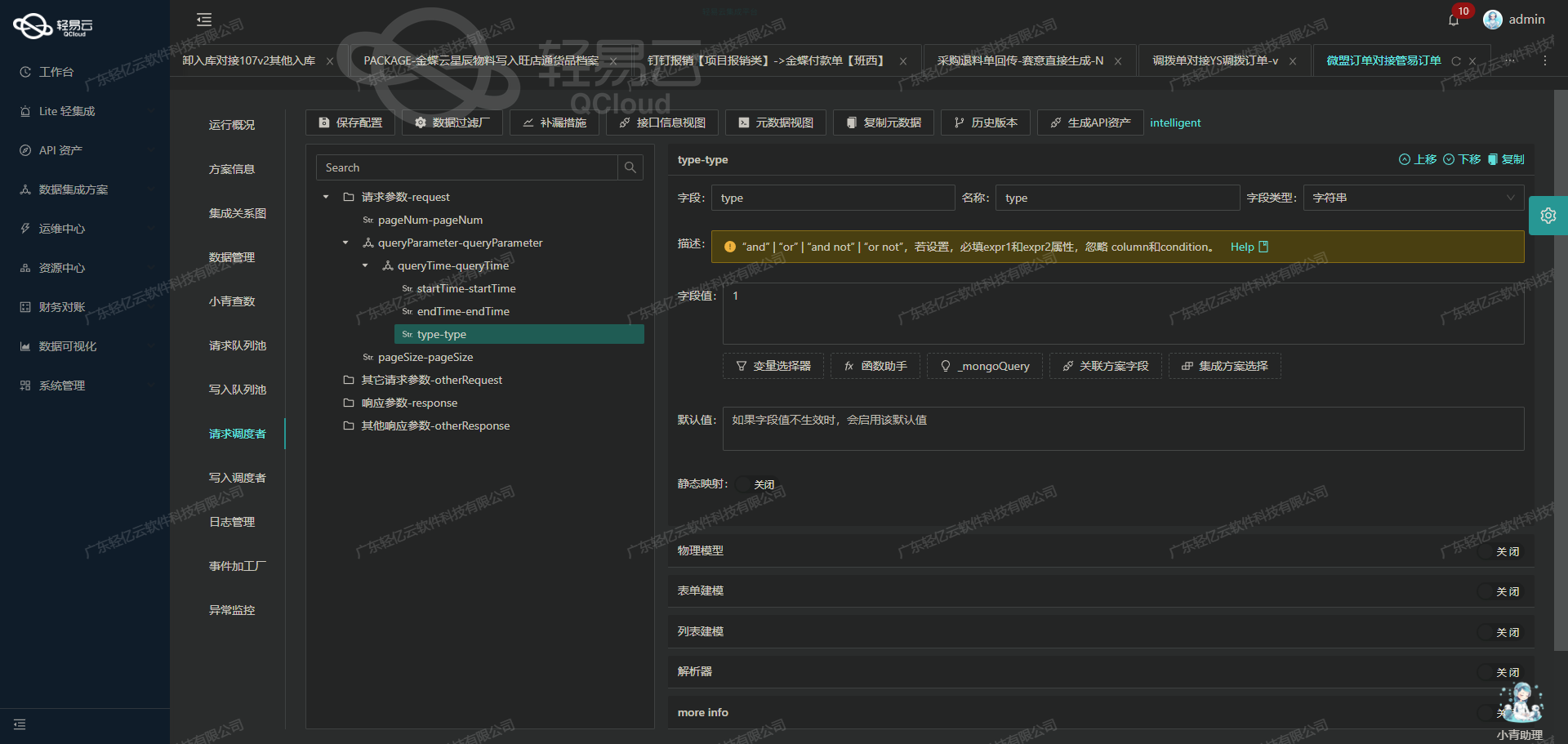

分页与过滤条件

为了提高查询效率和灵活性,我们可以使用分页参数和过滤条件:

[

{"field":"Limit","label":"最大行数","type":"string","describe":"金蝶的查询分页参数","value":"2000"},

{"field":"StartRow","label":"开始行索引","type":"string","describe":"金蝶的查询分页参数","value":"{PAGINATION_START_ROW}"},

{"field":"TopRowCount","label":"返回总行数","type":"int","describe":"金蝶的查询分页参数"},

{"field":"FilterString","label":"过滤条件","type":"string","describe":"示例写法 FSupplierId.FNumber = 'VEN00010' and FApproveDate>=","value":"FId.FNumber='Citys'"}

]其中,Limit和StartRow用于控制每次查询的数据量和起始位置;FilterString则用于指定复杂的过滤条件。例如,可以通过设置特定的供应商编号或审批日期来筛选数据。

字段集合与表单ID

此外,我们还需要指定需查询的字段集合和业务对象表单ID:

[

{"field":"FieldKeys","label":"需查询的字段key集合","type":"array","describe":"金蝶分录主键ID格式:FPOOrderEntry_FEntryId,其它格式 FPurchaseOrgId.FNumber", "parser":{"name": "ArrayToString", "params": ","}},

{"field": "FormId", "label": "业务对象表单Id", "type": "string", "describe": "必须填写金蝶的表单ID如:PUR_PurchaseOrder", "value": "BOS_ASSISTANTDATA_DETAIL"}

]在这里,FieldKeys定义了我们感兴趣的数据字段,而FormId则指定了具体的业务对象表单ID(例如:BOS_ASSISTANTDATA_DETAIL)。

实际应用案例

假设我们需要从金蝶云星空中获取区信息,并将其集成到目标系统中。我们可以按照以下步骤进行操作:

-

配置请求参数:

{ "Limit": "2000", "StartRow": "{PAGINATION_START_ROW}", "FilterString": "FId.FNumber='Citys'", "FieldKeys": ["FEntryID", "FNumber", "FDataValue"], "FormId": "BOS_ASSISTANTDATA_DETAIL" } -

发送请求: 使用轻易云平台提供的可视化界面或API工具发送POST请求,并传入上述配置参数。

-

处理响应数据: 响应数据会自动填充到预定义的数据结构中,我们可以进一步对其进行清洗、转换等操作,以满足业务需求。

通过以上步骤,我们成功地调用了金蝶云星空的接口并获取了所需的数据。这不仅简化了数据集成过程,还提高了系统间的数据交互效率。

将金蝶辅助资料-区信息集成至轻易云平台的ETL转换与写入

在数据集成生命周期的第二步,我们将重点探讨如何将已经从源平台(金蝶辅助资料-区信息)提取的数据进行ETL转换,并通过轻易云集成平台API接口写入目标平台。此过程涉及数据清洗、转换以及最终的数据写入操作。

数据清洗与转换

首先,数据清洗是确保数据质量的关键步骤。在这个阶段,我们需要对从金蝶提取的数据进行必要的校验和处理,以确保其符合目标平台的要求。例如,去除重复数据、处理缺失值、标准化数据格式等。以下是一个示例代码片段,用于清洗和转换金蝶辅助资料-区信息:

import pandas as pd

# 读取从金蝶提取的数据

data = pd.read_csv('kingdee_data.csv')

# 去除重复行

data.drop_duplicates(inplace=True)

# 处理缺失值(例如填充或删除)

data.fillna(method='ffill', inplace=True)

# 标准化数据格式(例如日期格式)

data['date'] = pd.to_datetime(data['date'], format='%Y-%m-%d')

# 转换为目标平台所需的格式

transformed_data = data.rename(columns={

'old_column_name': 'new_column_name'

})数据写入目标平台

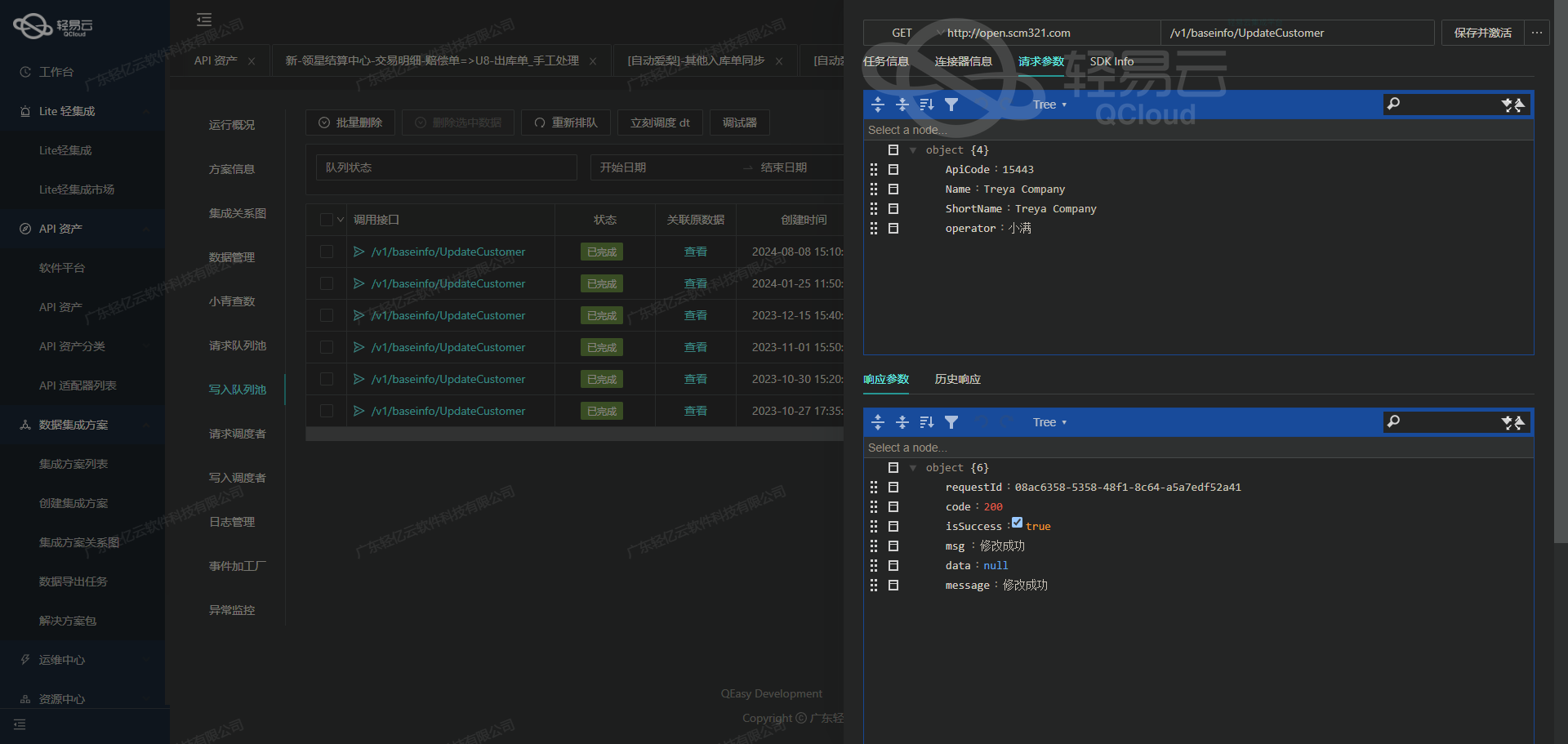

接下来,我们需要将清洗和转换后的数据通过轻易云集成平台API接口写入目标平台。根据元数据配置,我们使用POST方法进行数据写入,并且需要进行ID检查以确保数据唯一性。

以下是一个示例代码片段,展示如何使用Python的requests库调用轻易云集成平台API接口:

import requests

import json

# API接口配置

api_url = "https://api.qingyiyun.com/execute"

headers = {

"Content-Type": "application/json"

}

# 将转换后的数据转为JSON格式

payload = transformed_data.to_json(orient='records')

# 发送POST请求写入数据

response = requests.post(api_url, headers=headers, data=payload)

if response.status_code == 200:

print("Data successfully written to the target platform.")

else:

print(f"Failed to write data. Status code: {response.status_code}")在上述代码中,我们首先定义了API接口的URL和请求头,然后将转换后的DataFrame转为JSON格式,并通过POST请求将其发送到目标平台。如果响应状态码为200,则表示数据成功写入。

ID检查与唯一性验证

在实际操作中,ID检查是确保数据唯一性的重要步骤。我们可以在发送请求之前,对每条记录进行ID检查,以避免重复插入。以下是一个示例代码片段,用于ID检查:

def check_id_uniqueness(data):

unique_ids = set()

for record in data:

if record['id'] in unique_ids:

raise ValueError(f"Duplicate ID found: {record['id']}")

unique_ids.add(record['id'])

# 检查ID唯一性

check_id_uniqueness(transformed_data.to_dict(orient='records'))通过以上步骤,我们可以确保每条记录在目标平台中的唯一性,从而避免重复插入导致的数据混乱。

总结

通过上述技术案例,我们详细探讨了如何将从金蝶提取的数据进行ETL转换,并通过轻易云集成平台API接口写入目标平台。这一过程不仅包括了必要的数据清洗和转换,还涉及了API调用及ID检查等关键步骤,为实现高效、可靠的数据集成提供了全面的技术支持。