钉钉数据集成到MySQL:跨部门费用报销案例分享

在企业管理中,跨部门费用报销是一个复杂且关键的环节。为了提升数据处理的效率和透明度,我们采用了轻易云数据集成平台,将钉钉系统中的费用报销数据无缝对接到MySQL数据库中。本次案例分享将详细介绍如何通过高效的数据集成方案,实现从“钉钉-跨部门费用报销”到“BI崛起-跨部门费用报销”的转变。

首先,我们利用轻易云平台强大的高吞吐量数据写入能力,确保大量的报销数据能够快速且准确地从钉钉系统导入到MySQL数据库。这一特性极大地提升了数据处理的时效性,使得业务决策可以基于最新的数据进行调整。

在具体实施过程中,通过调用钉钉API接口topapi/processinstance/get,我们定时可靠地抓取了所需的费用报销数据。同时,为了应对分页和限流问题,我们设计了一套完善的数据抓取策略,确保每一条记录都能被完整获取,不漏单、不重复。

此外,为了保证数据质量,我们引入了集中监控和告警系统。该系统实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,立即触发告警并启动错误重试机制。这种实时监控与日志记录功能,使得整个集成过程透明可控,大幅降低了因数据问题导致的业务风险。

在将抓取到的数据写入MySQL时,我们特别注意到了两者之间的数据格式差异,并通过自定义的数据转换逻辑进行适配。同时,通过MySQL API execute实现批量写入操作,有效提高了写入效率,并确保所有数据准确存储。

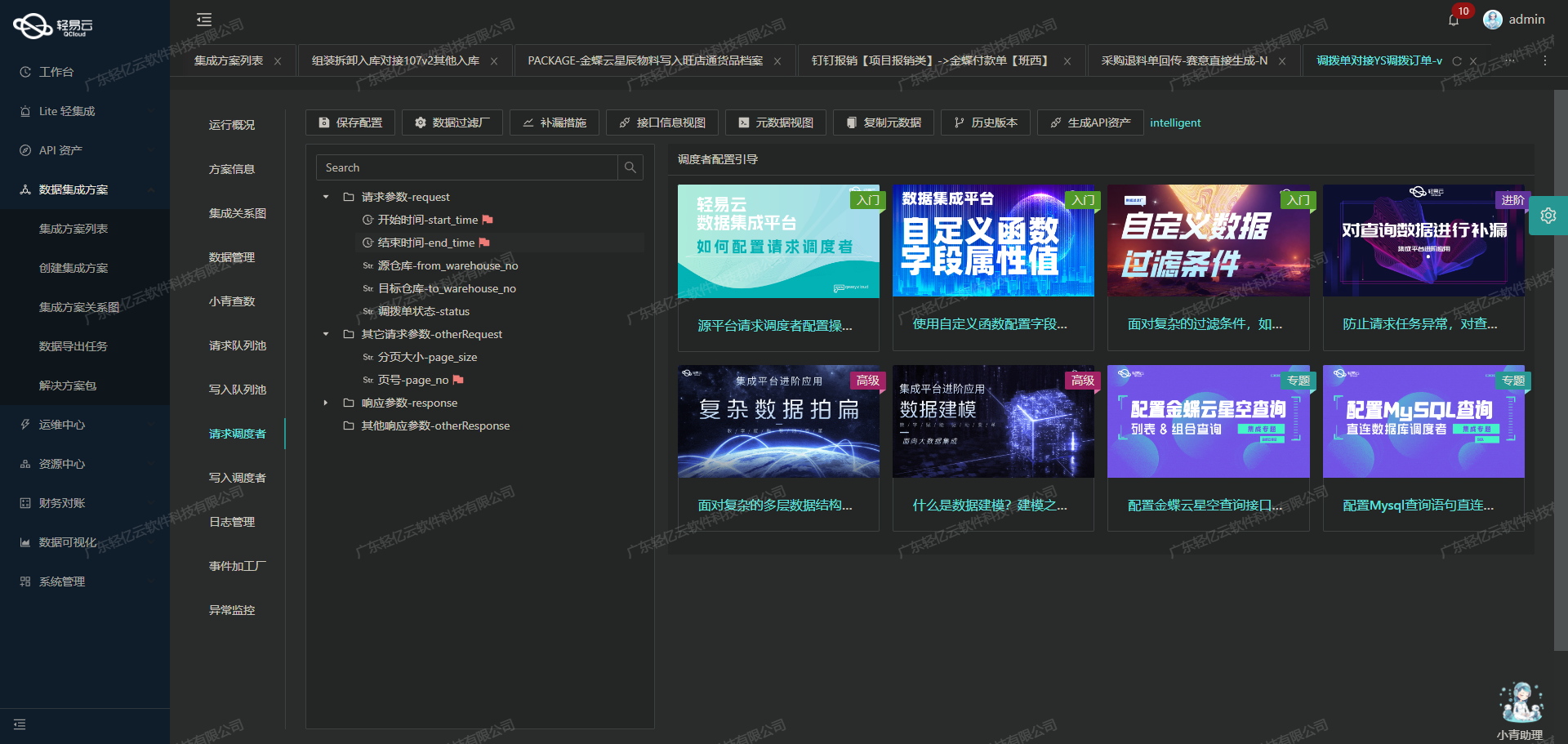

最后,通过轻易云提供的可视化数据流设计工具,我们直观地构建并管理整个数据集成流程,使得复杂的数据处理过程变得简单明了。这不仅提升了开发效率,也为后续维护工作提供了极大的便利。

本次案例展示的不仅是技术上的实现,更是对业务流程优化的一次成功实践。接下来章节将深入探讨具体实施细节及技术要点。

调用钉钉接口topapi/processinstance/get获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统钉钉接口topapi/processinstance/get以获取并加工数据。这一步骤至关重要,因为它决定了后续数据处理和写入的基础。以下将详细探讨如何高效地调用该接口,并对获取的数据进行初步加工。

接口配置与请求参数

首先,我们需要配置好API接口及其请求参数。根据元数据配置,topapi/processinstance/get接口采用POST方法进行调用,其主要参数包括:

process_code: 审批流的唯一码,用于标识特定的审批流程。start_time: 审批实例开始时间,Unix时间戳,单位为毫秒。end_time: 审批实例结束时间,Unix时间戳,单位为毫秒。size: 分页参数,每页大小,最多传20。cursor: 分页查询的游标,最开始传0,后续传返回参数中的next_cursor值。

这些参数确保了我们能够精确地定位和分页获取所需的数据。

数据请求与清洗

在实际操作中,我们通常会设置一个定时任务,以固定频率调用该接口,从而确保数据的及时性和完整性。例如,可以每小时同步一次数据,通过设置start_time和end_time来限定查询范围。以下是一个简化后的请求示例:

{

"process_code": "PROC-46EEC275-6C7A-42B8-AAC9-EF828A7498DC",

"start_time": "{LAST_SYNC_TIME}*1000",

"end_time": "{CURRENT_TIME}*1000",

"size": "20",

"cursor": "0"

}在接收到响应后,需要对数据进行初步清洗和转换。例如,将Unix时间戳转换为可读日期格式,对字段名称进行标准化处理等。这些操作可以通过轻易云平台提供的自定义数据转换逻辑来实现。

分页与限流处理

由于钉钉接口存在分页限制,每次最多只能返回20条记录,因此需要实现分页机制。在首次请求时,将cursor设为0,并在后续请求中使用上一次响应中的next_cursor值继续查询,直到没有更多记录为止。此外,还需注意API调用频率限制,通过合理设置重试机制和限流策略来避免触发钉钉的防刷机制。

数据质量监控与异常处理

为了确保集成过程中的数据质量,可以利用轻易云平台的数据质量监控功能,对每次同步的数据进行校验。例如,可以检查关键字段是否为空、数值是否在合理范围内等。一旦发现异常情况,应及时记录日志并触发告警,以便快速定位问题并采取相应措施。同时,为了提高系统的健壮性,还应设计完善的错误重试机制,在网络故障或其他异常情况下自动重试请求。

实时监控与日志记录

轻易云平台提供了集中的监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。通过可视化界面,可以直观地查看各个环节的数据流动情况,并及时发现潜在问题。此外,还可以启用详细的日志记录功能,对每次API调用及其响应结果进行全面记录,为后续排查问题提供依据。

综上所述,通过合理配置API接口、精细化管理分页与限流、强化数据质量监控以及实时监控与日志记录,我们可以高效地从钉钉系统中获取所需数据,并为后续的数据转换与写入打下坚实基础。这不仅提升了业务透明度,也极大提高了整体效率。

钉钉跨部门费用报销数据集成到MySQL的ETL转换过程

在数据集成平台的生命周期中,将已经集成的源平台数据进行ETL转换并写入目标平台是至关重要的一步。本文将详细探讨如何将钉钉跨部门费用报销的数据,通过ETL转换,最终写入目标平台MySQL。

数据请求与清洗

首先,从钉钉API接口获取原始数据是整个流程的起点。调用钉钉接口topapi/processinstance/get获取费用报销相关的数据,并且处理接口的分页和限流问题以确保数据完整性。在获取数据时,需特别注意API返回的数据格式和字段类型,这将直接影响后续的ETL过程。

数据转换与映射

接下来,进入ETL的核心部分——数据转换。根据提供的元数据配置,将源数据字段映射到目标平台MySQL所需的字段格式。以下是关键步骤:

-

字段映射:根据元数据配置,将钉钉返回的数据字段映射到MySQL表对应的字段。例如:

bfn_id映射到bfn_idapplicant_department映射到申请人所属部门month映射到所属月份- 其他字段依次类推

-

数据类型转换:确保每个字段的数据类型符合MySQL数据库要求。比如,将字符串类型的数据如日期、金额等格式化为MySQL支持的格式。

-

自定义转换逻辑:根据业务需求,可能需要对某些字段进行自定义处理。例如,将多个相关字段组合生成一个新的计算值,或对某些特殊字符进行转义处理等。

数据写入目标平台

在完成数据转换后,最后一步是将处理后的数据批量写入到MySQL数据库。以下是具体步骤:

-

构建SQL语句:根据元数据配置中的SQL模板,构建批量插入或更新的SQL语句。例如:

REPLACE INTO inter_department_reimbursement (bfn_id,applicant_department,month,reimbursement_description,total_amount,receipt_method,other_receipt_account,payee_name,receipt_account,receipt_bank,financial_payment_method,actual_payment_amount,cost_department,purpose_details,corresponding_subjects,amount,create_time, finish_time, originator_userid, originator_dept_id, status, result, business_id, originator_dept_name, biz_action) VALUES (:bfn_id,:applicant_department,:month,:reimbursement_description,:total_amount,:receipt_method,:other_receipt_account,:payee_name,:receipt_account,:receipt_bank,:financial_payment_method,:actual_payment_amount,:cost_department,:purpose_details,:corresponding_subjects,:amount,:create_time, :finish_time, :originator_userid, :originator_dept_id, :status, :result, :business_id, :originator_dept_name, :biz_action); -

高吞吐量写入:为了保证大量数据能够快速写入MySQL,可以采用批量插入技术,并利用数据库连接池优化性能。

-

异常处理与重试机制:在写入过程中,如果发生错误(如网络中断、数据库锁定等),需要实现错误捕获和重试机制,以确保数据最终一致性。例如,针对特定错误码进行多次重试操作,并记录失败日志以便后续排查。

-

实时监控与日志记录:通过集中的监控和告警系统,实时跟踪数据写入任务的状态和性能。如果出现异常情况,可以及时告警并采取相应措施。同时,详细记录每次操作日志,包括成功和失败的记录,以便后续分析和优化。

处理细节与优化

- 确保不漏单:通过定时任务可靠地抓取钉钉接口数据,并结合分页机制确保所有记录都被完整抓取。

- 格式差异处理:对比钉钉与MySQL之间的数据格式差异,尤其是日期、金额等特殊字段,需要进行适当转换。

- 性能优化:针对大规模数据集成任务,可以采用分片处理、并行执行等技术手段,提高整体效率。

通过上述步骤,我们可以高效地将钉钉跨部门费用报销的数据经过ETL转换后,可靠地写入到目标平台MySQL中。这不仅保证了数据的一致性和完整性,还极大提升了业务流程自动化程度。