钉钉数据集成到MySQL:实现万师傅充值单的高效对接

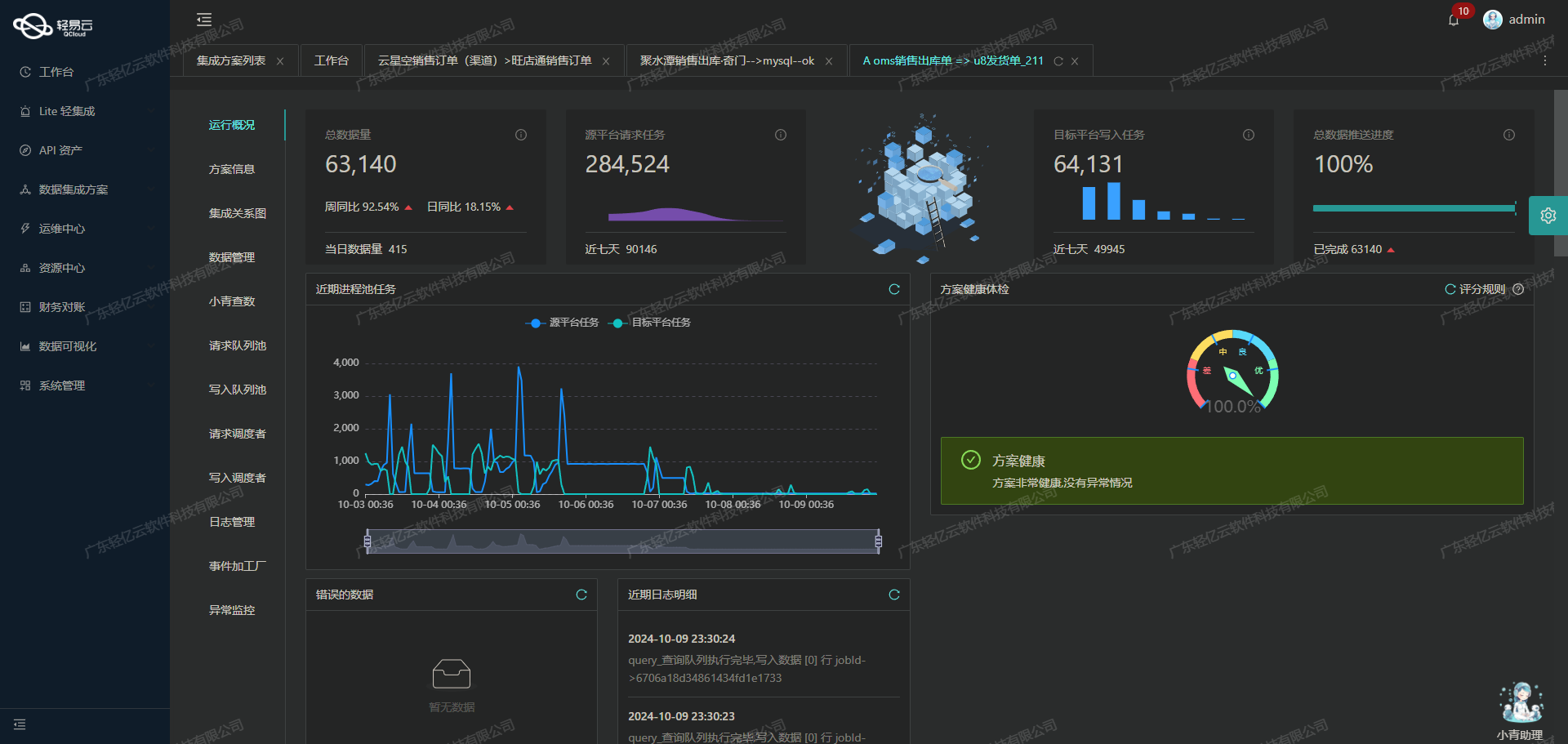

在企业信息化建设中,数据集成是一个至关重要的环节。本文将分享一个具体的系统对接案例,即如何通过轻易云数据集成平台,将钉钉中的“万师傅充值单”数据高效集成到MySQL数据库中的“BI崛起-万师傅充值表”。这一过程不仅需要处理大量的数据,还要确保数据的准确性和实时性。

首先,我们利用钉钉提供的API接口topapi/processinstance/get来获取“万师傅充值单”的详细信息。为了应对大规模的数据量,轻易云平台支持高吞吐量的数据写入能力,使得从钉钉获取的大量数据能够快速被处理并写入到MySQL中。这极大提升了数据处理的时效性,确保业务运营不会因数据延迟而受到影响。

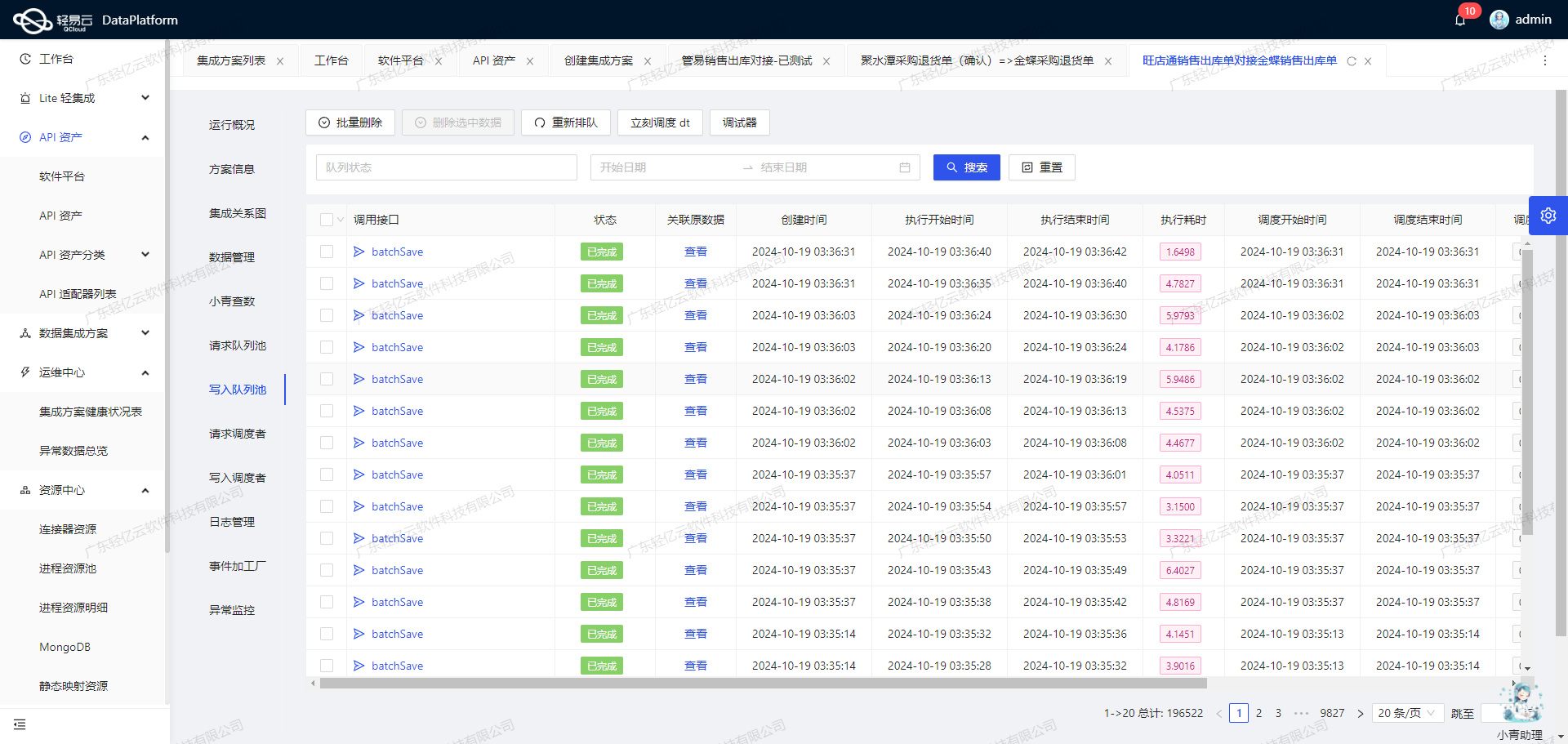

在整个集成过程中,实时监控和告警系统发挥了关键作用。通过集中监控,我们可以实时跟踪每个数据集成任务的状态和性能,一旦出现异常情况,系统会立即发出告警通知,从而及时采取措施进行修复。此外,为了保证数据质量,我们还配置了异常检测机制,对每一批次的数据进行校验,确保无漏单现象发生。

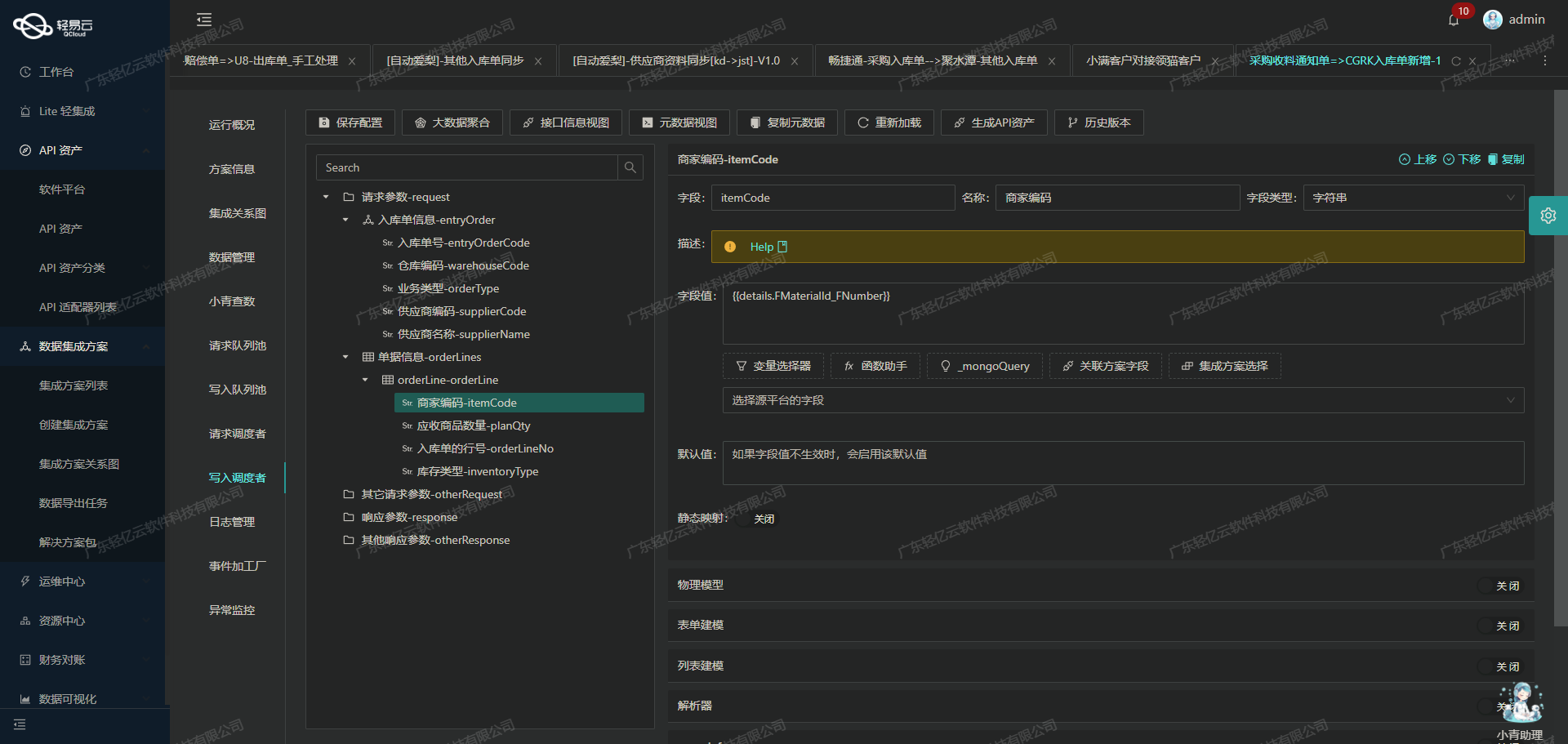

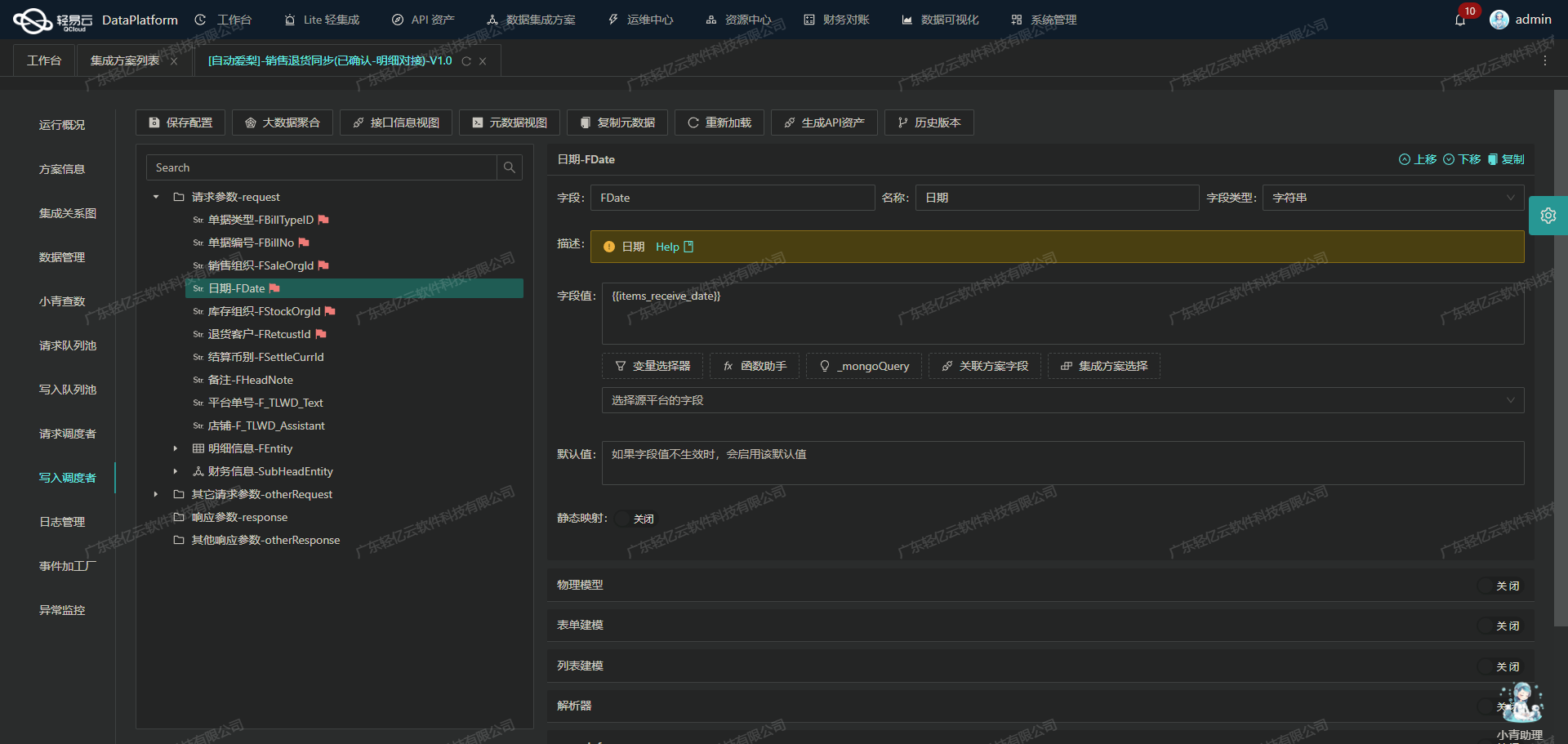

针对不同平台之间的数据格式差异,我们采用了自定义的数据转换逻辑,以适应特定业务需求和结构。同时,通过可视化的数据流设计工具,使得整个数据集成过程更加直观和易于管理。这些特性不仅简化了复杂的数据处理流程,还提高了整体效率。

最后,在实际操作中,我们还需特别注意处理钉钉接口的分页和限流问题,以及MySQL对接时可能遇到的异常情况。为此,我们设计了一套完善的错误重试机制,确保即使在网络波动或接口调用失败时,也能可靠地完成数据传输任务。

通过上述技术手段,本次“钉钉-万师傅充值单-->BI崛起-万师傅充值表”的集成方案,不仅实现了高效、稳定的数据对接,还为后续业务分析提供了坚实的数据基础。在接下来的章节中,我们将详细探讨具体实施步骤及技术细节。

调用钉钉接口topapi/processinstance/get获取并加工数据

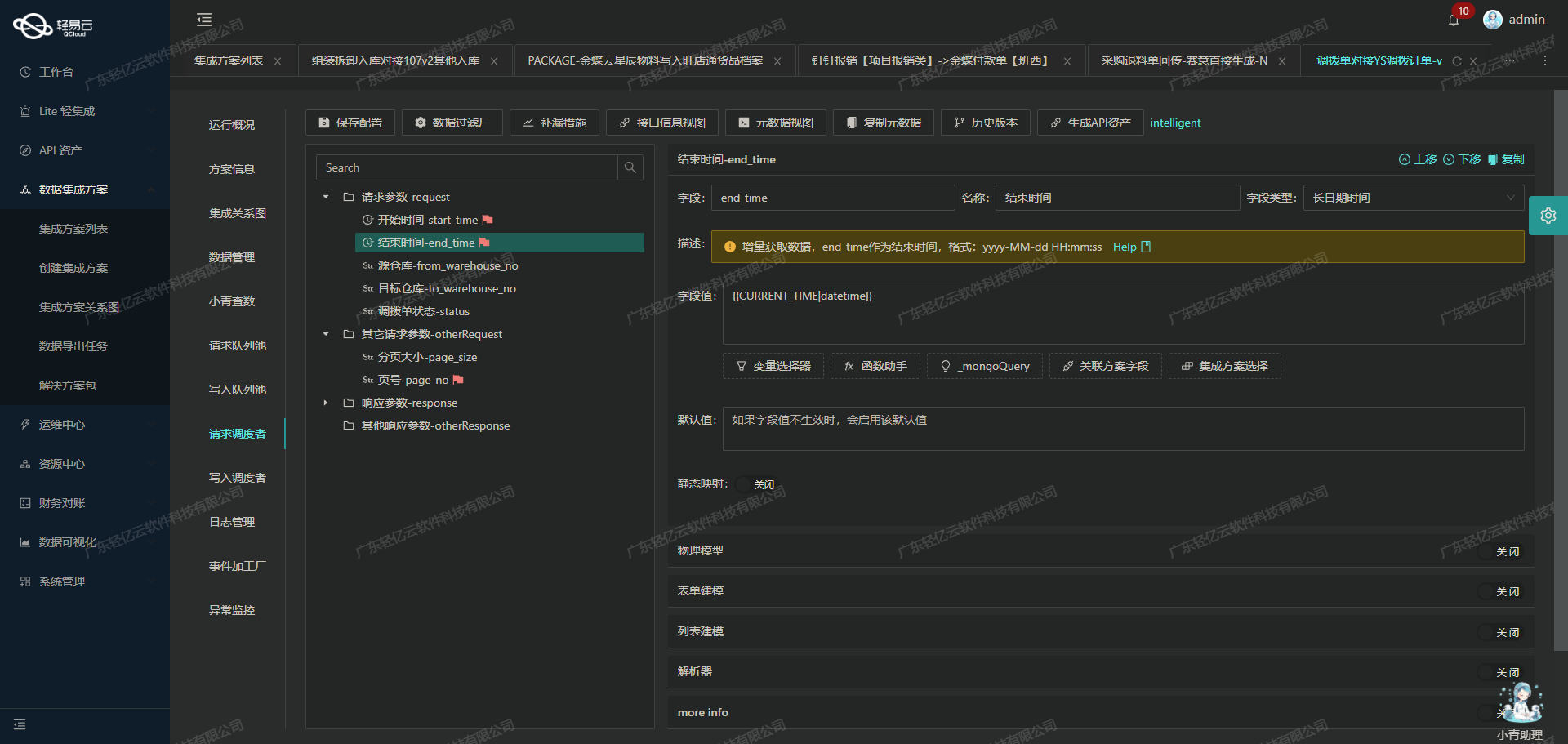

在数据集成的生命周期中,第一步是调用源系统的API接口以获取原始数据。本文将详细探讨如何通过轻易云数据集成平台调用钉钉接口topapi/processinstance/get,并对获取的数据进行初步加工处理。

配置元数据

首先,我们需要配置元数据,以便正确地调用钉钉API。以下是元数据配置的关键字段:

- api:

topapi/processinstance/get - method:

POST - request:

process_code: 审批流的唯一码start_time: 审批实例开始时间(Unix时间戳,单位毫秒)end_time: 审批实例结束时间(Unix时间戳,单位毫秒)size: 分页参数,每页大小,最多传20cursor: 分页查询的游标

这些字段确保我们能够准确地请求到所需的数据,并且支持分页查询以处理大量数据。

数据请求与清洗

在实际操作中,我们会先构建一个HTTP POST请求,将上述配置中的参数填入请求体中。例如:

{

"process_code": "PROC-9E080FCB-182E-43F6-BBE4-79CF1C1F669F",

"start_time": "{LAST_SYNC_TIME}*1000",

"end_time": "{CURRENT_TIME}*1000",

"size": "20",

"cursor": "0"

}发送请求后,我们会接收到一个包含审批实例信息的JSON响应。此时,需要对响应的数据进行初步清洗和转换,以便后续处理。例如,可以提取出有用的信息如审批实例ID、状态、发起人等。

分页与限流处理

由于每次请求最多只能返回20条记录,因此需要实现分页机制来获取所有数据。在首次请求时,cursor值为0;在后续请求中,将上一次响应中的next_cursor值作为新的cursor值继续请求,直到没有更多记录为止。

此外,为了避免触发API限流,需要在每次分页请求之间加入适当的延迟或根据API返回的速率限制信息调整请求频率。

数据转换与写入准备

经过清洗后的数据可能需要进一步转换,以适应目标系统(如MySQL)的表结构和业务需求。这包括但不限于字段重命名、类型转换以及格式化。例如,将Unix时间戳转换为标准日期格式:

{

"approval_id": "123456789",

"status": "COMPLETED",

"initiator": "user@example.com",

"start_time": 1609459200000,

// 转换后的日期格式

"start_date": "2021-01-01T00:00:00Z"

}实现高效的数据写入

为了确保高吞吐量的数据写入能力,可以采用批量插入技术,将多个记录一次性写入MySQL数据库。此外,通过轻易云提供的集中监控和告警系统,可以实时跟踪数据集成任务的状态和性能,及时发现并解决潜在问题。

异常处理与错误重试机制

在整个过程中,不可避免地会遇到各种异常情况,如网络超时、API限流等。为了提高系统可靠性,需要实现完善的异常处理和错误重试机制。例如,在捕获到网络超时时,可以设置一定次数的重试,并在多次失败后记录日志或发送告警通知。

通过以上步骤,我们可以有效地调用钉钉接口获取审批实例数据,并对其进行初步加工,为后续的数据转换与写入做好准备。这一过程不仅确保了数据的一致性和完整性,也提升了整体业务流程的透明度和效率。

钉钉数据集成到MySQL的ETL转换与写入

在数据集成过程中,特别是从钉钉系统到MySQL数据库的转换和写入阶段,ETL(Extract, Transform, Load)过程显得尤为重要。以下将详细探讨如何通过轻易云数据集成平台,将钉钉的充值单数据转换并写入MySQL。

数据抽取与转换

首先,从钉钉接口中抽取数据。以topapi/processinstance/get接口为例,该接口提供了详尽的审批实例信息,我们可以利用这一接口获取所需的数据字段。在抽取数据后,需要进行必要的清洗和转换,以确保数据格式符合目标平台MySQL的要求。

元数据配置定义了具体的数据字段及其映射关系。例如,main_params对象中包含了多个字段,如bfn_id、department、month等,这些字段需要从钉钉的数据中提取并进行适当的格式转换。

{

"field": "bfn_id",

"label": "id",

"type": "string",

"value": "{id}"

}上述配置说明了如何将钉钉中的ID字段映射到目标平台中的bfn_id字段。类似地,其他字段也需要按照元数据配置进行相应的映射和转换。

数据加载与写入

在完成数据转换后,下一步是将这些转换后的数据写入到MySQL数据库。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标系统中。

具体操作中,可以利用SQL语句实现批量插入或更新操作。以下是一个示例SQL语句,它使用了REPLACE INTO语法,确保在插入新记录时,如果存在主键冲突,则会更新已有记录:

REPLACE INTO master_wan_recharge (

bfn_id, department, month, purpose_details, corresponding_subjects, recharge_account,

expenses_explanation, recharge_amount, payment_method, other_payment_account,

payee_name, payment_account, payment_bank, financial_payment_method,

actual_payment_amount, create_time, finish_time, originator_userid,

originator_dept_id, status, result, business_id,

originator_dept_name, biz_action

) VALUES (

:bfn_id,:department,:month,:purpose_details,:corresponding_subjects,:recharge_account,

:expenses_explanation,:recharge_amount,:payment_method,:other_payment_account,

:payee_name,:payment_account,:payment_bank,:financial_payment_method,

:actual_payment_amount,:create_time,:finish_time,:originator_userid,

:originator_dept_id,:status,:result,:business_id,

:originator_dept_name,:biz_action

);通过这种方式,可以确保所有关键字段都被正确地映射和写入到目标数据库表中。

异常处理与重试机制

在实际操作中,可能会遇到各种异常情况,如网络问题、数据库连接失败等。为了保证数据的一致性和完整性,需要设计可靠的异常处理与重试机制。轻易云平台提供了丰富的监控和告警功能,可以实时跟踪数据集成任务的状态,并在出现异常时及时触发告警。

例如,当某次写入操作失败时,可以自动记录失败原因,并在稍后重新尝试该操作,直到成功为止。这种重试机制可以显著提高系统的稳定性和可靠性。

数据质量监控与日志记录

为了确保集成过程中的数据质量,需要对每一步骤进行严格监控。轻易云平台支持实时监控和日志记录功能,可以详细记录每次数据处理的结果,包括成功和失败的信息。这些日志对于后续排查问题、优化流程具有重要意义。

通过上述步骤,可以实现从钉钉系统到MySQL数据库的数据无缝集成,并保证整个过程高效、可靠。在实际应用中,还可以根据具体业务需求,对ETL过程进行进一步优化,以适应不同场景下的数据处理需求。