聚水潭数据集成到南方电网商城平台:传递南网售后结果

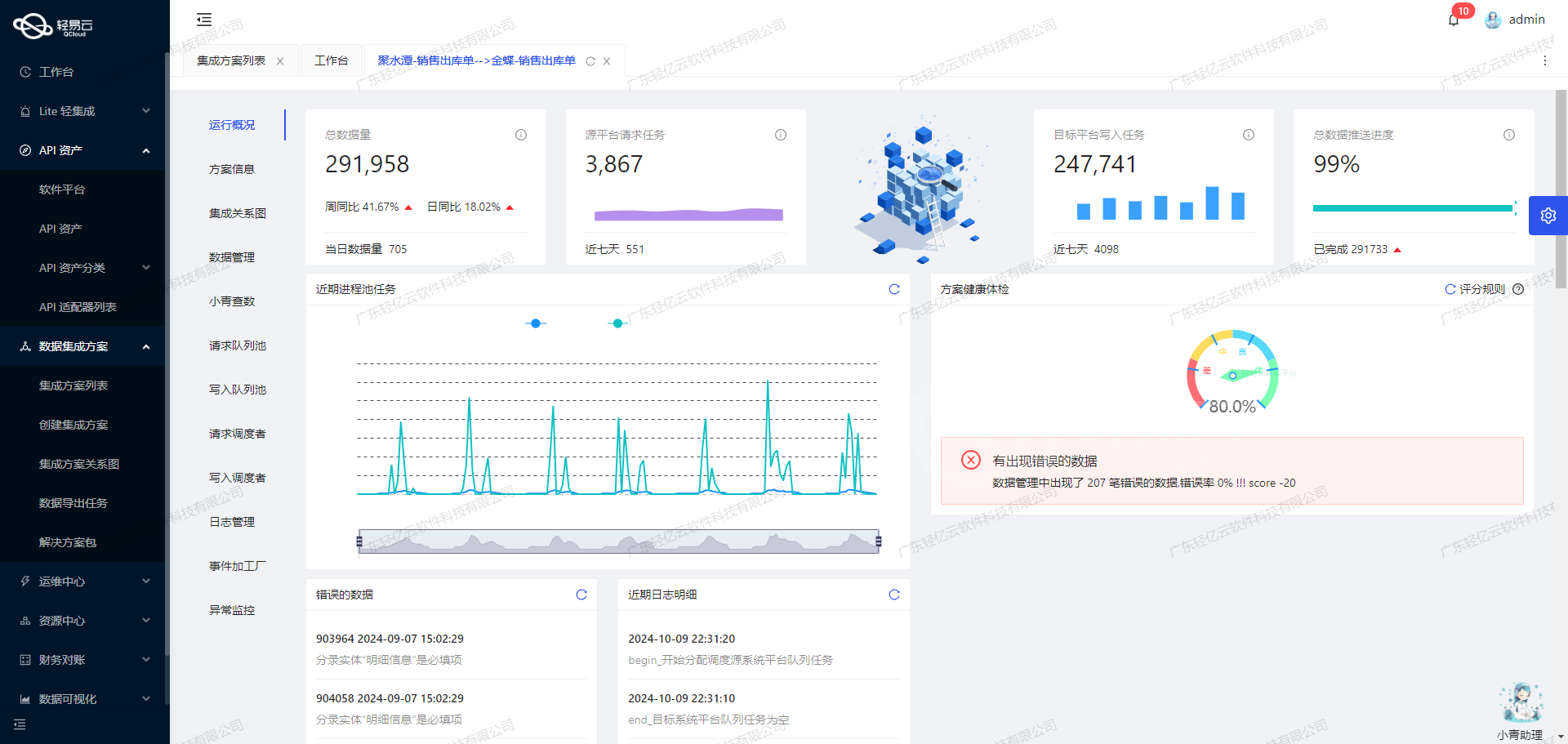

在系统对接和数据集成的场景下,确保两个异构系统之间的数据流动无缝、准确且高效,是一个重要的技术挑战。本文将详细解码如何通过轻易云数据集成平台,将聚水潭的数据成功对接到南方电网商城平台,实现"传递南网售后结果"方案。

首先,通过调用聚水潭提供的订单查询接口/open/orders/single/query进行数据抓取。为了保证不漏单,我们采用定时可靠抓取机制,自动周期性地请求该接口,并实时监控每次请求的状态与返回结果。同时,为了解决分页与限流问题,我们增加了智能分页处理逻辑,以确保大批量数据能够稳健获取,而不会因为频繁请求而触发限流策略。

其次,大量从聚水潭获取的数据,需要快速并准确写入到南方电网商城平台对应的API /o2rm/v1/api/afterSale/laborAfsResultNotice中。在此过程中,我们重点解决了两者之间的数据格式差异,通过定制化的数据映射规则,使其相互兼容。此外,针对写入过程中的异常情况,比如网络波动或API响应错误等问题,我们实现了一套完整的异常处理与错误重试机制,以提高整体流程的鲁棒性。

整个数据集成过程不仅必须保持高效率,还需要有很强的数据透明度。因此,在执行每一环节操作时都配置了详细的日志记录和状态监控功能,从而使得运维人员可以随时查看各步骤进展,并及时应对可能出现的问题。这对于长期运行中的维护及优化极为关键。

以上只是整个解决方案的一部分细节,后续我们将进一步深入探讨具体实现方案及代码示例,包括如何批量写入大量数据、定制化映射规则设计,以及更多关于性能优化和安全性的讨论。

调用聚水潭接口获取并加工数据的技术案例

在数据集成生命周期的第一步,我们需要调用源系统聚水潭的接口/open/orders/single/query来获取并加工数据。以下是详细的技术实现过程。

接口调用配置

首先,我们需要配置API接口调用的元数据。根据提供的元数据配置,接口调用采用POST方法,API路径为/open/orders/single/query。请求参数包括单据状态、线上单号、起始时间、结束时间、时间类型和店铺编码等。

{

"api": "/open/orders/single/query",

"effect": "QUERY",

"method": "POST",

"number": "o_id",

"id": "o_id",

"name": "shop_name",

"idCheck": true,

"request": [

{"field": "status", "label": "单据状态", "type": "string", "describe": "单据状态:WaitConfirm=待出库;Confirmed=已出库;Delete=作废;Cancelled=取消", "value":"Sent"},

{"field": "so_ids", "label": "线上单号", "type": "string", "describe":"指定线上订单号,和时间段不能同时为空"},

{"field": "modified_begin", "label": "起始时间", "type": "string", "value":"{{LAST_SYNC_TIME|datetime}}"},

{"field": "modified_end", "label": "结束时间", "type": "string", "value":"{{CURRENT_TIME|datetime}}"},

{"field": "date_type", "label":"时间类型","type":"string"},

{"field":"shop_id","label":"店铺编码","type":"string","value":"15121308"}

],

...

}请求参数解析

- status: 单据状态,固定值为"Sent",表示已发送。

- so_ids: 指定线上订单号,可以为空。

- modified_begin: 起始时间,使用上次同步时间。

- modified_end: 结束时间,使用当前时间。

- date_type: 时间类型,可以为空。

- shop_id: 店铺编码,固定值为"15121308"。

这些参数确保我们能够准确地从聚水潭系统中获取到所需的数据。

数据请求与清洗

在发起请求后,我们会接收到聚水潭返回的数据。此时,需要对数据进行初步清洗,以确保其符合后续处理的要求。以下是一个示例代码片段,用于发起请求并处理响应:

import requests

import json

from datetime import datetime

# 定义请求URL和头信息

url = 'https://api.jushuitan.com/open/orders/single/query'

headers = {'Content-Type': 'application/json'}

# 构建请求体

payload = {

'status': 'Sent',

'so_ids': '',

'modified_begin': '{{LAST_SYNC_TIME|datetime}}',

'modified_end': '{{CURRENT_TIME|datetime}}',

'date_type': '',

'shop_id': '15121308'

}

# 发起POST请求

response = requests.post(url, headers=headers, data=json.dumps(payload))

# 检查响应状态码

if response.status_code == 200:

data = response.json()

# 数据清洗逻辑

cleaned_data = []

for order in data.get('orders', []):

if order.get('type') == '换货订单':

cleaned_data.append(order)

else:

print(f"Error: {response.status_code}")数据转换与写入

经过清洗后的数据,需要进行转换以适应目标系统的数据格式,然后写入目标数据库或系统。在这个过程中,可以利用轻易云平台提供的自动填充响应功能(autoFillResponse),简化数据处理流程。

def transform_and_write(data):

transformed_data = []

for order in data:

transformed_order = {

'order_id': order['o_id'],

'shop_name': order['shop_name'],

# 添加其他必要的字段转换逻辑

}

transformed_data.append(transformed_order)

# 将转换后的数据写入目标系统(例如数据库)

write_to_target_system(transformed_data)

def write_to_target_system(data):

# 假设目标系统是一个数据库,这里使用伪代码表示插入操作

db_connection.insert_many('target_table', data)

# 调用转换与写入函数

transform_and_write(cleaned_data)通过上述步骤,我们完成了从聚水潭接口获取数据并进行初步加工的全过程。这一过程不仅保证了数据的一致性和准确性,也为后续的数据处理和分析奠定了坚实基础。

使用轻易云数据集成平台进行南方电网商城平台API接口数据转换与写入

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL转换,转为目标平台南方电网商城平台API接口所能够接收的格式,并最终写入目标平台。本文将详细探讨这一过程中涉及的技术细节。

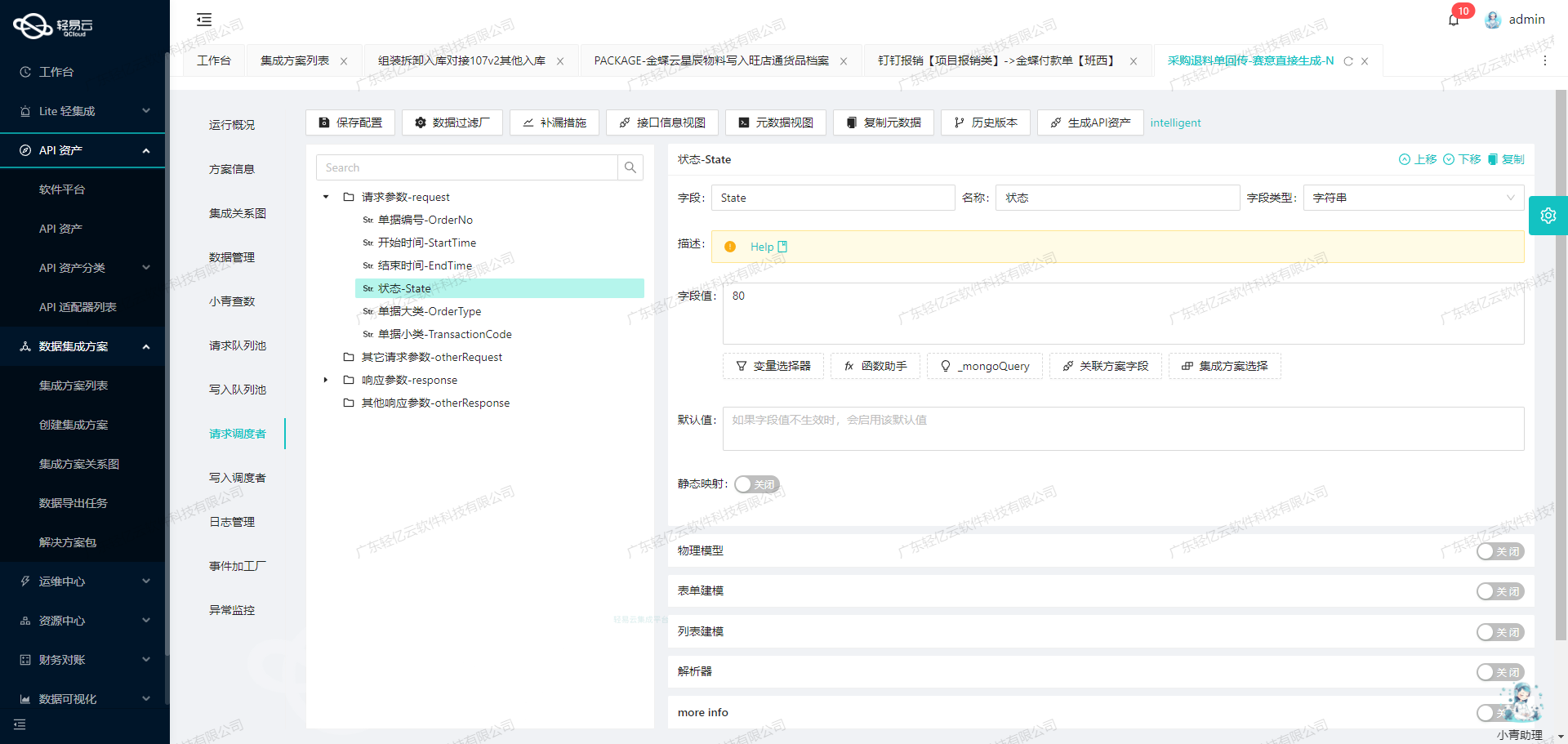

元数据配置解析

首先,我们来看一下元数据配置,这是我们进行ETL转换的基础:

{

"api": "/o2rm/v1/api/afterSale/laborAfsResultNotice",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "afsApplyId",

"label": "采购平台的售后申请单号",

"type": "string",

"value": "_mongoQuery 2c08dec9-37d2-392b-b9cb-34de7f3d9061 findField=content.afsApplyId where={\"content.orderId.0\":{\"$eq\":\"{so_id}\"}}"

},

{

"field": "afsDetails",

"label": "售后明细列表",

"type": "array",

"children": [

{

"field": "skuId",

"label": "商品编号",

"type": "string",

"value": "{items_sku_id}",

"parent": "deliveryInfo"

},

{

"field": "state",

"label": "售后处理结果",

"type": "string",

"value": 1,

"parent": "deliveryInfo"

},

{

"field": "afsType",

"label": "售后类型",

"type": "string",

"value": 2,

"parent": "deliveryInfo"

},

{

"

parent":"afsDetails","label":"售后数量","field":"num","type":"string","value":"{items_qty}"

},

{

"

parent":"afsDetails","label":"售后换新单号","field":"newOrderId","type":"string","value":"{o_id}-{items_sku_id}"

},

{

"

parent":"afsDetails","label":"备注信息","field":"remark","type":"string"

}

]

}

]

}数据请求与清洗

在这个阶段,我们需要从源系统中获取相关的数据。通过 _mongoQuery 我们可以从MongoDB数据库中提取特定字段的数据。例如,afsApplyId 是通过以下查询获取的:

"_mongoQuery 2c08dec9-37d2-392b-b9cb-34de7f3d9061 findField=content.afsApplyId where={\"content.orderId.0\":{\"$eq\":\"{so_id}\"}}"这段查询语句表示从指定的集合中找到 orderId 等于 {so_id} 的记录,并提取 content.afsApplyId 字段。

数据转换与写入

接下来是数据转换和写入部分。我们需要将提取到的数据按照目标API接口所需的格式进行转换。以下是具体步骤:

-

设置API地址和请求方法:

{ api: "/o2rm/v1/api/afterSale/laborAfsResultNotice", method: POST } -

构建请求体:

afsApplyId: 从MongoDB查询结果中获取。afsDetails: 包含多个字段,如skuId,state,afsType,num,newOrderId, 和remark。

-

字段映射:

skuId: 映射到{items_sku_id}。state: 固定值为1。afsType: 固定值为2。num: 映射到{items_qty}。newOrderId: 拼接{o_id}和{items_sku_id}。remark: 可以根据业务需求动态生成或固定填写。

-

示例请求体:

{ afsApplyId: "<从MongoDB查询结果>", afsDetails: [ { skuId: "<商品编号>", state: 1, afsType: 2, num: "<售后数量>", newOrderId: "<换新单号>", remark: "<备注信息>" } ] } -

发送请求: 使用HTTP客户端(如axios或fetch)发送POST请求,将构建好的请求体发送到目标API接口。

const axios = require('axios');

const requestBody = {

afsApplyId: '123456',

afsDetails: [

{

skuId: 'ABC123',

state: 1,

afsType: 2,

num: '10',

newOrderId: 'O123-ABC123',

remark: '无'

}

]

};

axios.post('/o2rm/v1/api/afterSale/laborAfsResultNotice', requestBody)

.then(response => console.log(response.data))

.catch(error => console.error(error));通过以上步骤,我们成功地将源系统的数据经过ETL转换,最终写入到了南方电网商城平台API接口。这一过程不仅确保了数据格式的一致性,还提高了数据传输的准确性和效率。