钉钉数据集成到轻易云平台的实践案例:宜搭联查产品id_copy

在企业信息化建设过程中,数据的有效整合与实时处理尤为重要。本文将聚焦于一个具体技术实施案例——通过轻易云集成平台实现对钉钉数据的高效、无缝对接,以“宜搭联查产品id_copy”方案为例进行系统性介绍。

首先,为了确保从钉钉获取的数据不漏单,我们调用了其提供的API接口 v1.0/yida/processes/instanceIds。这一接口能够检索出特定条件下所有满足要求的数据实例ID。由于该接口具有限流和分页设计,我们需要考虑如何合理有效地调度请求。同时,通过轻易云平台强大的批量写入功能,将这些数据快速传输至我们的目标数据库中,从而保障整个流程的连贯性和效率。

为了确保系统集成过程中各环节稳定运作,尤其是面对大规模数据时避免潜在风险,我们制定了一套完善的异常处理与错误重试机制。例如,在实际操作中,当某些API请求失败时,系统能自动进行多次重试,并记录详细日志用于后续排查。此外,通过实时监控工具,可以动态跟踪每一步骤的数据状态,以及整体流程中的性能指标,从而达到及时干预和优化调整效果。

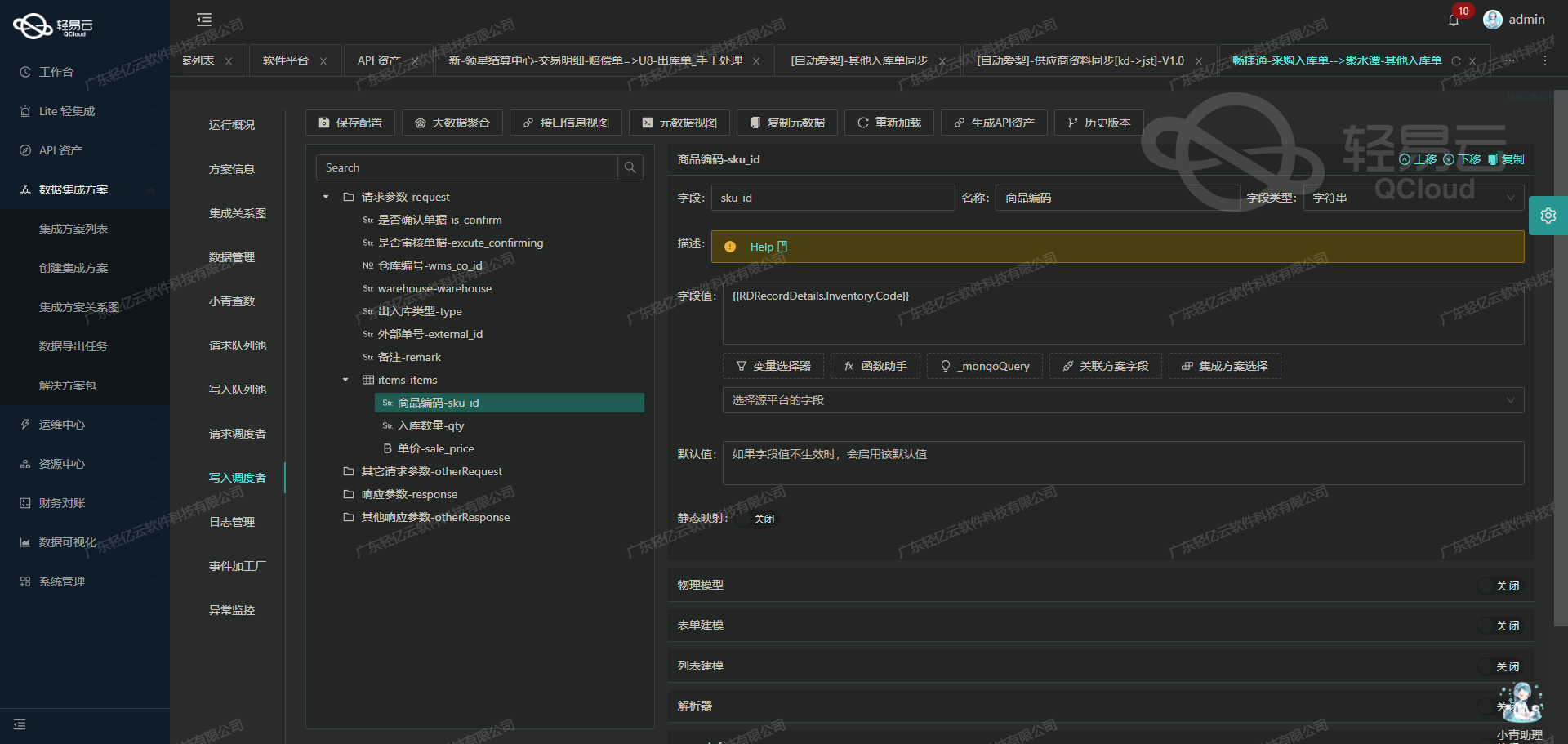

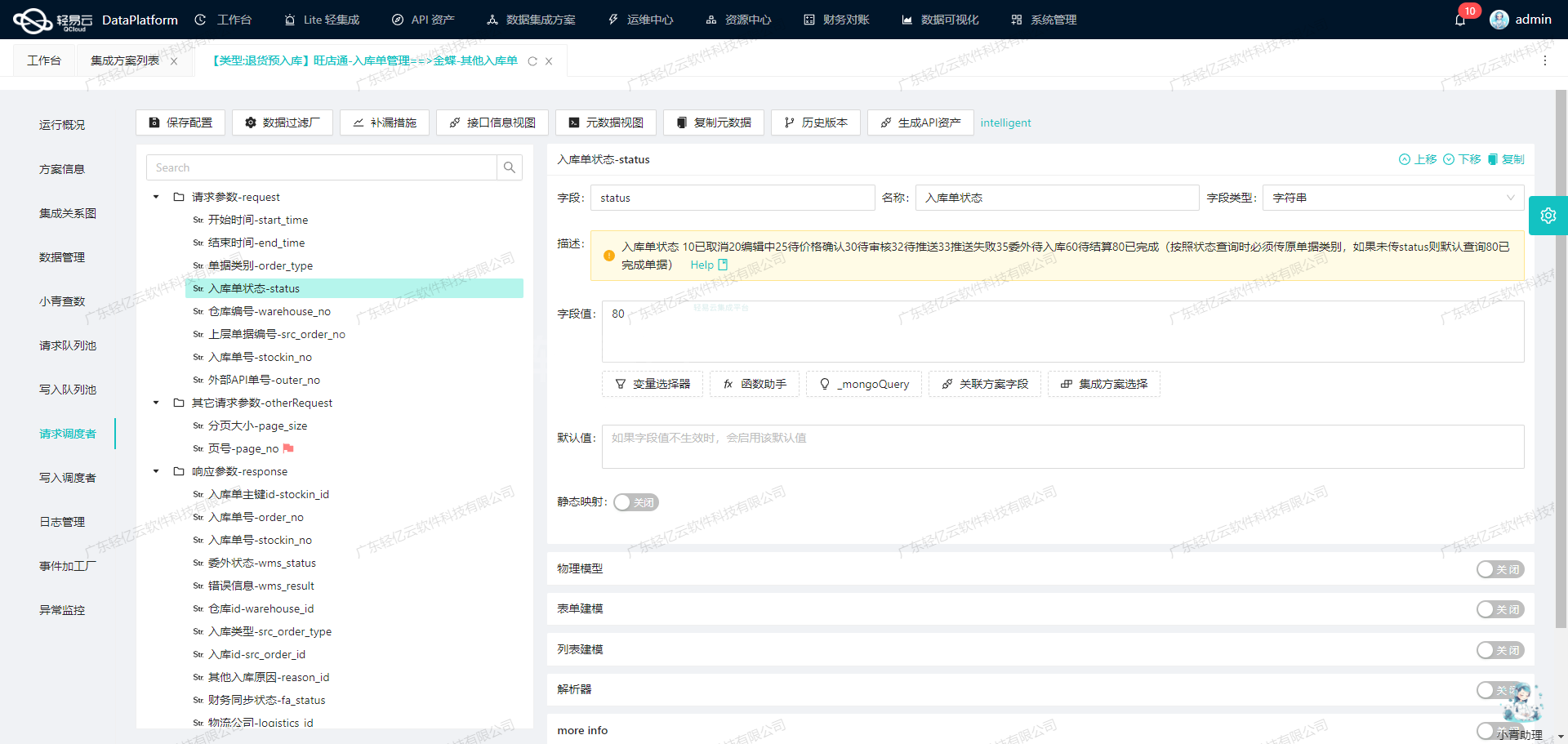

除了基础的数据抓取和写入,针对不同平台间可能存在的数据格式差异问题,也进行了专门处理。在这个项目中,我们利用轻易云提供的定制化映射策略,对接收自钉钉接口的数据格式进行了必要转换,使之符合我们业务逻辑所需,有效提升了整体对接成功率及准确性。这一过程结合使用到了轻易云独有的一些高级功能,如字段映射配置界面,可视化拖拽操作等,大大简化了开发者工作,实现复杂需求也变得相对简单明了。

总结来说,通过精准掌控每一个细微环节,此次案例展示不仅体现出了高度技术性,同时还保证了极高可靠性,为类似项目提供了一份值得参考借鉴的重要经验。接下来部分则继续详解具体实施步骤及代码示例如何落地执行。

调用钉钉接口v1.0/yida/processes/instanceIds获取并加工数据的技术案例

在轻易云数据集成平台的生命周期管理中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过调用钉钉接口v1.0/yida/processes/instanceIds来获取并加工数据。

接口配置与请求参数

首先,我们需要了解该接口的元数据配置。根据提供的元数据配置,以下是我们需要发送的POST请求参数:

{

"pageSize": "50",

"pageNumber": "1",

"formUuid": "FORM-C44B0A79D3DB498BBB633C0A3FFEE8EFKJGD",

"modifiedToTimeGMT": "{{CURRENT_TIME|datetime}}",

"systemToken": "CH766981N8RI4YCK9QDSUAGJLEPA2BCS0OWSLR",

"modifiedFromTimeGMT": "{{LAST_SYNC_TIME|datetime}}",

"language": "zh_CN",

"searchFieldJson": "",

"userId": "481569556726068568",

"instanceStatus": "",

"approvedResult": "",

"appType": "APP_E4D9OR2HF7QLY167G75K",

"originatorId": "",

"createToTimeGMT": "",

"taskId": "",

"createFromTimeGMT": ""

}这些参数中,pageSize和pageNumber用于分页控制,确保每次请求的数据量适中。formUuid指定了表单ID,而modifiedToTimeGMT和modifiedFromTimeGMT则用于限定数据修改时间范围。其他参数如systemToken、userId等则提供了必要的认证和查询条件。

数据请求与清洗

在发送请求后,我们会收到一组实例ID,这些ID代表了符合条件的数据实例。接下来,我们需要对这些数据进行清洗,以确保其质量和一致性。

- 验证数据完整性:检查每个实例是否包含所有必要字段,特别是那些在后续处理步骤中必需的字段。

- 去重处理:确保没有重复的数据实例,这可以通过比较实例ID来实现。

- 格式转换:将日期时间字段转换为统一格式,以便后续处理。例如,将所有时间字段转换为ISO8601标准格式。

数据转换与写入

清洗后的数据需要进一步转换,以适应目标系统的要求。这可能包括:

- 字段映射:将源系统中的字段名映射到目标系统中的对应字段名。

- 数据类型转换:例如,将字符串类型的数字转换为整数类型。

- 业务逻辑应用:根据业务需求,对某些字段进行计算或衍生出新的字段。

最后,将处理好的数据写入目标系统。这一步通常通过调用目标系统的API接口来实现。在轻易云平台上,可以通过配置相应的写入任务来完成这一过程。

实践案例

假设我们需要从钉钉获取某个表单在特定时间范围内的所有实例,并将其写入到一个数据库中。具体步骤如下:

-

配置请求参数:

{ "pageSize": "100", "pageNumber": "1", ... // 根据实际情况填写其他参数 } -

发送请求并接收响应:

import requests response = requests.post("https://oapi.dingtalk.com/v1.0/yida/processes/instanceIds", json=request_params) instance_ids = response.json().get("instanceIds", []) -

清洗与转换数据:

cleaned_data = [] for instance_id in instance_ids: # 获取详细信息并进行清洗与转换 instance_detail = get_instance_detail(instance_id) cleaned_instance = clean_and_transform(instance_detail) cleaned_data.append(cleaned_instance) -

写入数据库:

for data in cleaned_data: write_to_database(data)

通过上述步骤,我们实现了从钉钉获取表单实例、清洗和转换数据,并最终写入数据库的全过程。这不仅提高了数据处理效率,还确保了数据的一致性和准确性。

轻易云数据集成平台ETL转换技术案例

在数据集成过程中,将源平台的数据转换为目标平台所能接收的格式是关键的一步。本文将详细探讨如何利用轻易云数据集成平台的API接口进行ETL转换,并最终将数据写入目标平台。

数据请求与清洗

在进行ETL转换之前,首先需要从源平台获取数据并进行清洗。假设我们已经完成了这一阶段,接下来我们将重点放在如何将清洗后的数据进行转换,并通过API接口写入目标平台。

数据转换与写入

为了实现数据的无缝对接,我们需要配置元数据,以确保数据能够被正确地处理和传输。以下是一个典型的元数据配置示例:

{

"api": "写入空操作",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true

}这个配置文件定义了几个关键参数:

api: 指定了要调用的API接口名称,这里为“写入空操作”。effect: 定义了操作的效果,这里为“EXECUTE”,表示执行操作。method: 指定了HTTP请求的方法,这里为“POST”。idCheck: 一个布尔值,表示是否需要检查ID的唯一性,这里为true。

实际应用案例

假设我们有一组产品ID需要从源平台转移到目标平台。以下是具体的步骤:

-

获取源数据:首先,通过API或其他方式从源平台获取产品ID列表。

import requests source_url = "http://source-platform/api/getProductIds" response = requests.get(source_url) product_ids = response.json() -

数据清洗:对获取到的数据进行必要的清洗和验证,确保其符合目标平台的要求。

cleaned_product_ids = [pid for pid in product_ids if validate(pid)] -

数据转换:根据目标平台的需求,将清洗后的数据进行格式转换。

def transform_data(product_id): return { "productId": product_id, "timestamp": get_current_timestamp() } transformed_data = [transform_data(pid) for pid in cleaned_product_ids] -

通过API接口写入目标平台:利用轻易云提供的API接口,将转换后的数据写入目标平台。

target_url = "http://target-platform/api/writeData" headers = { 'Content-Type': 'application/json' } for data in transformed_data: response = requests.post(target_url, json=data, headers=headers) if response.status_code != 200: log_error(f"Failed to write data: {data}") else: log_success(f"Successfully wrote data: {data}")

元数据配置应用

在上述过程中,我们利用了元数据配置来指导API调用。特别是idCheck参数,可以确保每个产品ID在写入前都经过唯一性检查。这一步骤对于避免重复写入和数据冲突至关重要。

def write_data_with_id_check(data):

if id_exists(data["productId"]):

log_warning(f"ID already exists: {data['productId']}")

return False

response = requests.post(target_url, json=data, headers=headers)

return response.status_code == 200

for data in transformed_data:

if not write_data_with_id_check(data):

log_error(f"Failed to write data with ID check: {data}")

else:

log_success(f"Successfully wrote data with ID check: {data}")通过上述步骤,我们可以高效地完成从源平台到目标平台的数据ETL转换和写入过程。这不仅提高了系统间的数据一致性,还大大简化了复杂的数据处理流程。