官网提交到Baidu:MySQL数据集成到百度-AI的技术实现

在本案例中,我们将探讨如何通过轻易云数据集成平台,将MySQL中的数据高效、可靠地集成到百度-AI。该方案名为“官网提交到Baidu”,旨在实现从MySQL数据库获取数据并写入百度-AI的全过程。

首先,利用轻易云平台提供的高吞吐量数据写入能力,我们能够确保大量的数据能够快速被集成到MySQL系统中,从而提升整体的数据处理时效性。在实际操作中,通过调用MySQL接口select来定时抓取所需的数据,并进行批量处理,以保证数据的完整性和一致性。

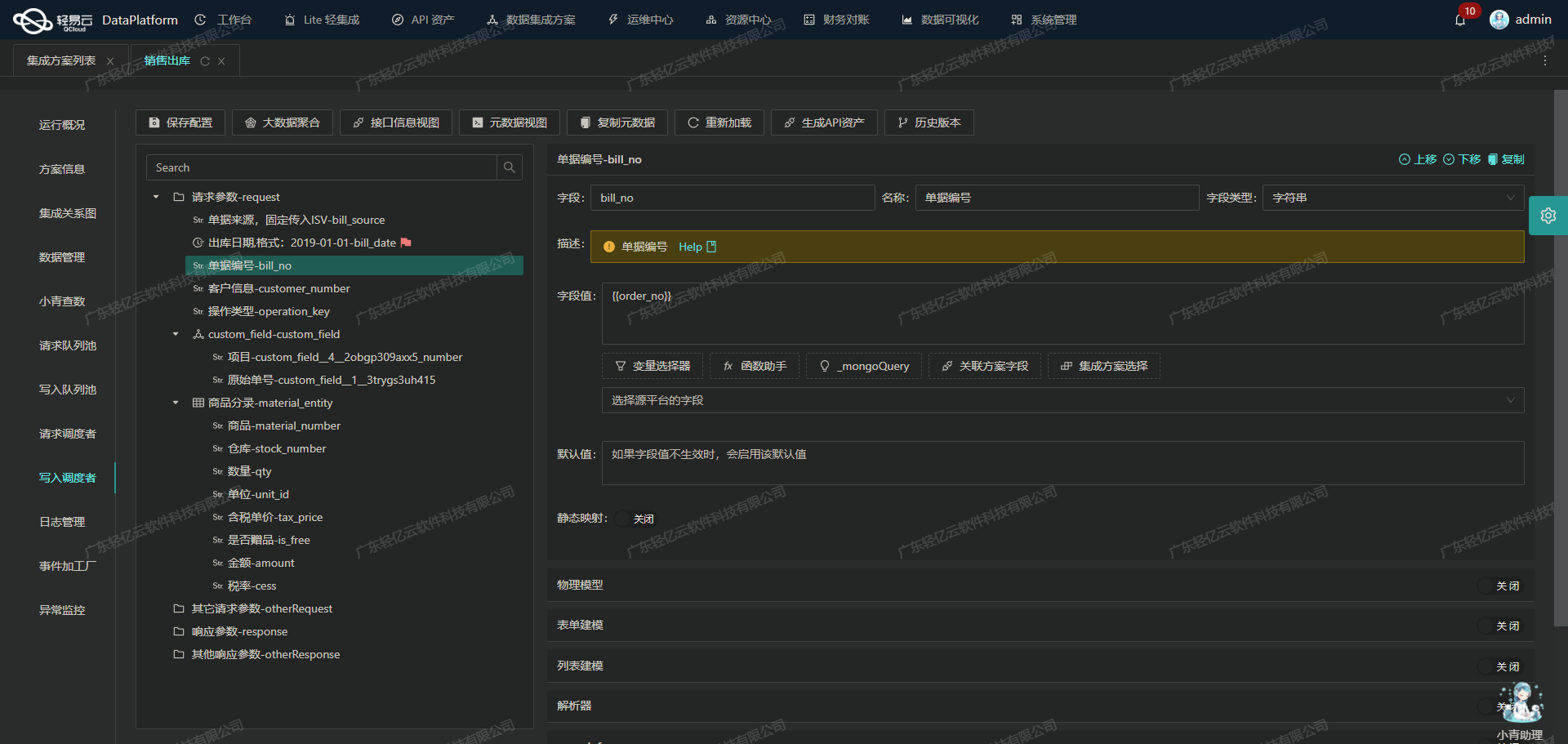

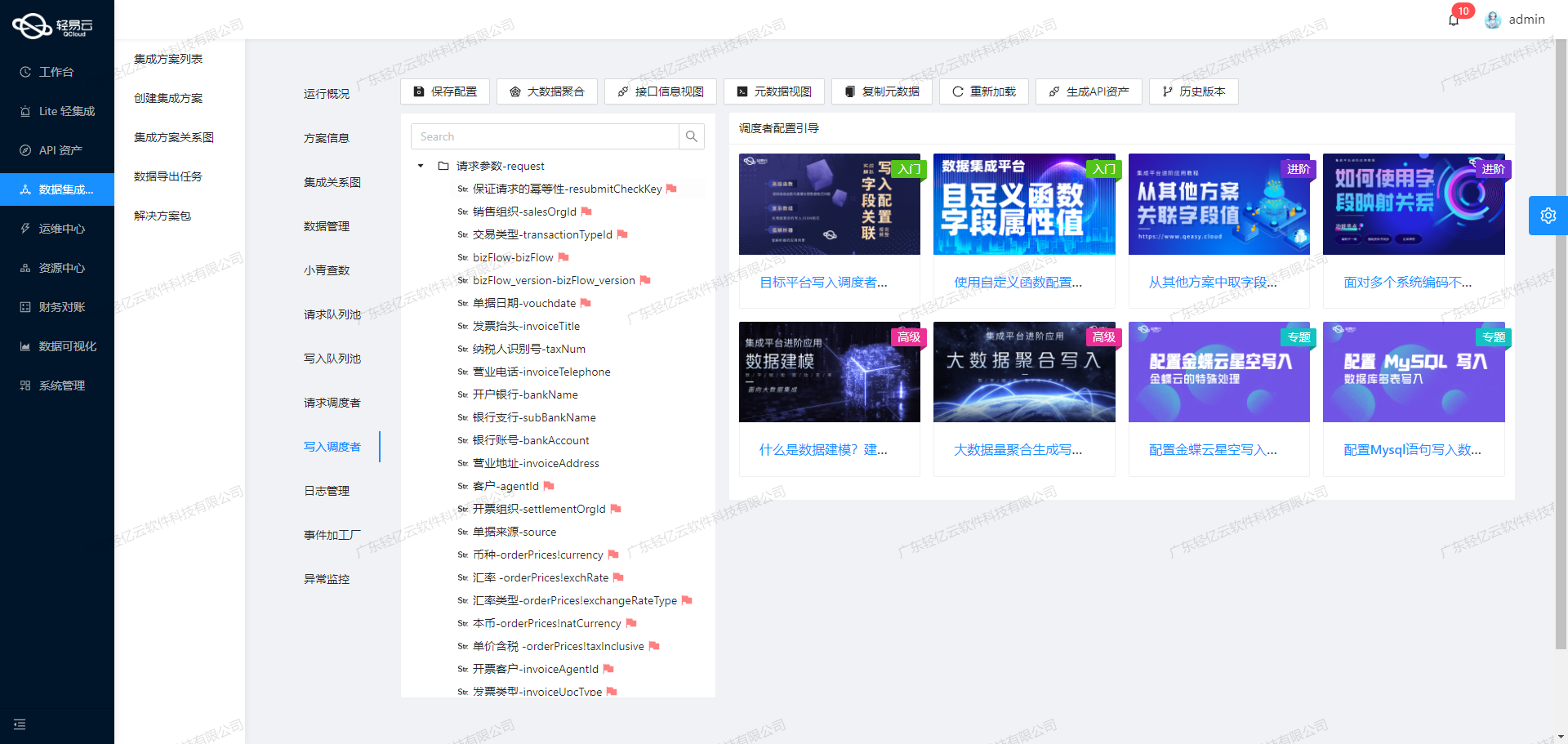

为了应对不同平台之间的数据格式差异,轻易云支持自定义数据转换逻辑,使得我们可以根据业务需求灵活调整数据结构。此外,针对百度-AI的特定要求,我们还实现了定制化的数据映射对接,确保每一条数据都能准确无误地写入目标系统。

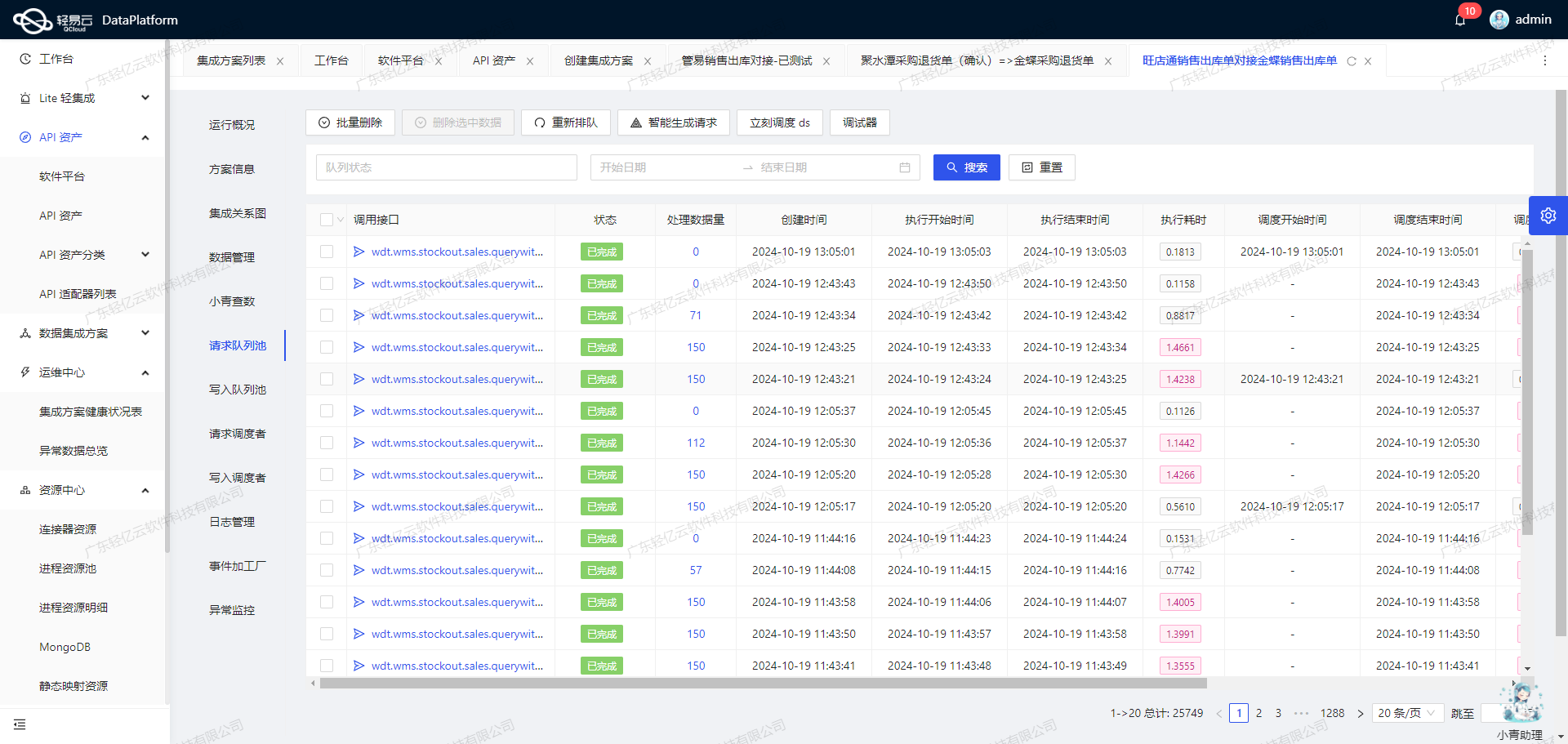

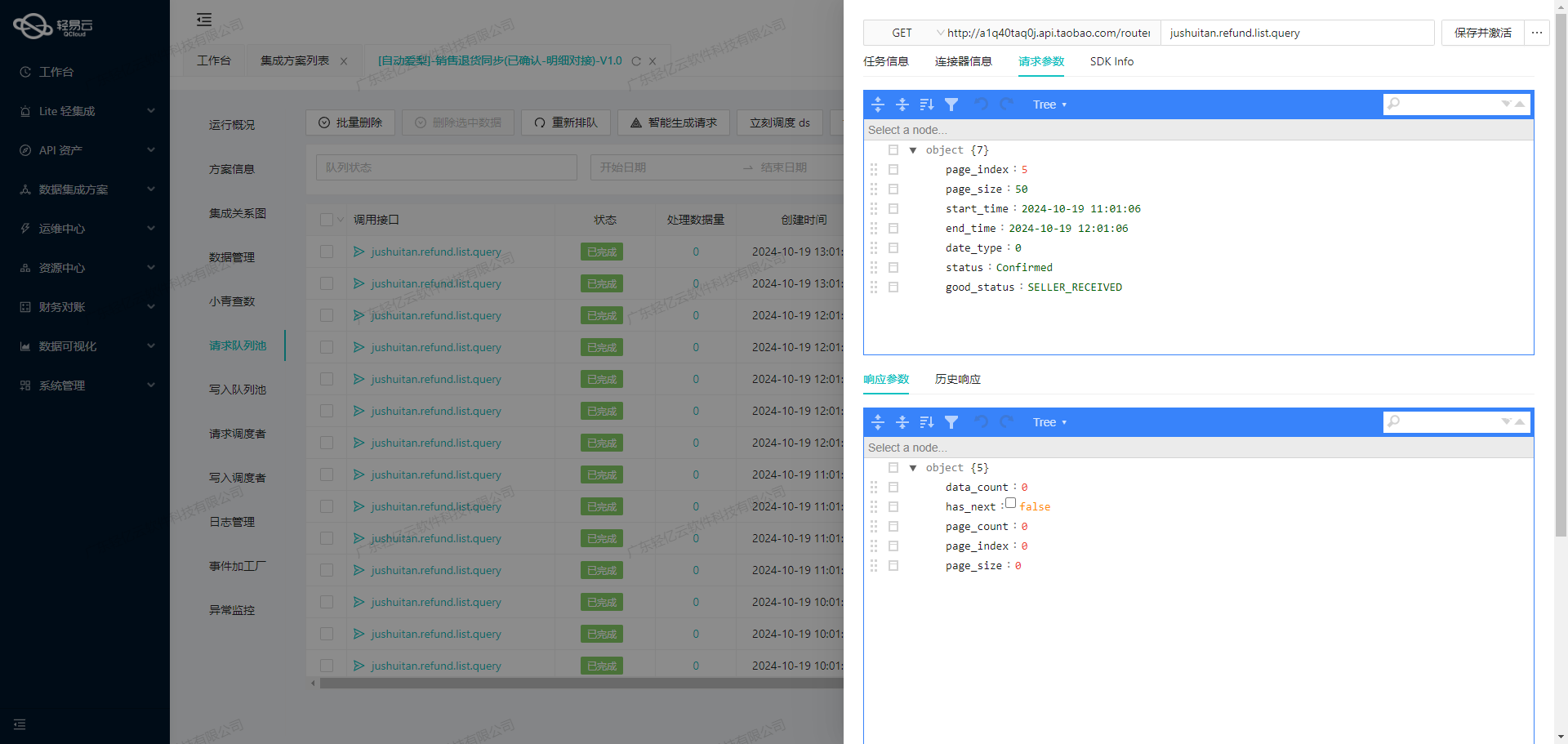

在整个集成过程中,实时监控和日志记录是不可或缺的一部分。通过集中监控和告警系统,我们能够实时跟踪每个任务的状态和性能,一旦发现异常情况,可以及时采取措施进行处理。同时,为了进一步保障数据质量,平台还提供了异常检测与错误重试机制,有效减少因网络波动或其他原因导致的数据丢失风险。

最后,为了优化资源利用率和配置管理,通过统一视图和控制台,我们可以全面掌握API资产的使用情况,实现资源的高效利用。这不仅简化了管理流程,还提高了整体运营效率。

以上便是“官网提交到Baidu”方案开头部分的技术要点介绍。在接下来的章节中,我们将详细阐述具体实施步骤及相关技术细节。

调用MySQL接口select获取并加工数据

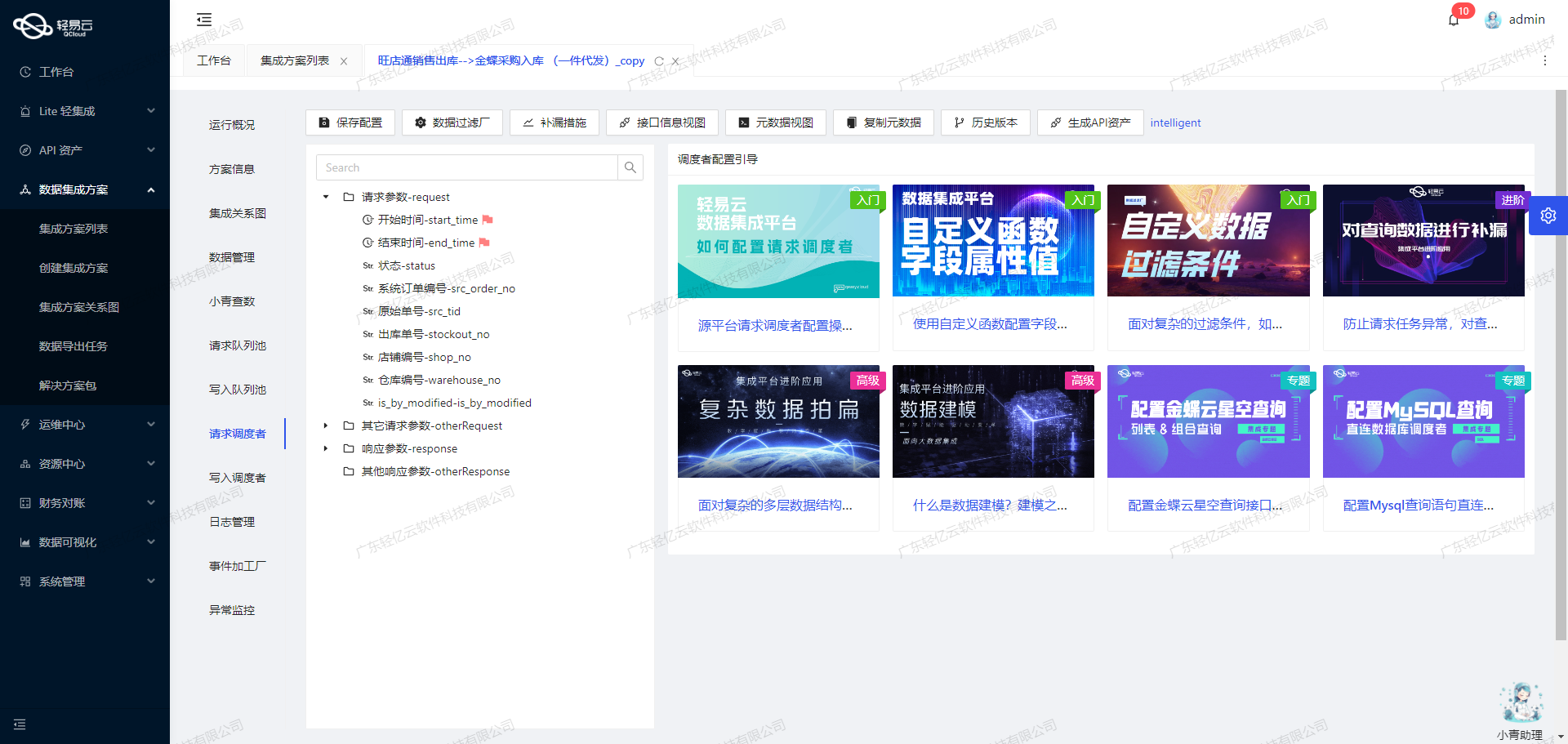

在轻易云数据集成平台的生命周期中,第一步是调用源系统MySQL接口select获取并加工处理数据。这个过程涉及到多个关键技术点,包括API接口调用、分页处理、数据清洗和转换等。

API接口调用与元数据配置

首先,我们需要通过API接口从MySQL数据库中提取数据。根据提供的元数据配置,可以看到我们使用的是POST方法来调用MySQL的select接口。具体的查询语句如下:

select id, slug, created_at, title from discussions where created_at >= '{{LAST_SYNC_TIME|datetime}}' order by id asc limit :limit offset :offset这条查询语句通过参数化的方式实现了动态分页,确保每次请求都能获取到最新的数据。

分页处理与限流机制

为了高效地处理大量数据,我们采用了分页机制。元数据配置中的分页参数如下:

"pagination": {

"pageSize": 100

}每次请求将会获取100条记录,通过设置limit和offset参数来控制分页。这种方式不仅能够有效地管理大规模数据,还能避免一次性加载过多数据导致系统性能问题。

数据清洗与转换

在获取到原始数据后,需要进行一定的数据清洗和转换,以满足目标系统(如百度-AI)的要求。例如,可能需要对日期格式进行标准化,对字符串进行去重或裁剪等操作。这些操作可以通过自定义的数据转换逻辑来实现,确保最终写入的数据符合业务需求。

实时监控与日志记录

为了保证整个集成过程的可靠性和透明度,轻易云平台提供了实时监控和日志记录功能。通过这些功能,可以实时跟踪每个API调用的状态、响应时间以及返回的数据量。一旦出现异常情况,如网络故障或数据库连接失败,系统会自动触发告警,并记录详细的错误日志以便后续分析和处理。

数据质量监控与异常检测

在实际操作中,保证数据质量至关重要。轻易云平台支持多种数据质量监控指标,如字段完整性检查、重复值检测等。同时,对于检测到的异常情况,如缺失字段或格式错误,可以设置自动纠正规则或人工审核流程,以确保最终写入的数据准确无误。

批量集成与高吞吐量支持

对于需要批量集成的大规模数据,轻易云平台具备高吞吐量支持能力。在批量写入过程中,通过优化网络传输和数据库写入策略,可以显著提升整体效率。此外,还可以利用分布式计算资源,实现并行处理,加速大规模数据集成任务的完成。

定制化映射与对接

最后,为了适应不同业务场景下的数据结构差异,可以通过定制化映射功能,将源系统中的字段映射到目标系统所需的格式。例如,将MySQL中的日期字段转换为百度-AI所需的时间戳格式,这样可以确保两者之间的数据兼容性。

综上所述,通过合理利用轻易云平台提供的各项特性,我们能够高效、安全地完成从MySQL数据库到目标系统(如百度-AI)的全流程数据集成任务。在这一过程中,从API接口调用、分页处理,到实时监控、异常检测,每一个环节都至关重要,共同保障了整个生命周期内的数据质量和业务连续性。

数据转换与写入百度-AIAPI接口的技术实现

在数据集成生命周期中,第二步至关重要,即将已经集成的源平台数据进行ETL转换,使其符合目标平台百度-AIAPI接口所能接收的格式,并最终写入目标平台。本文将详细探讨这一过程中的关键技术点。

1. 数据请求与清洗

在数据转换之前,首先需要从源平台(如MySQL数据库)抓取数据。可以通过定时任务来可靠地抓取MySQL接口数据,确保数据不漏单。例如,可以使用SQL语句SELECT * FROM source_table WHERE condition来获取需要的数据,同时处理分页和限流问题,以避免对数据库造成过大负载。

2. 数据转换逻辑的设计

为了适应百度-AIAPI接口的需求,需要对抓取到的数据进行清洗和转换。以下是一个简单的元数据配置示例:

{

"api": "site",

"method": "POST",

"idCheck": true,

"request": [

{"label":"网站","field":"site","type":"string","value":"https://www.qeasy.cloud"},

{"label":"token","field":"token","type":"string","value":"kjKEHTofIVguAJfi"},

{"label":"url","field":"url","type":"string","value":"https://www.qeasy.cloud/a/{id}"}

]

}在这个配置中,site、token和url字段需要从源平台数据中提取并转换为百度-AIAPI所需的格式。这一步可以通过自定义的数据转换逻辑来实现,例如使用ETL工具或编写脚本。

3. 数据映射与格式调整

百度-AIAPI接口要求特定的数据格式,因此需要对数据进行映射和格式调整。例如,将MySQL中的某些字段值映射到百度-AIAPI所需的字段,并确保数据类型一致。如果MySQL中的数据类型为整数,而百度-AIAPI要求字符串类型,则需要进行相应的类型转换。

# 示例代码:将MySQL数据转换为百度-AIAPI所需格式

def transform_data(mysql_data):

transformed_data = {

"site": mysql_data["website"],

"token": get_token(), # 假设有一个函数获取token

"url": f"https://www.qeasy.cloud/a/{mysql_data['id']}"

}

return transformed_data4. 批量写入与高吞吐量支持

为了提升数据处理的时效性,可以利用轻易云平台提供的高吞吐量写入能力,将大量数据快速集成到百度-AI系统中。批量处理不仅提高了效率,还减少了网络请求次数,从而降低了系统开销。

5. 调用百度-AIAPI接口

完成数据转换后,通过HTTP POST请求将数据写入百度-AIAPI接口。在这个过程中,需要注意异常处理与错误重试机制,以确保数据传输的可靠性。

import requests

def post_to_baidu_ai(data):

url = "https://api.baidu.com/ai"

headers = {"Content-Type": "application/json"}

response = requests.post(url, json=data, headers=headers)

if response.status_code != 200:

# 实现错误重试机制

retry_post(data)

def retry_post(data):

# 重试逻辑,如指数退避算法等

pass6. 实时监控与日志记录

为了确保整个集成过程的顺利进行,需要实现实时监控与日志记录。轻易云平台提供了集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能,及时发现并处理异常情况。

7. 数据质量监控与异常检测

最后,必须对集成的数据进行质量监控和异常检测。通过设置各种规则和阈值,及时发现并处理数据问题,确保最终写入百度-AI系统的数据准确无误。

总结以上步骤,通过合理设计ETL流程、优化批量写入、高效调用API以及全面监控等技术手段,可以成功将源平台的数据转化为目标平台百度-AIAPI接口所能接收的格式,并高效地完成数据写入任务。