SQL Server数据集成到MySQL:巨益OMS销售订单明细表对接案例

在企业信息系统中,数据的高效流动和准确集成是业务运营的关键。本文将分享一个具体的系统对接集成案例,即如何将SQL Server中的巨益OMS销售订单明细表无缝集成到MySQL目标平台中的销售订单明细表(salesorderdetail_z)。通过这一案例,我们将探讨在数据集成过程中所采用的技术手段和解决方案。

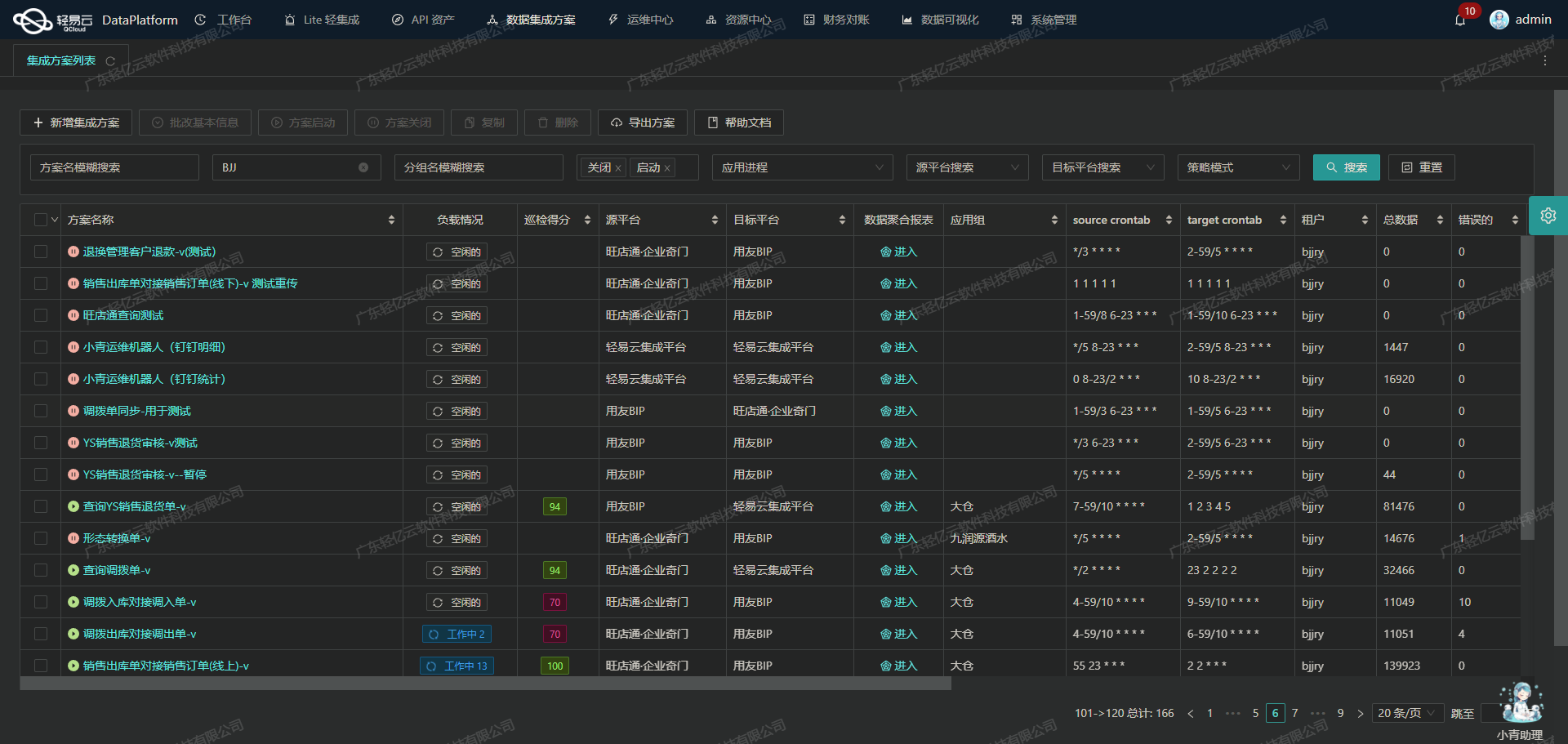

本次集成任务命名为“3--巨益OMS-销售订单明细表-->Mysql-销售订单明细表-salesorderdetail_z”,其核心目标是确保从SQL Server获取的数据能够准确、及时地写入到MySQL数据库中,并且在整个过程中实现高效的数据处理和实时监控。

首先,为了保证大量数据能够快速写入到MySQL,我们利用了轻易云平台提供的高吞吐量数据写入能力。这一特性使得我们可以在短时间内完成大批量数据的传输,极大提升了数据处理的时效性。此外,通过定时可靠地抓取SQL Server接口数据,我们确保了每一次的数据同步都能按计划进行,不漏单、不重复。

其次,在实际操作中,针对SQL Server与MySQL之间的数据格式差异问题,我们使用了自定义的数据转换逻辑。这不仅帮助我们适应不同业务需求,还确保了数据的一致性和完整性。同时,通过可视化的数据流设计工具,我们能够直观地管理和调整整个数据集成过程,使得复杂的操作变得简单易行。

为了进一步保障数据质量,我们还引入了集中监控和告警系统。该系统实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,立即发出告警并记录日志。这种机制不仅提高了问题响应速度,也为后续问题排查提供了详实依据。

最后,在API接口调用方面,我们采用select API从SQL Server获取所需的数据,并通过batchexecute API将这些数据批量写入到MySQL。这种方式不仅简化了操作流程,还有效减少了网络传输带来的延迟,提高整体效率。

通过上述技术手段,本次“3--巨益OMS-销售订单明细表-->Mysql-销售订单明细表-salesorderdetail_z”集成方案成功实现了跨平台的数据同步,为企业业务运营提供了坚实的数据支持。

调用SQL Server接口获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统SQL Server接口select获取并加工数据。这一步至关重要,因为它决定了后续数据处理和写入的质量与效率。以下将详细探讨如何通过配置元数据来实现这一过程。

配置元数据以调用SQL Server接口

首先,通过元数据配置,我们可以定义需要从SQL Server中提取的数据结构和查询逻辑。以下是一个典型的元数据配置示例:

{

"api": "select",

"effect": "QUERY",

"method": "SQL",

"number": "DetailId",

"id": "DetailId",

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

...

}

],

...

}在这个配置中,api字段指定了我们要执行的操作类型为select,而method字段则表明我们使用的是标准的SQL查询方法。

主查询语句与分页机制

为了高效地从SQL Server中提取大量销售订单明细,我们需要设计一个支持分页的主查询语句。如下所示:

select so.DetailId, so.CreateDate, so.SalesOrderId, ...

from SalesOrderDetail so

left join SalesOrder sr on so.SalesOrderId = sr.OrderId

where sr.UpdateDate >= :UpdateDateBegin and sr.UpdateDate <= :UpdateDateEnd

order by so.DetailId offset :offset rows fetch next :fetch rows only该查询语句通过:offset和:fetch参数实现分页,从而避免一次性加载过多数据导致性能问题。每次请求将返回5000条记录,这个值可以根据实际需求进行调整。

参数化请求与时间窗口控制

为了确保我们获取的数据是最新且不重复的,需要使用时间窗口控制。通过以下参数化请求,可以动态设置订单表更新时间范围:

{

"field": "main_params",

...

"children": [

{"field":"offset","label":"offset","type":"int"},

{"field":"fetch","label":"fetch","type":"int","value":"5000"},

{"field":"UpdateDateBegin","label":"订单表更新时间(开始时间)","type":"string","value":"{{LAST_SYNC_TIME|datetime}}"},

{"field":"UpdateDateEnd","label":"订单表更新时间(结束时间)","type":"string","value":"{{CURRENT_TIME|datetime}}"}

]

}这里,UpdateDateBegin和 UpdateDateEnd分别代表上次同步时间和当前时间,通过这些动态参数,可以确保每次调用都能准确抓取到最新更新的数据。

数据清洗与转换

在获取到原始数据后,需要对其进行必要的清洗与转换,以适应目标系统MySQL的数据结构。例如,可以自定义转换逻辑来处理不同的数据格式差异:

- 日期格式转换:将SQL Server中的日期格式转换为MySQL兼容的格式。

- 字段映射:根据业务需求,将源系统中的字段名映射到目标系统中的对应字段名。

- 异常处理:对于缺失或异常值进行预处理,如填充默认值或丢弃无效记录。

实时监控与日志记录

为了确保整个过程顺利进行,轻易云平台提供了实时监控和日志记录功能。这些功能允许我们随时查看任务状态、性能指标以及可能出现的问题,从而及时采取措施进行调整。

通过上述步骤,我们能够高效地调用源系统SQL Server接口获取并加工销售订单明细,为后续的数据写入奠定坚实基础。在实际应用中,根据具体业务需求,还可以进一步优化查询逻辑、分页策略以及清洗规则,以提升整体性能和可靠性。

数据集成生命周期的第二步:ETL转换与MySQLAPI接口对接

在数据集成的生命周期中,第二步至关重要,即将已经集成的源平台数据进行ETL转换,转为目标平台 MySQLAPI接口所能够接收的格式,并最终写入目标平台。本文将深入探讨这一过程,结合具体元数据配置,展示如何高效地实现数据转换和写入。

数据请求与清洗

在进行ETL转换之前,首先需要从源平台(如巨益OMS)提取销售订单明细表的数据。这一过程涉及到对数据的清洗和预处理,以确保数据质量和一致性。例如,对于日期字段,如果存在缺失值,可以设置默认值为“1970-01-01 00:00:00”。

数据转换

数据转换是ETL过程中的核心环节。在这一阶段,我们需要将源平台的数据字段映射到目标平台MySQL所需的字段格式。以下是一些关键字段及其映射关系:

DetailId映射到DetailIdCreateDate映射到CreateDateSalesOrderId映射到SalesOrderIdFirstCost映射到FirstCost- ...

这些映射关系通过元数据配置文件进行定义,如下所示:

{

"field":"DetailId",

"label":"DetailId",

"type":"int",

"value":"{DetailId}"

},

{

"field":"CreateDate",

"label":"CreateDate",

"type":"datetime",

"value":"{CreateDate}",

"default":"1970-01-01 00:00:00"

},

...通过这种方式,我们可以确保每个字段都能够准确地从源平台映射到目标平台。

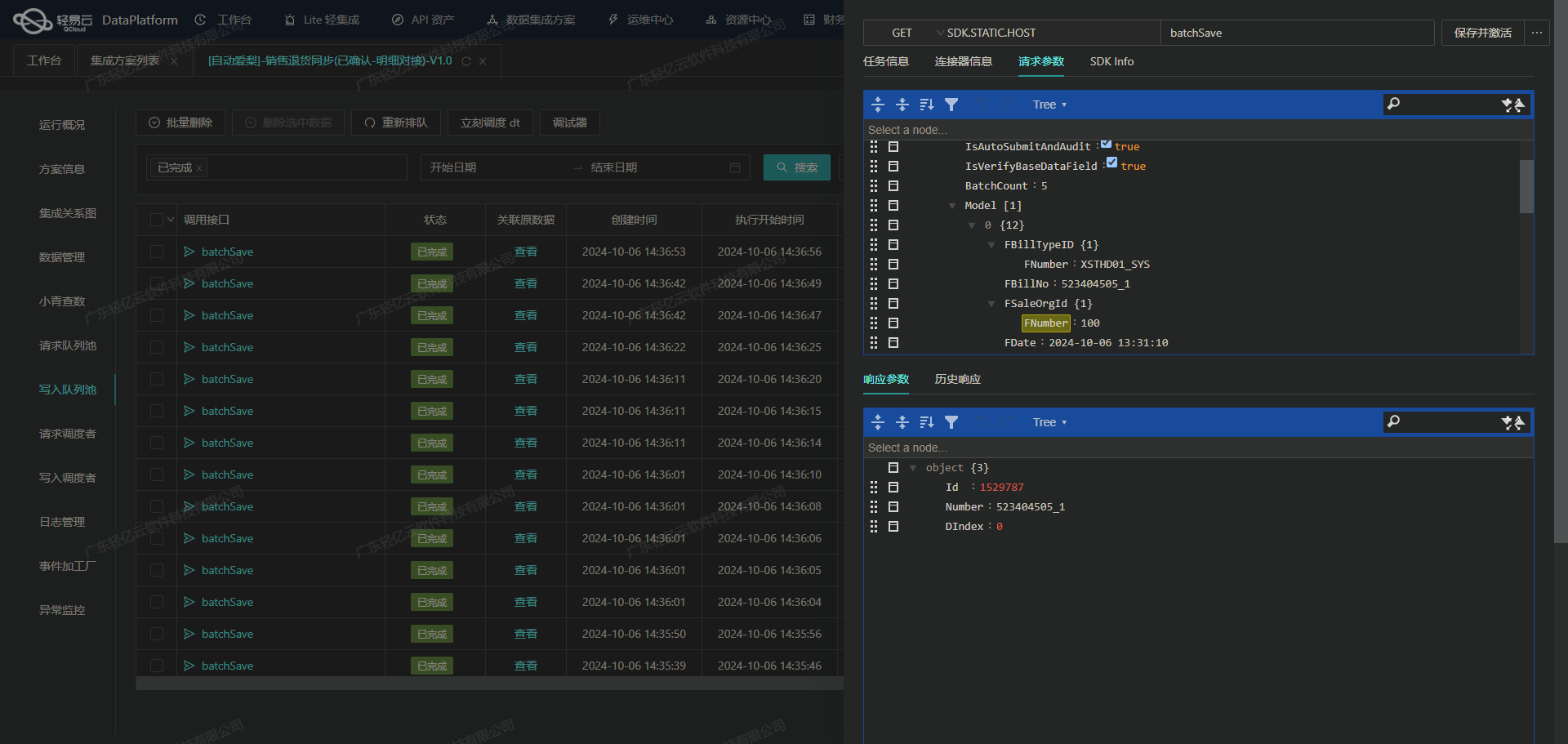

数据写入

在完成数据转换之后,下一步是将数据写入目标平台MySQL。这一步骤通常使用批量操作来提高效率和吞吐量。在本案例中,我们使用了REPLACE INTO语句来实现这一功能。具体的SQL语句如下:

REPLACE INTO salesorderdetail_z (

DetailId, CreateDate, SalesOrderId, FirstCost, PriceOriginal, PriceSelling,

Quantity, DiscountAmount, Amount, AmountActual, IsAbnormal, IsDeleted,

IsRefunded, IsRefundFinished, Status, ShippingDateClerk, DistributionAmount,

DeletedDate, ReissueActual, ProductId, ProductCode, ProductName,

ProductSkuId, SkuCode, SkuName, DetailType, CombProductId,

IsCombproduct, IsSplit, SpareParts, IsPlatformDeliveried,

RefundStatus, PresellPlanId, ActivityStrategyId,

StoreCode, CombProductLockDetailId,

CombProductQuantity, CombProductCode,

DisputeId, ExchangeId,

VirtualDeliveried,

VirtualDeliveriedStoreId,

IsStandard,

IsProduct,

IsAccounted,

CombProductName,

CombQuantity,

CombAmount,

IsMachin,

AppointDeliveryDate,

DeliveryDate,

) VALUES (?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?, ?)通过使用批量操作,每次可以处理大量记录,从而极大提升了数据处理的效率。

实时监控与异常处理

为了确保数据集成过程的可靠性,我们需要实时监控数据流动和处理状态。轻易云提供了集中的监控和告警系统,可以实时跟踪任务状态和性能。此外,还支持自定义异常处理和错误重试机制,以应对可能出现的数据问题。例如,当某个字段的数据格式不符合预期时,可以自动触发告警并重试该操作。

数据质量与优化

在整个过程中,确保数据质量至关重要。我们可以利用轻易云的平台特性,对每个步骤进行严格监控,并及时发现并处理异常情况。例如,对于金额相关的字段(如Amount、DiscountAmount),可以设置合理的范围检查,防止出现异常值。

此外,通过统一视图和控制台管理API资产,可以全面掌握资源使用情况,实现高效利用和优化配置。这不仅提高了系统性能,还能有效降低运营成本。

结论

通过以上步骤,我们实现了从巨益OMS销售订单明细表到MySQL销售订单明细表的高效ETL转换和写入。在这个过程中,充分利用了轻易云提供的数据质量监控、实时监控和异常处理等功能,确保了数据集成过程的可靠性和高效性。