W-金蝶物料分组信息集成方案:从金蝶云星空到MySQL

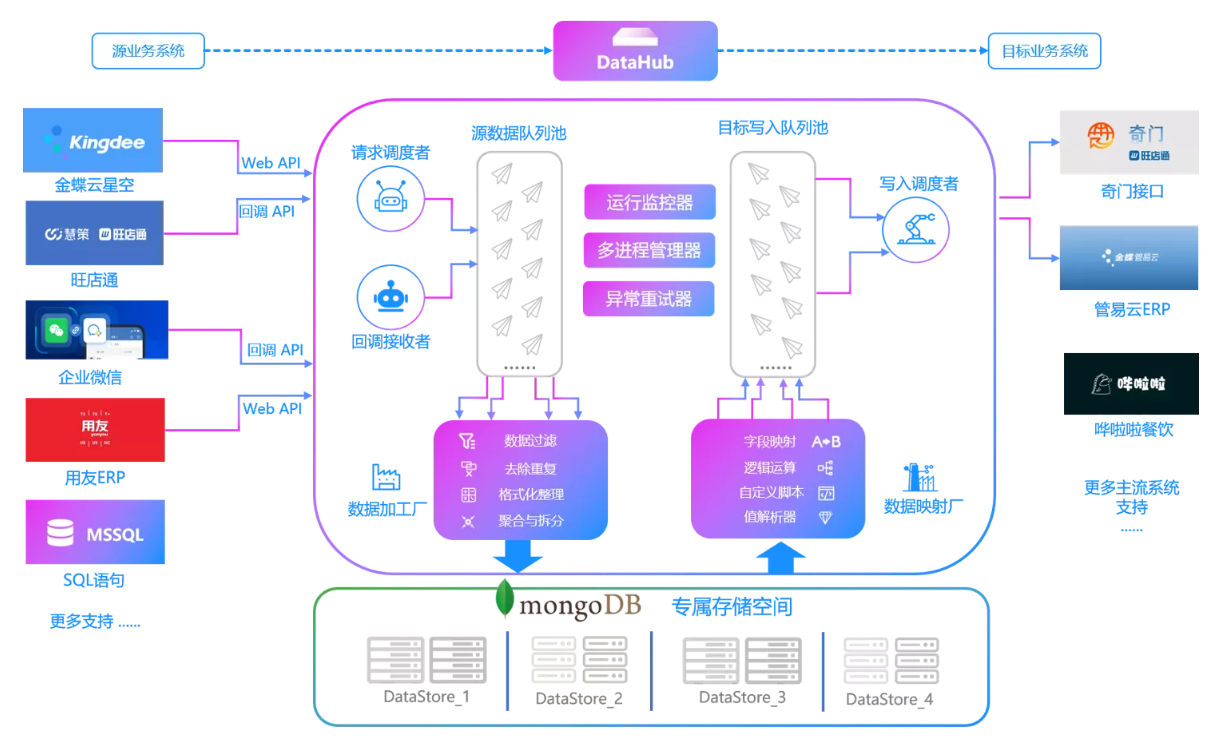

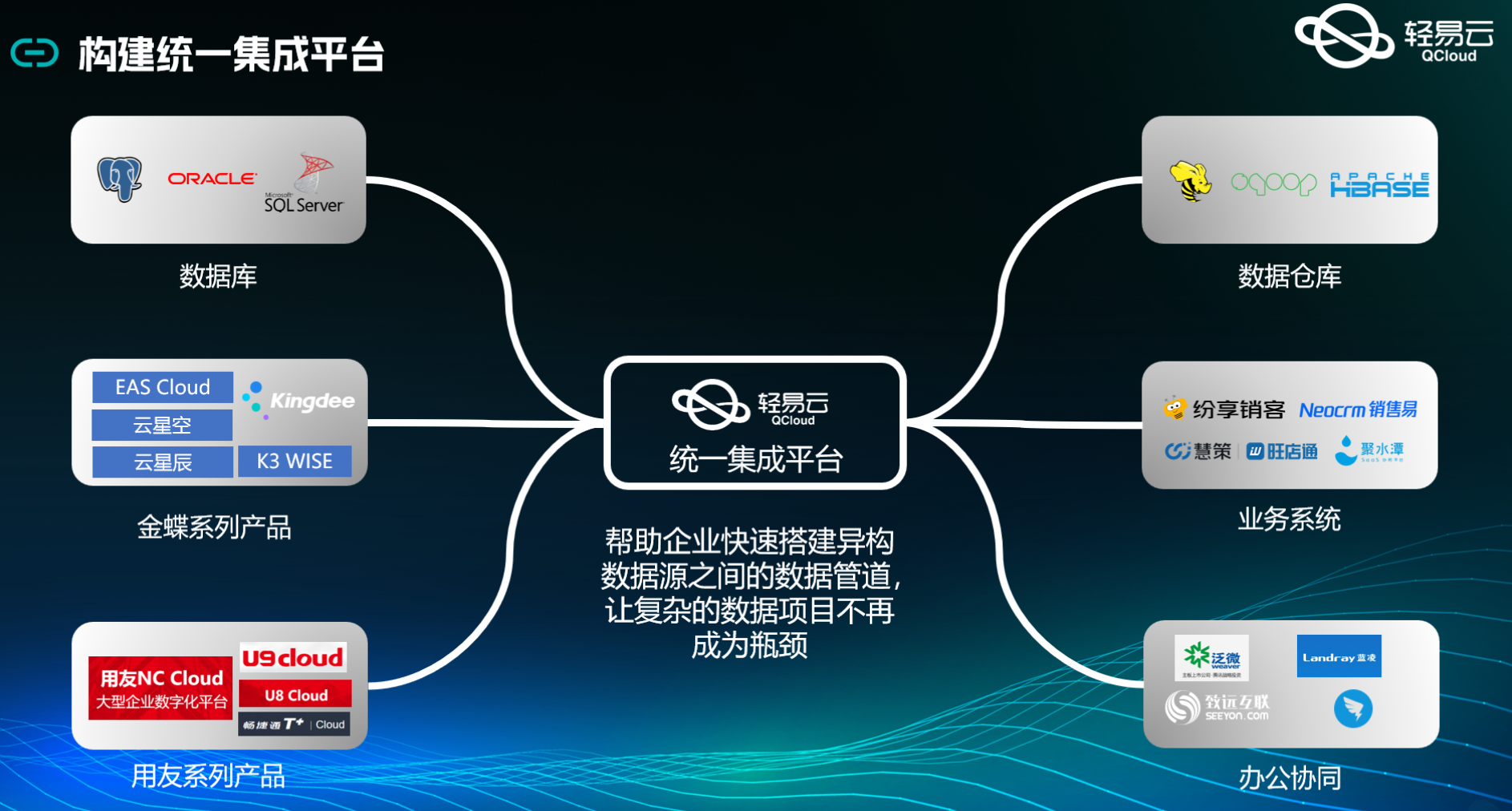

在企业数据管理中,如何高效、准确地将金蝶云星空中的物料分组信息集成到MySQL数据库,是一个常见且关键的需求。本文将分享一个具体的技术案例,展示如何利用轻易云数据集成平台,实现这一目标。

任务背景

本次集成任务的核心是通过调用金蝶云星空的API接口select获取物料分组信息,并将这些数据批量写入到MySQL数据库中。为了确保数据处理的高效性和可靠性,我们采用了以下几项关键技术特性:

- 高吞吐量的数据写入能力:支持大量数据快速写入到MySQL,提升整体数据处理时效性。

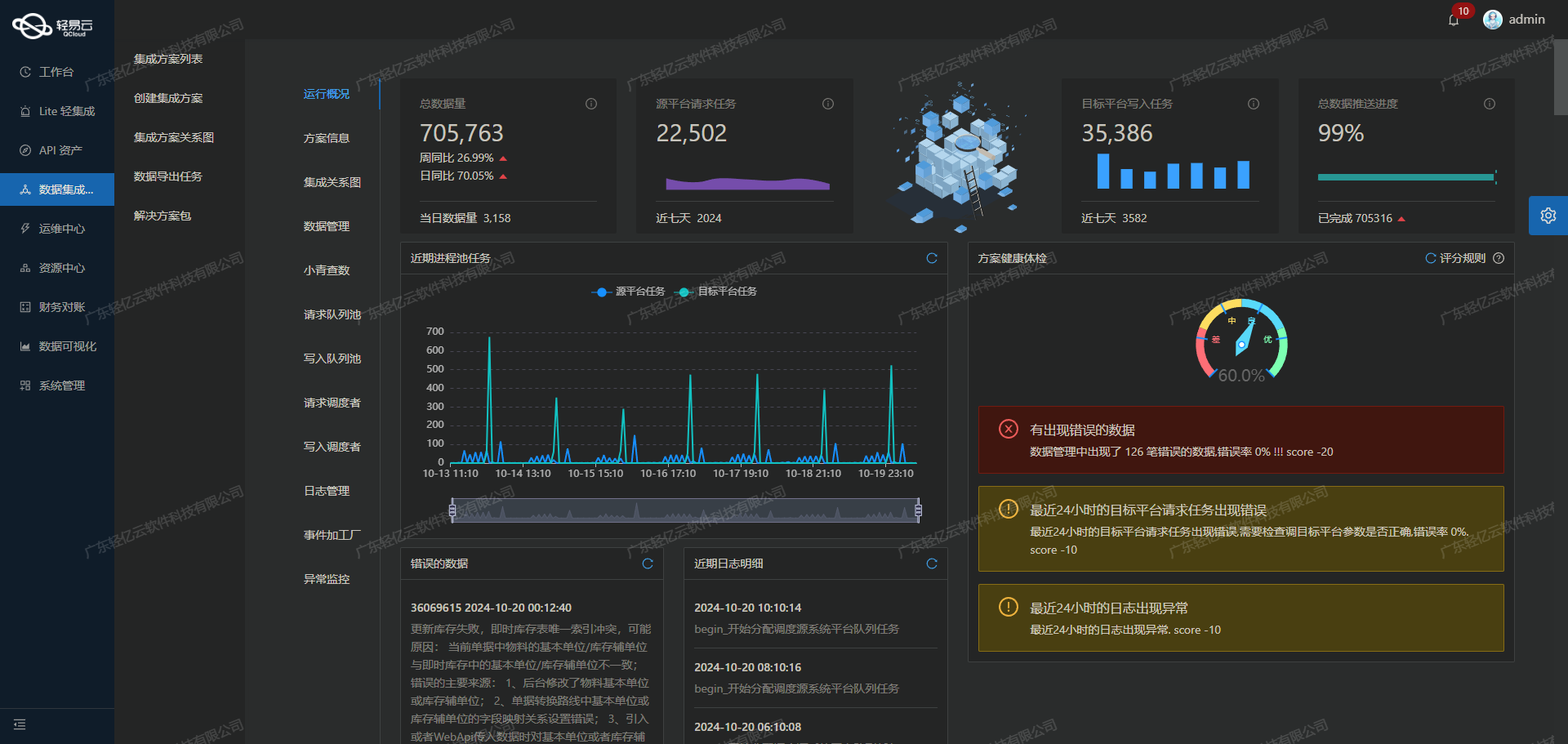

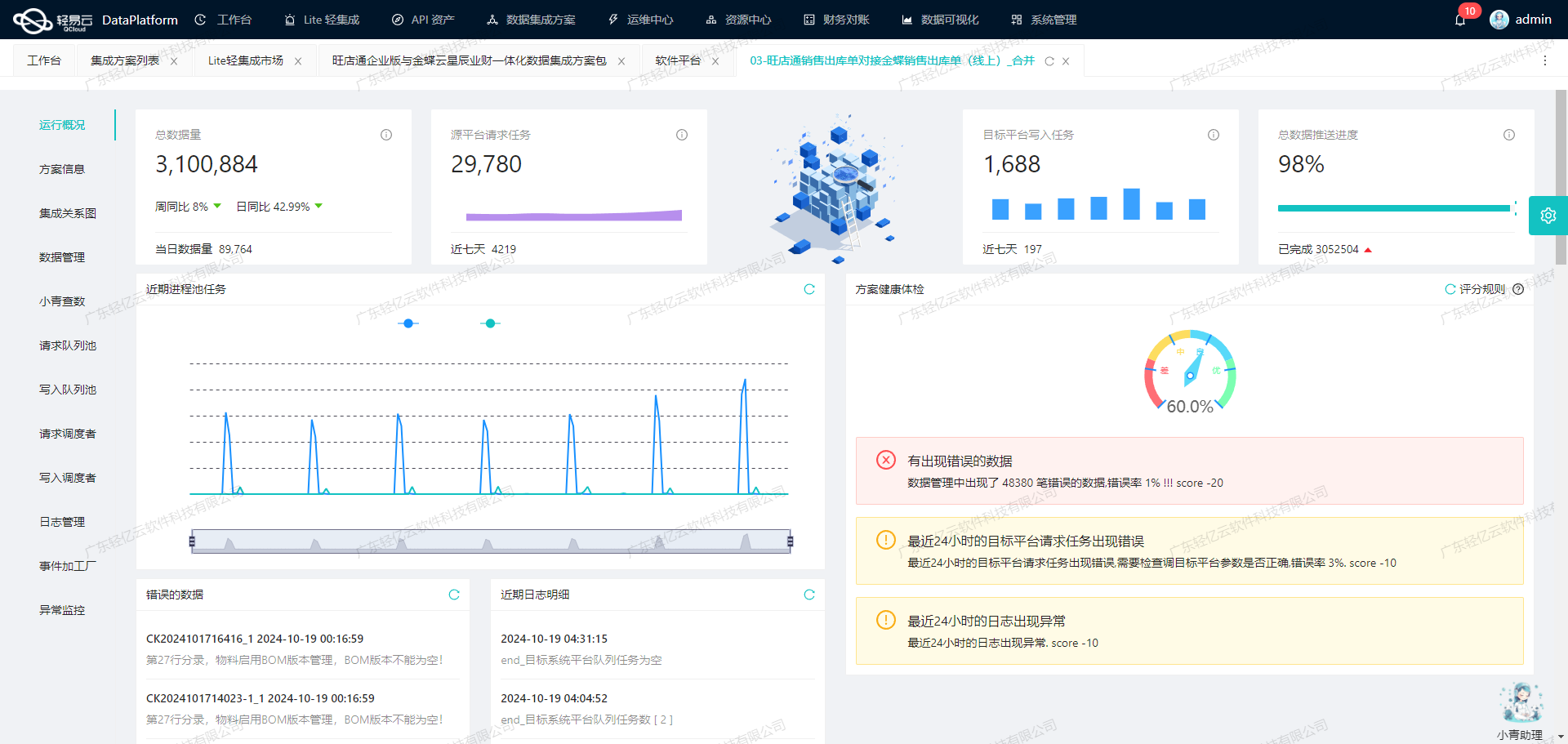

- 集中监控和告警系统:实时跟踪数据集成任务的状态和性能,确保每个环节都在掌控之中。

- 自定义数据转换逻辑:适应特定业务需求和数据结构,实现灵活的数据映射与转换。

- 分页与限流处理:针对金蝶云星空API接口的分页和限流问题,设计了有效的解决方案,以保证数据抓取过程稳定进行。

- 异常处理与错误重试机制:在对接过程中,通过实现异常处理与错误重试机制,确保即使在出现问题时也能及时恢复并继续执行。

技术要点

-

API调用与数据获取

- 使用金蝶云星空提供的

select接口,从源系统中抓取物料分组信息。为避免漏单情况发生,我们设计了定时可靠的数据抓取策略。

- 使用金蝶云星空提供的

-

数据格式差异处理

- 金蝶云星空与MySQL之间的数据格式存在差异,通过自定义转换逻辑,将源系统的数据格式转换为目标系统所需格式。

-

批量写入与性能优化

- 利用轻易云平台提供的大量数据快速写入能力,将获取的数据批量导入MySQL数据库,有效提升了整体效率。

-

实时监控与日志记录

- 集成过程中,通过集中监控系统实时跟踪任务状态,并记录详细日志,以便后续分析和问题排查。

-

异常检测与重试机制

- 在对接过程中,如果出现任何异常情况,系统会自动触发错误重试机制,确保任务能够顺利完成。

通过上述技术手段,本次W-金蝶物料分组信息集成方案不仅实现了高效、可靠的数据对接,还为后续类似项目提供了宝贵经验。在接下来的章节中,我们将详细介绍具体实施步骤及相关配置细节。

调用金蝶云星空接口select获取并加工数据

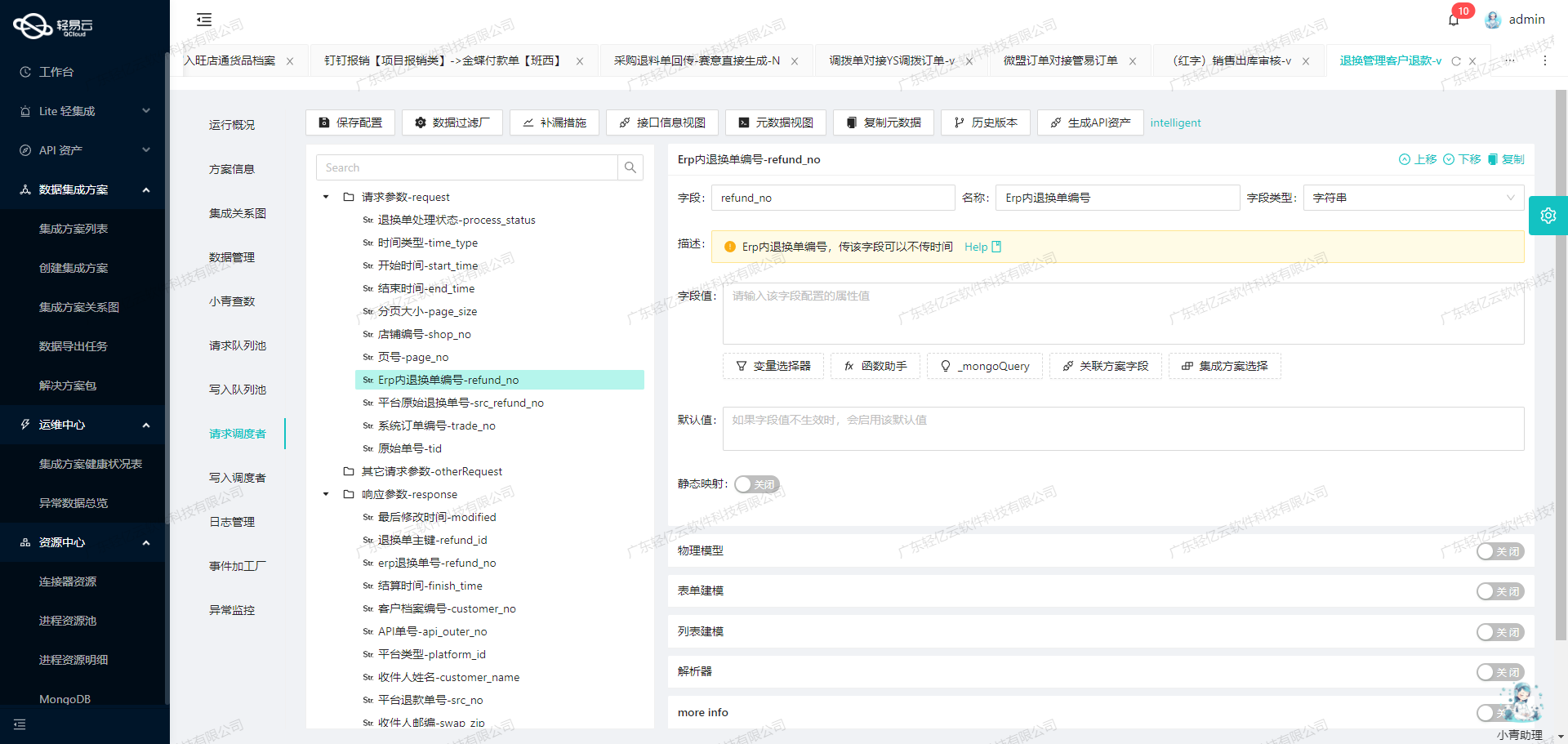

在轻易云数据集成平台的生命周期中,第一步是调用源系统金蝶云星空接口select来获取并加工数据。本文将详细探讨如何利用元数据配置实现这一过程。

接口调用与请求配置

首先,我们需要明确API的基本信息和请求参数。根据提供的元数据配置,API类型为select,请求方法为POST。以下是主要的请求字段:

- FID: 物料分组唯一标识

- FNUMBER: 物料分组编号

- FGROUPID: 分组ID

- FPARENTID: 父级分组ID

- FFULLPARENTID: 完整父级分组ID路径

- FLEFT: 左节点值

- FRIGHT: 右节点值

- FNAME: 分组名称

- FDESCRIPTION: 分组描述

- FFULLPARENTPATH: 完整父级路径

此外,还有一些其他请求参数,如分页参数和表单ID等。

数据获取与清洗

在实际操作中,首先需要构建HTTP POST请求,将上述字段作为查询条件发送至金蝶云星空接口。为了确保高效的数据处理,可以使用批量查询方式,并结合分页参数(如GroupFieldKey, GroupPkIds)来控制每次查询的数据量。

{

"FormId": "BD_MATERIAL",

"FieldKeys": ["FID", "FNUMBER", "FGROUPID", "FPARENTID", "FFULLPARENTID", "FLEFT", "FRIGHT", "FNAME", "FDESCRIPTION", "FFULLPARENTPATH"],

"FilterString": "",

"OrderString": "",

"TopRowCount": 0,

"StartRow": 0,

"Limit": 1000,

...

}通过这种方式,可以有效避免一次性拉取大量数据导致的性能问题,同时也能更好地处理分页和限流问题。

数据转换与写入准备

从金蝶云星空接口获取到原始数据后,需要对其进行必要的清洗和转换,以适应目标系统的数据结构。例如,将某些字段格式化为特定类型,或者合并、拆分字段等。这一步可以通过自定义转换逻辑来实现,以满足特定业务需求。

{

...

// 示例:将数组形式的FieldKeys转换为逗号分隔的字符串形式。

{

"field":"FieldKeys",

"parser":{"name":"ArrayToString","params":","}

}

}确保数据完整性与质量

在整个过程中,必须确保数据不漏单且质量可靠。这可以通过以下几种方式实现:

- 实时监控与日志记录:利用平台提供的集中监控和告警系统,实时跟踪每个任务的状态和性能。

- 异常处理与重试机制:设置合理的错误重试机制,当出现网络波动或接口响应异常时,可以自动重试以保证数据传输成功。

- 数据质量监控与异常检测:对接收到的数据进行校验,如检查必填字段是否为空、数值范围是否合理等,一旦发现问题及时处理。

实例应用场景

假设我们需要从金蝶云星空中获取所有物料分组的信息,并将其写入到MySQL数据库。在这个过程中,我们会先调用金蝶云星空接口,通过分页方式逐步拉取所有物料分组信息,然后对这些信息进行清洗、转换,并最终批量写入MySQL数据库。

{

...

// 示例:分页拉取物料分组信息,每次1000条。

{

"FormId": "BD_MATERIAL",

...

"StartRow": 0,

...

},

{

// 下一页,从第1001条开始拉取。

...

"StartRow": 1001,

...

}

}通过这种方式,不仅能够高效地完成大规模数据集成,还能确保每一条记录都被准确无误地处理和存储。

总结来说,在轻易云数据集成平台上调用金蝶云星空接口select获取并加工处理数据,是一个涉及多步骤、多技术点的过程。从构建HTTP请求、处理分页限流,到实施自定义转换逻辑,再到确保数据完整性与质量,每一步都至关重要。通过合理配置元数据和充分利用平台特性,可以极大提升业务透明度和效率,实现不同系统间的数据无缝对接。

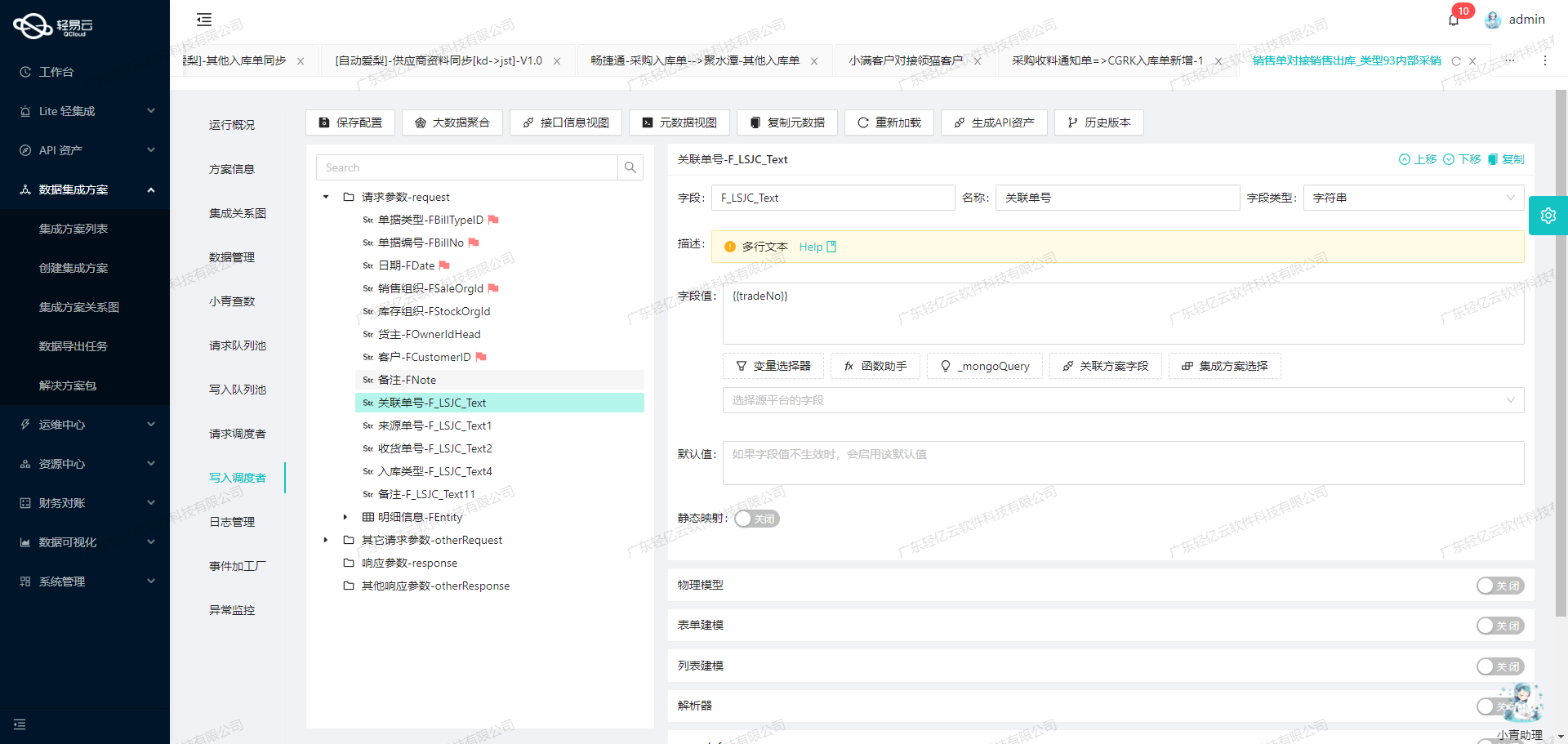

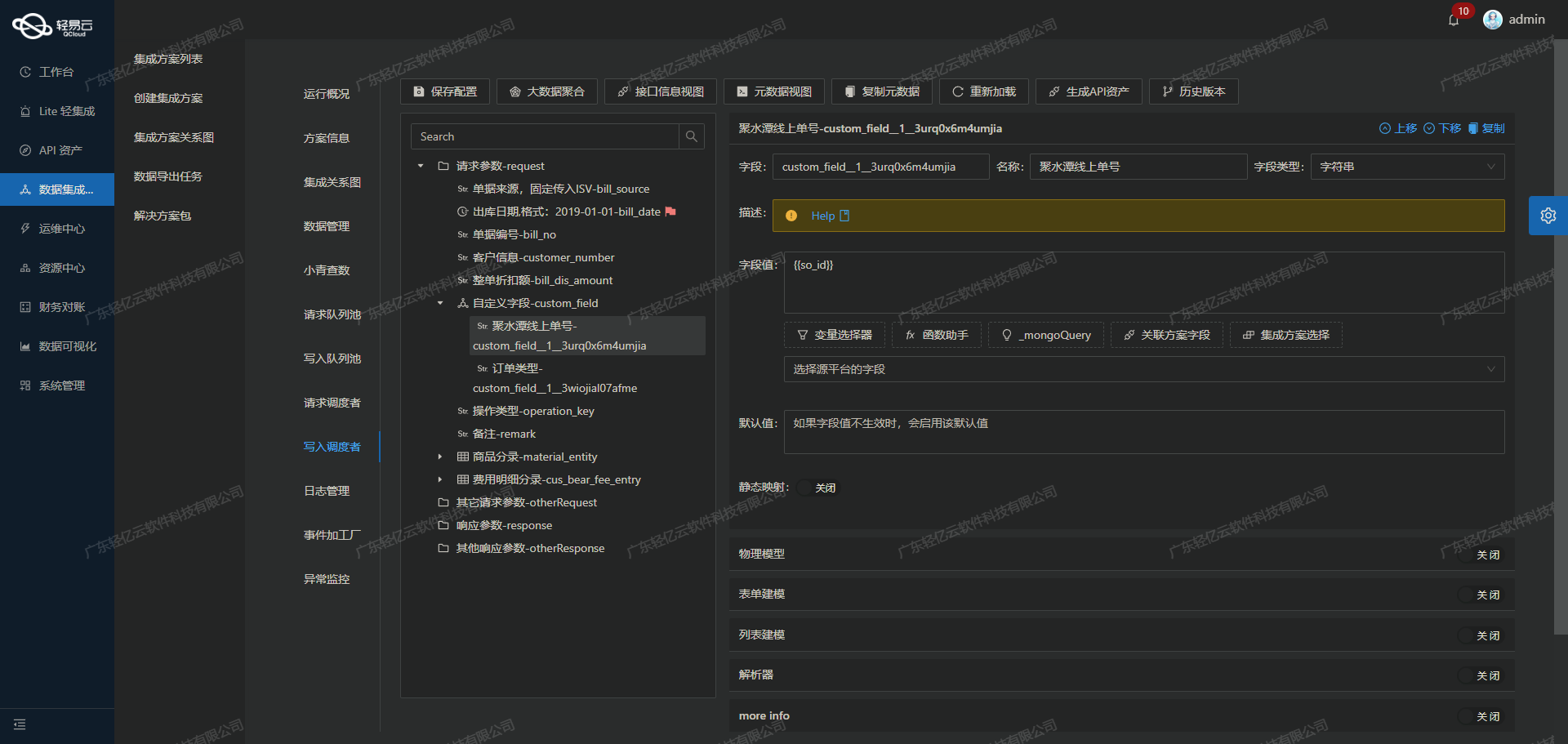

集成平台生命周期的第二步:ETL转换与数据写入MySQLAPI接口

在数据集成过程中,第二步至关重要,即将源平台的数据进行ETL转换,使其符合目标平台MySQLAPI接口的格式要求,并最终写入目标平台。本文将详细探讨这一过程中的关键技术点和注意事项。

数据请求与清洗

首先,从源平台(如金蝶云星空)获取原始数据。这一步通常涉及调用源平台的API接口,通过定时任务或触发器实现数据的定期抓取。为了确保数据完整性和一致性,需要处理接口的分页和限流问题。可以通过设计合理的分页策略和限流机制,避免因数据量过大导致的请求失败。

数据转换逻辑

在获取到原始数据后,需要对其进行清洗和转换,以适应MySQLAPI接口的格式要求。根据元数据配置示例:

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

"describe": "111",

"value": "1"

}

],

"otherRequest": [

{

"field": "main_sql",

"label": "main_sql",

"type": "string",

"describe": "111",

"value":

"INSERT INTO table_name (field_1, field_2, field_3, field_4, field_5) VALUES (:field_1, :field_2, :field_3, :field_4, :field_5)"

}

]

}这里展示了一个典型的SQL插入语句模板。在实际操作中,需要将源平台的数据字段映射到目标数据库字段。例如,将金蝶云星空中的物料分组信息字段映射到MySQL表中的相应字段。

数据质量监控与异常处理

在数据转换过程中,必须进行严格的数据质量监控和异常检测。系统应具备实时监控能力,能够及时发现并处理数据异常情况。例如,当某个字段的数据格式不符合预期时,应触发告警并记录日志,以便后续排查问题。

此外,为了提高系统的可靠性,还需要设计错误重试机制。当某次写入操作失败时,可以自动重试一定次数,确保尽可能减少因网络波动或其他不可控因素导致的数据丢失。

批量写入与高吞吐量支持

为了提升数据处理效率,轻易云数据集成平台支持批量写入和高吞吐量的数据处理能力。在实际操作中,可以将多个记录组合成一个批次,一次性写入MySQL数据库。这不仅能减少数据库连接次数,还能显著提升数据处理速度。

例如,可以将多个物料分组信息组合成一条批量插入语句,通过MySQLAPI接口一次性提交,从而实现高效的数据写入。

自定义数据映射与转换

不同业务场景下,源平台和目标平台的数据结构可能存在较大差异。因此,轻易云数据集成平台提供了自定义数据转换逻辑功能,使用户能够根据具体需求灵活调整数据映射关系。例如,可以通过自定义脚本或规则,将金蝶云星空中的复杂对象结构转换为MySQL数据库所需的简单表结构。

实时监控与日志记录

在整个ETL过程中,实时监控和日志记录是确保系统稳定运行的重要手段。通过集中式监控系统,可以实时跟踪每个集成任务的状态和性能指标。一旦出现异常情况,系统会立即生成告警,并记录详细日志供管理员分析和解决问题。

综上所述,通过合理设计ETL流程、严密的数据质量监控、灵活的自定义映射以及高效的批量写入机制,可以确保轻易云数据集成平台在将源平台数据转化为MySQLAPI接口格式并写入目标平台时,实现高效、可靠的数据集成。