BDS对账班牛财务图片转换:实现高效数据集成与优化

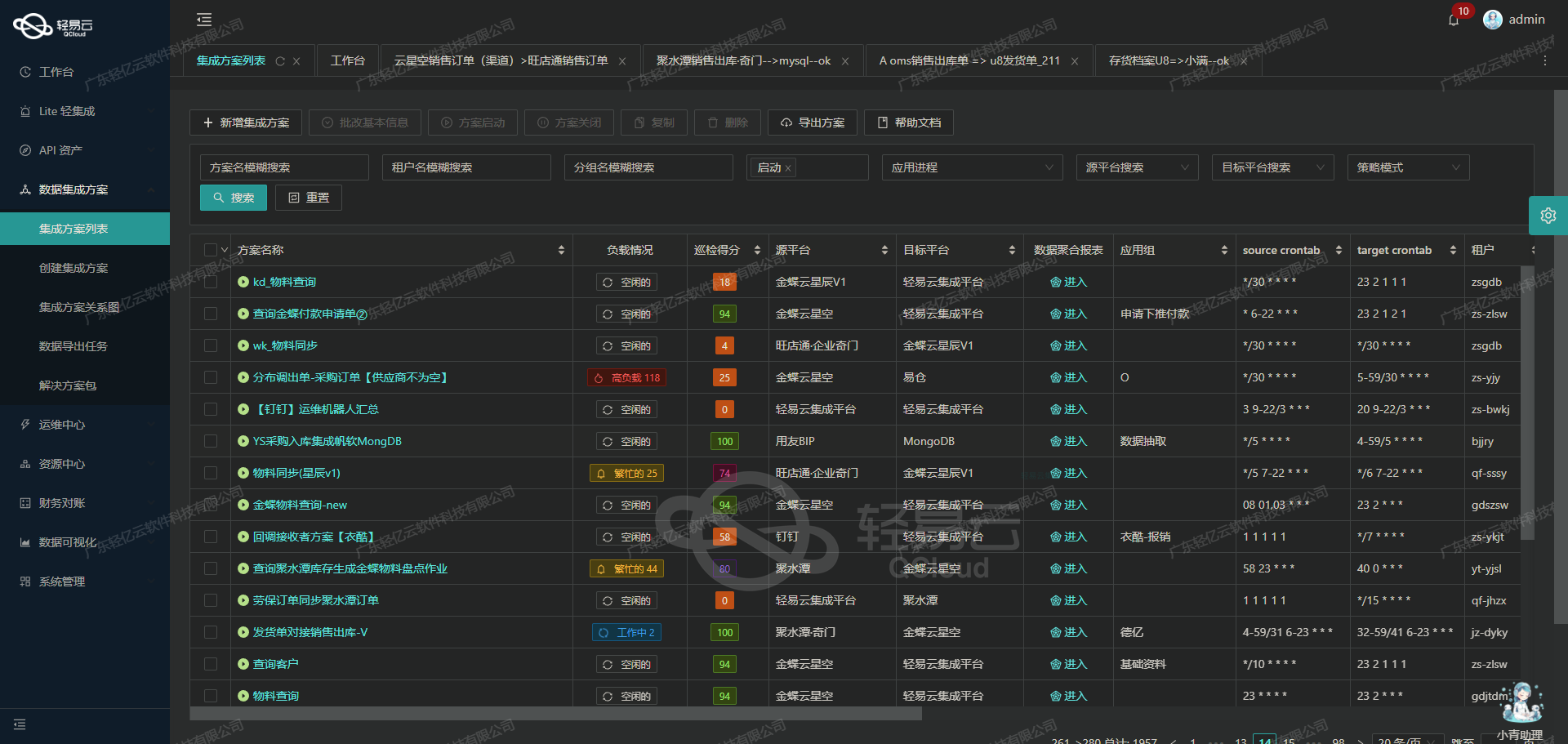

在实际业务中,如何高效地将班牛的财务数据集成到MySQL数据库是一项具有现实意义的重要课题。本文聚焦于一个具体的系统对接实例,通过轻易云数据集成平台,实现BDS对账班牛财务图片的数据转换和同步,从而确保数据处理过程透明、高效且可靠。

数据抓取与接口调用

为了定时可靠地抓取来自班牛系统的财务数据,我们使用了其提供的API接口task.list。这个接口支持分页查询,可以有效应对大规模数据传输中的限流问题。我们的目标是确保每一笔交易都能准确无误地被获取,并及时进行后续处理,以避免任何漏单现象。

以下为关键技术要点:

-

接口调用细节:

- 通过编写脚本或调度任务,定时触发API请求。

- 使用分页机制逐页读取全部所需的数据,并记录进度以防止遗漏。

-

异常处理与重试机制:

- 在网络波动或服务器响应超时时,必须具备稳健的异常捕获和处理能力。

- 实现自动重试策略,确保即使发生短暂故障,也不会导致整个任务失败。

数据转换逻辑与格式差异处理

从班牛获取的数据通常包含多种格式的信息,因此需要自定义的数据转换逻辑来适应MySQL数据库结构。这不仅涉及简单的数据类型映射,还包括复杂字段间关系的解析和转化。例如,将JSON格式的数据解析并转化为MySQL表格中的列值,这一步十分关键,以保证数据一致性和完整性。

-

自定义数据映射:

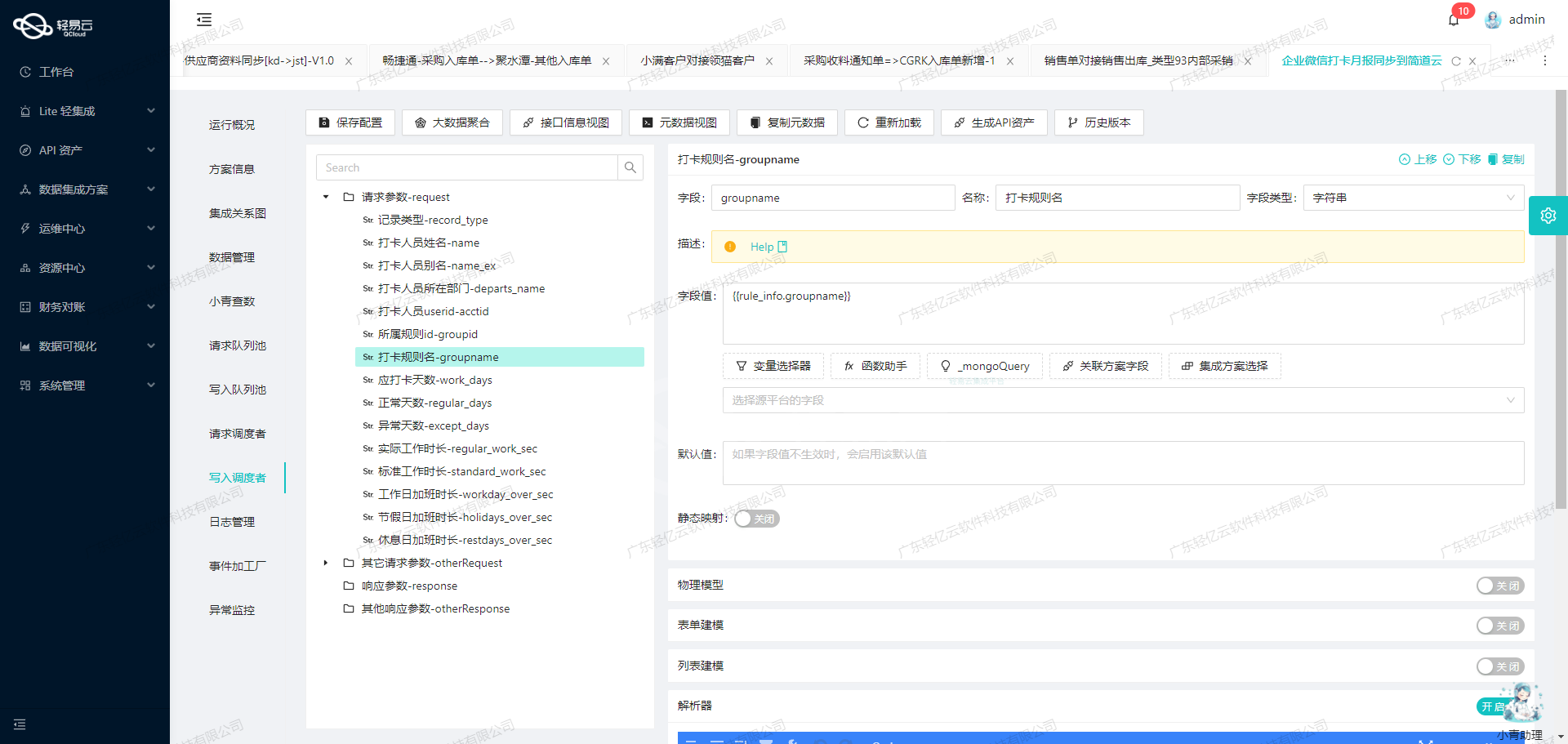

- 利用轻易云可视化设计工具配置元数据映射规则,使得不同源头间的数据能够正确匹配。

-

实时监控与质量校验:

- 集成过程中启用实时监控功能,对每个阶段进行日志记录,一旦检测到异常立即告警并采取措施修复。

高吞吐量批量写入

为了提升整体效率,我们采用了批量操作方式将大量经过转换后的班牛财务图片信息快速插入到MySQL中。利用executeReturn API,高效执行批量写入命令,显著减少单次操作耗时,并降低可能因频繁请求引起的性能瓶颈问题。

- 优化批量写入性能:

- 根据业务需求合理设定批次大小,用以平衡一次性导入数量与服务器承载能力之间的关系。

- 通过索引优化,以及存储

调用源系统班牛接口task.list获取并加工数据

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用班牛的task.list接口获取并加工数据。

接口调用配置

首先,我们需要配置调用班牛task.list接口的元数据。以下是具体的配置细节:

{

"api": "task.list",

"effect": "QUERY",

"method": "GET",

"number": "-1",

"id": "-1",

"idCheck": true,

"request": [

{"field": "project_id", "label": "群组ID", "type": "string", "value": "99994"},

{"field": "page_size", "label": "page_size", "type": "string", "value": "50"},

{"field": "page_num", "label": "page_num", "type": "string", "value": "1"},

{"field": "star_created", "label": "起始时间", "type": "string"},

{"field": "end_created", "label": "结束时间", "type": "string"},

{"field": "star_modified",

"label":"修改时间起始时间","type":"string","value":"_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL - 24 HOUR),'%Y-%m-%d %H:%i:%s')"

},

{"field":"end_modified","label":"修改时间结束时间","type":"string","value":"{{CURRENT_TIME|datetime}}"},

{"field":"task_status","label":"工作状态","type":"string","value":"1"}

],

“autoFillResponse”: true,

“condition_bk”: [

[{"field”:77212,"logic":"eqv2","value":"76615"},{"field”:5,"logic":"eqv2","value":"1"},{"field”:"77248","logic":"gt","value":"0"}]

]

}请求参数解析

project_id: 固定值为99994,表示特定的群组ID。page_size: 每页返回的数据条数,设定为50。page_num: 当前请求的页码,初始值为1。star_created: 起始创建时间,用户可自定义输入。end_created: 结束创建时间,用户可自定义输入。star_modified: 修改时间起始时间,通过函数计算得到当前时间前24小时的时间点。end_modified: 修改时间结束时间,使用当前系统时间。task_status: 工作状态,固定值为1。

数据请求与清洗

在配置好请求参数后,通过GET方法调用班牛的task.list接口。该步骤主要涉及以下几个关键点:

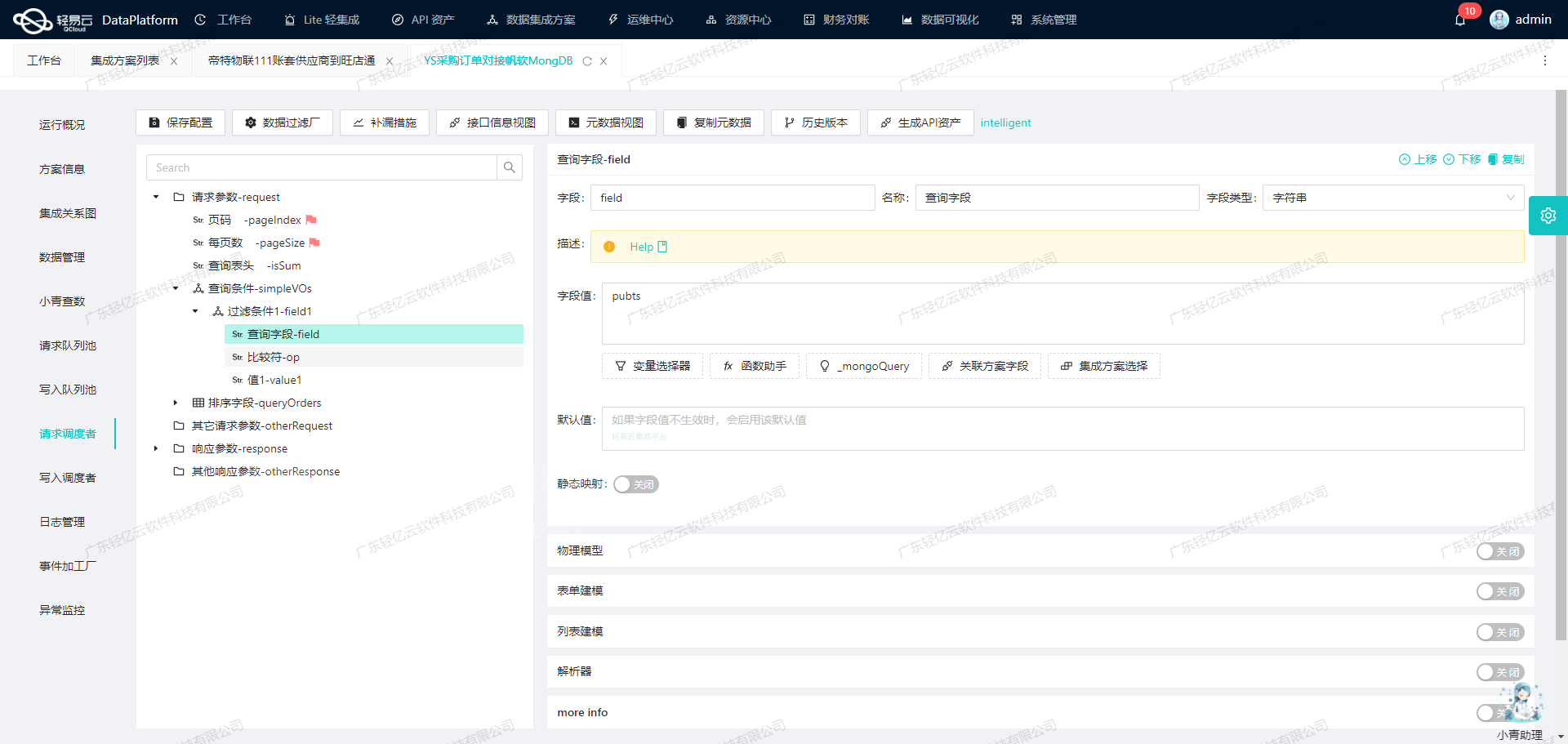

- API调用:利用轻易云平台提供的API管理功能,通过配置好的元数据发起HTTP请求。

- 数据清洗:对返回的数据进行初步清洗和过滤。例如,可以根据任务状态、修改时间等条件筛选出有效的数据记录。

数据转换与写入

在完成数据请求和清洗后,需要对数据进行转换和写入操作。这一步通常包括以下内容:

- 字段映射:将源系统的数据字段映射到目标系统所需的字段格式。例如,将班牛返回的数据字段转换为BDS对账系统所需的格式。

- 数据验证:确保所有必填字段都已正确填写,并且数据格式符合目标系统要求。

- 写入操作:将处理后的数据写入目标数据库或通过API推送到目标系统。

条件过滤与自动填充

在实际操作中,我们可能需要根据特定条件过滤数据。元数据配置中的condition_bk部分提供了条件过滤功能:

“condition_bk”: [

[{"field”:77212,"logic":"eqv2","value":"76615"},{"field”:5,"logic":"eqv2","value":"1"},{"field”:"77248","logic":"gt","value":"0"}]

]这段配置表示我们需要满足以下条件的数据:

- 字段

77212等于值76615 - 字段

5等于值1 - 字段

77248大于值0

此外,通过设置autoFillResponse: true, 我们可以自动填充响应结果,从而简化后续的数据处理流程。

通过以上步骤,我们可以高效地调用班牛接口获取并加工所需的数据,为后续的数据集成打下坚实基础。

使用轻易云数据集成平台进行ETL转换并写入MySQL API接口

在数据集成的生命周期中,第二步是将已经集成的源平台数据进行ETL转换,并转为目标平台MySQL API接口所能够接收的格式,最终写入目标平台。以下将详细探讨如何利用轻易云数据集成平台配置元数据,实现这一过程。

配置API接口

首先,我们需要配置目标API接口。根据提供的元数据配置,我们将使用executeReturn API,并通过POST方法发送请求。以下是具体的配置内容:

{

"api": "executeReturn",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{"field": "order_num", "label": "订单号", "type": "string", "value": "{{99995}}"},

{"field": "order_id", "label": "工单编号", "type": "int", "value": "{{-1}}"},

{"field": "url", "label": "附件链接", "type": "string", "value": "{{99996}}"},

{"field": "create_time", "label": "创建时间", "type":"datetime","value":"{{3}}"},

{"field":"create_by","label":"创建人","type":"int","value":"{{1}}"},

{"field":"update_time","label":"更新时间","type":"datetime","value":"{{4}}"},

{"field":"update_by","label":"更新人","type":"int","value":"{{1}}"}

]

}

],

...

}数据清洗与转换

在ETL过程中,数据清洗与转换是关键步骤。我们需要确保从源平台获取的数据能够匹配目标API接口所要求的字段和格式。例如,订单号、工单编号、附件链接等字段需要从源数据中提取并进行相应的格式转换。

{

...

{

"field": "main_sql",

...

{

...

{

...

<{order_num: }>,

<{order_id: }>,

<{url: }>,

<{create_time: }>,

<{create_by: }>,

<{update_time: }>,

<{update_by: }>

}

}

}

}在这里,我们使用占位符{{99995}}、{{-1}}等来代表从源数据中提取的具体值。这些占位符将在实际执行时被替换为真实的数据。

构建SQL语句

为了将清洗和转换后的数据写入MySQL数据库,我们需要构建相应的SQL插入语句。根据元数据配置中的main_sql字段,我们可以看到以下插入语句模板:

INSERT INTO `lhhy_srm`.`supplier_attachment`

(`order_num`,

`order_id`,

`url`,

`create_time`,

`create_by`,

`update_time`,

`update_by`)

VALUES

(<{order_num: }>,

<{order_id: }>,

<{url: }>,

<{create_time: }>,

<{create_by: }>,

<{update_time: }>,

<{update_by: }>

);这个模板定义了如何将各个字段的数据插入到supplier_attachment表中。在实际执行时,这些占位符会被替换为具体的数据值。

执行ETL流程

最后一步是执行整个ETL流程,将处理后的数据通过API接口写入MySQL数据库。轻易云数据集成平台提供了全异步操作和实时监控功能,可以确保每个环节都能顺利完成,并及时发现和解决潜在的问题。

通过以上步骤,我们实现了从源平台到目标平台的数据ETL转换和写入过程。这不仅提高了数据处理效率,还保证了数据的一致性和准确性。