YS请购单集成帆软MongoDB

在企业信息化系统中,数据的高效流转和准确集成是实现业务流程自动化的关键。本文将聚焦于一个具体的技术案例:如何通过轻易云数据集成平台,将用友BIP系统中的YS请购单数据无缝集成到MongoDB数据库中。

用友BIP与MongoDB的数据对接挑战

用友BIP作为一款功能强大的企业管理软件,其API接口提供了丰富的数据访问能力。然而,在实际操作过程中,我们需要面对以下几个技术挑战:

- 高吞吐量的数据写入能力:为了确保大量YS请购单数据能够快速、稳定地写入到MongoDB,我们必须设计高效的数据处理和传输机制。

- 实时监控与告警系统:在数据集成过程中,实时监控任务状态和性能至关重要,以便及时发现并处理潜在问题。

- 分页与限流处理:用友BIP接口存在分页和限流限制,需要合理设计请求策略以确保数据完整性。

- 数据格式差异:用友BIP与MongoDB之间的数据结构存在差异,需要自定义转换逻辑来适应特定业务需求。

- 异常处理与错误重试机制:在对接过程中,可能会遇到网络波动或接口异常等情况,必须实现可靠的错误重试机制。

解决方案概述

为了解决上述挑战,我们采用了以下技术方案:

- 定时抓取与批量处理:通过定时任务可靠地抓取用友BIP接口(/yonbip/scm/applyorder/list)中的YS请购单数据,并进行批量处理,以提高效率和稳定性。

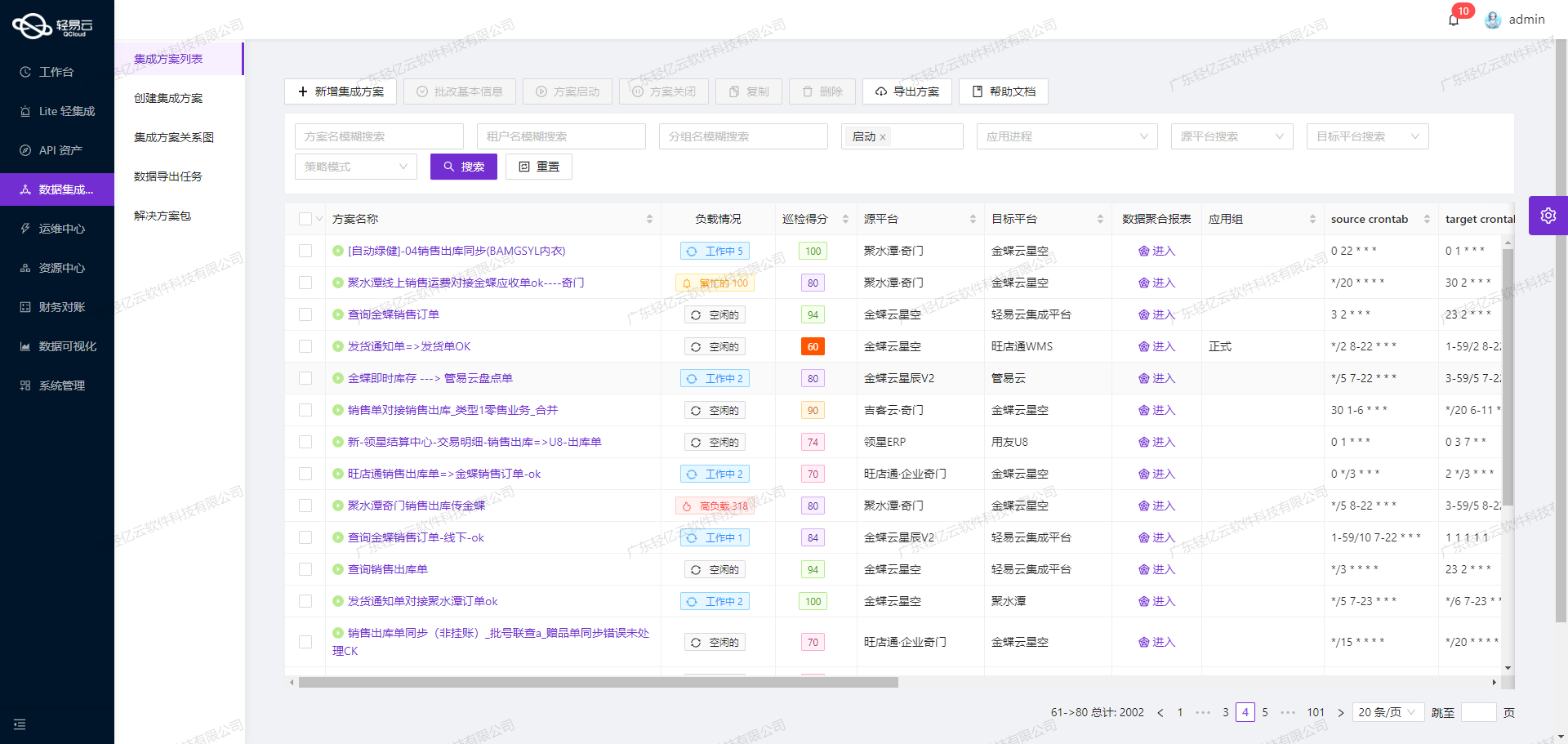

- 可视化数据流设计工具:利用轻易云平台提供的可视化工具,直观地设计和管理整个数据集成流程,使得复杂的数据转换逻辑更加清晰易懂。

- 集中监控与告警系统:通过统一的监控控制台,实时跟踪每个集成任务的执行状态,并设置告警规则以便及时响应异常情况。

- 自定义映射与转换逻辑:针对用友BIP与MongoDB之间的数据格式差异,自定义映射规则,实现精准的数据转换和写入。

以上方案不仅确保了YS请购单数据能够快速、准确地从用友BIP系统迁移到MongoDB,同时也提升了整体业务流程的透明度和效率。在后续章节中,我们将详细探讨每个步骤的具体实现方法及其技术细节。

调用用友BIP接口获取并加工数据

在数据集成的生命周期中,第一步是调用源系统接口获取数据,并对其进行初步加工处理。本文将详细探讨如何通过轻易云数据集成平台调用用友BIP接口/yonbip/scm/applyorder/list,并对返回的数据进行有效处理。

接口调用配置

首先,我们需要配置API调用的元数据。根据提供的元数据配置,可以看到该接口使用POST方法进行请求,主要参数包括页码、每页数量、查询条件和排序字段等。

{

"api": "/yonbip/scm/applyorder/list",

"method": "POST",

"request": [

{"field": "pageIndex", "value": "1"},

{"field": "pageSize", "value": "500"},

{"field": "isSum", "value": "false"},

{

"field": "simpleVOs",

"children": [

{

"field": "field1",

"children": [

{"field": "field", "value":"pubts"},

{"field":"op","value":"egt"},

{"field":"value1","value":"{{LAST_SYNC_TIME|datetime}}"}

]

}

]

},

{

"field":"queryOrders",

"children":[

{"field":"field","value":"id"},

{"field":"order","value":"asc"}

]

}

]

}数据请求与清洗

在实际操作中,我们需要确保分页和限流问题得到妥善处理,以避免因大量数据请求导致的性能瓶颈或系统崩溃。为此,可以采用以下策略:

- 分页处理:通过设置

pageIndex和pageSize参数,实现对大批量数据的分段抓取。 - 限流控制:在高频率请求时,通过调整请求间隔或使用限流机制,防止对源系统造成过大压力。

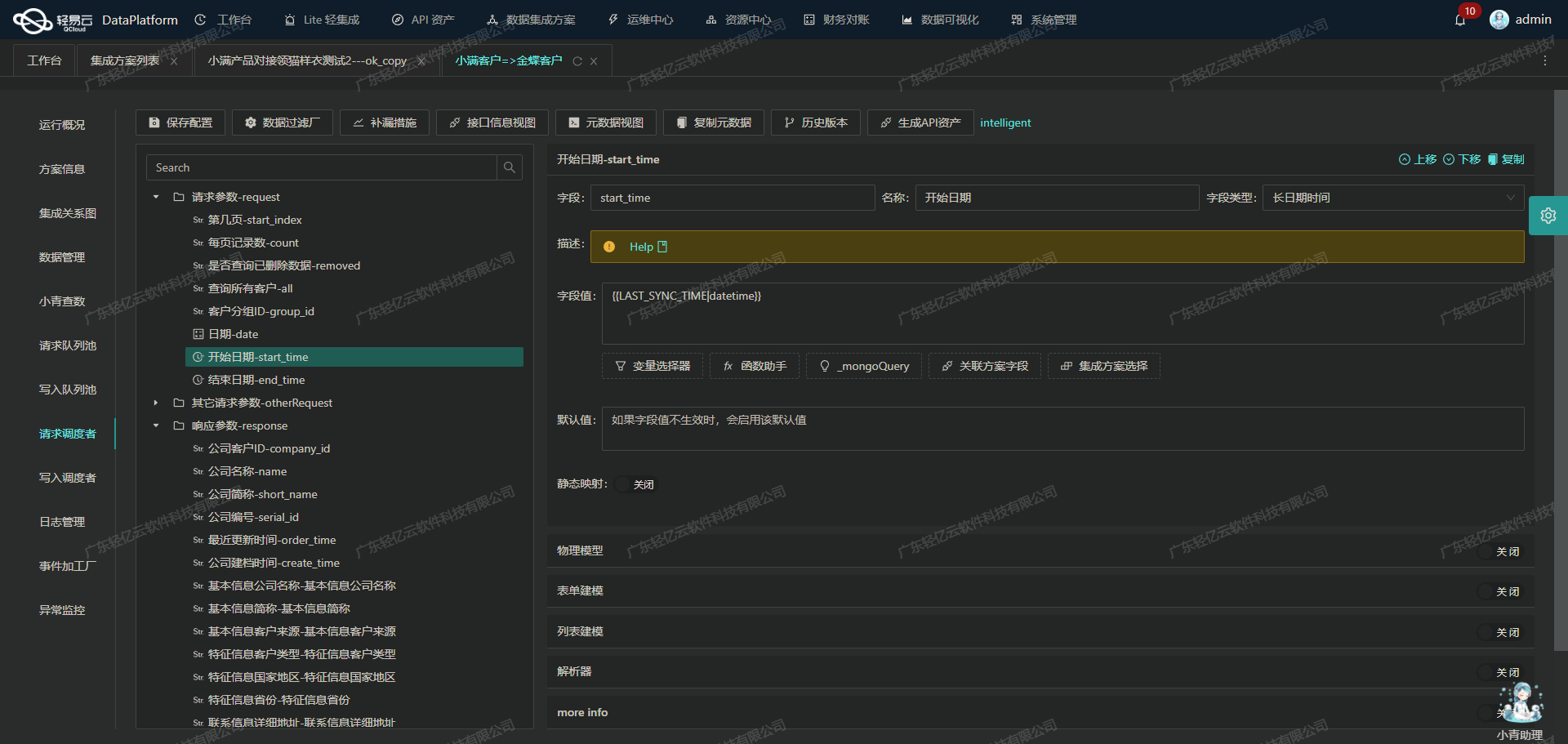

例如,在轻易云平台上可以设置定时任务,每隔一定时间段自动抓取新数据,并根据上次同步时间(LAST_SYNC_TIME)过滤已处理的数据。这不仅提高了效率,还能确保不漏单。

数据转换与写入

获取到原始数据后,需要对其进行清洗和转换,以适应目标系统(如MongoDB)的需求。常见的数据清洗操作包括:

- 字段映射:将源系统中的字段名转换为目标系统所需的字段名。

- 格式转换:例如,将日期字符串转换为标准日期格式。

- 异常处理:对于缺失或错误的数据进行补全或修正。

轻易云平台支持自定义的数据转换逻辑,使得这些操作变得更加灵活。例如,可以编写脚本来实现复杂的业务逻辑,如下所示:

def transform_data(record):

# 字段映射

transformed_record = {

'order_id': record['apporders_id'],

'order_code': record['code'],

'timestamp': convert_to_datetime(record['pubts'])

}

# 异常处理

if not transformed_record['timestamp']:

raise ValueError("Invalid timestamp")

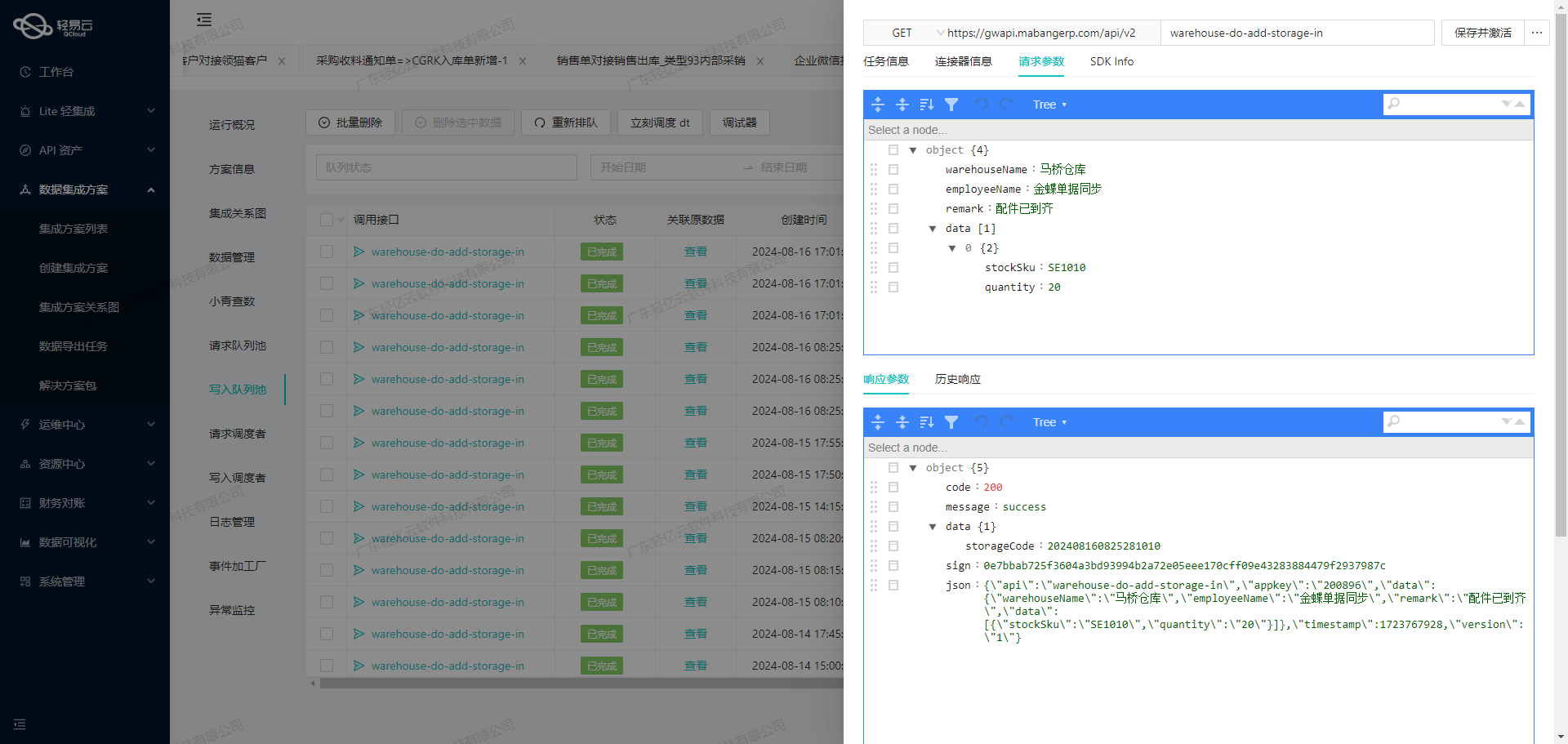

return transformed_record实时监控与日志记录

为了确保整个过程透明可控,轻易云平台提供了实时监控和日志记录功能。通过集中监控界面,可以实时跟踪每个任务的执行状态,并及时发现和解决潜在问题。此外,日志记录功能能够详细记录每次API调用及其结果,为后续排查问题提供依据。

总结

通过合理配置API调用参数、实施有效的数据清洗与转换策略,以及利用实时监控与日志记录功能,我们可以高效地完成从用友BIP接口获取并加工YS请购单数据的任务。这不仅提升了业务流程的透明度和效率,也为后续的数据分析和决策提供了坚实基础。

轻易云数据集成平台:将YS请购单数据转换并写入MongoDB

在数据集成生命周期的第二步中,我们需要将已经从源平台(如用友BIP)获取到的数据进行ETL(Extract, Transform, Load)转换,并将其转为目标平台MongoDBAPI接口能够接收的格式,最终写入MongoDB。这一过程需要处理数据格式差异、分页限流问题以及确保高效、可靠的数据传输。

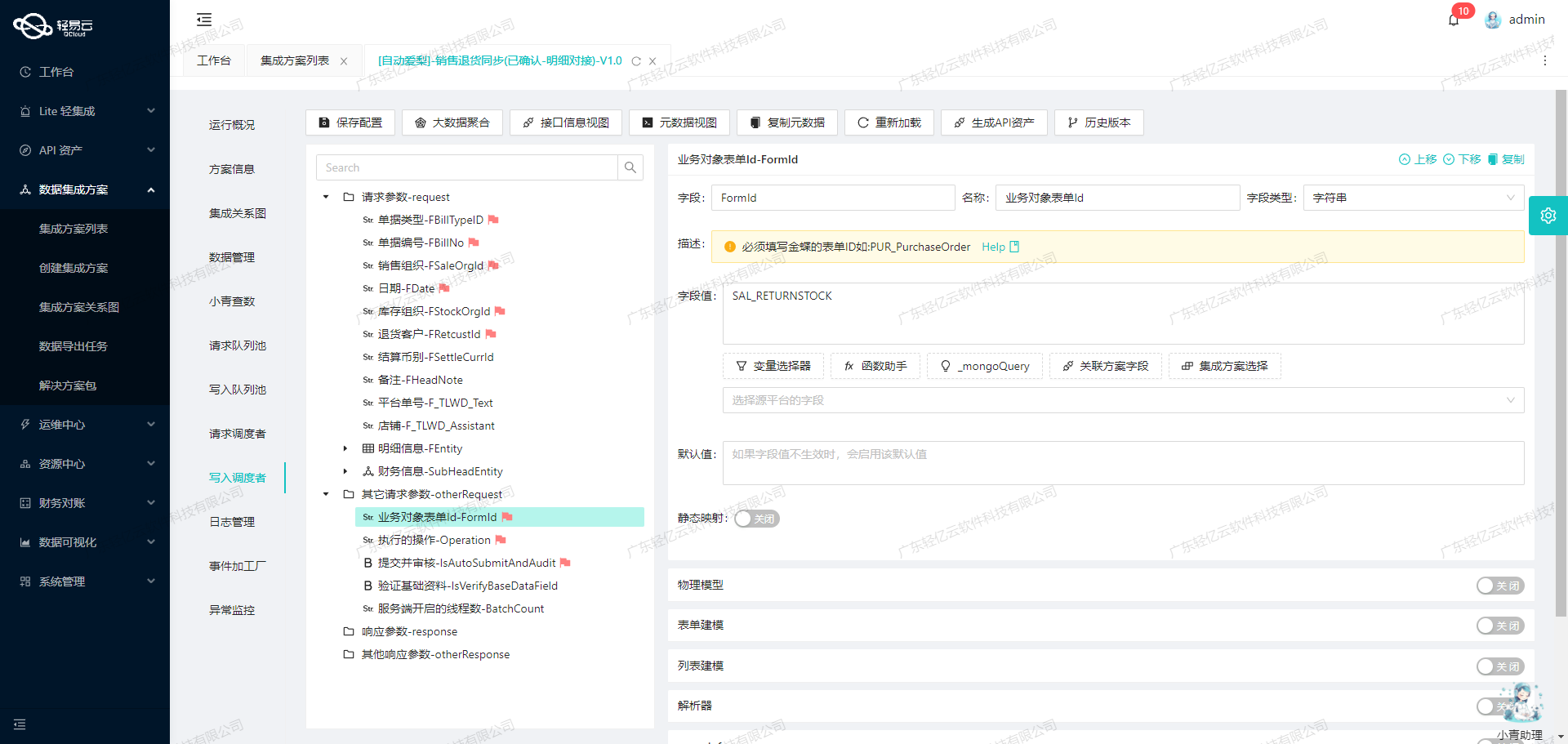

数据格式转换

首先,我们需要将源平台的数据结构转换为目标平台MongoDB所能接受的格式。以下是一个元数据配置示例:

{

"api": "Insert",

"method": "POST",

"number": "id",

"request": [

{"field":"applyorders_requirementDate","value":"{applyorders_requirementDate}"},

{"field":"applyOrder_orderMoneyRatio","value":"{applyOrder_orderMoneyRatio}"},

{"field":"createTime","value":"{createTime}"}

// 更多字段...

],

"otherRequest": [

{"field":"collectionName","value":"PurchasePlan"}

],

"buildModel": true

}通过上述配置,我们可以看到如何将不同字段从源平台映射到目标平台。每个字段都有明确的映射关系,例如applyorders_requirementDate被映射为需求日期,以确保数据在转换过程中保持一致性。

数据清洗与转换

为了适应MongoDB的存储要求,我们需要对数据进行清洗和转换。例如,将日期格式统一为ISO标准,将浮点数精度调整到目标系统所需的精度等。以下是一些常见的转换逻辑:

-

日期格式统一:

def convert_date(date_str): # 假设输入日期格式为YYYY-MM-DD return datetime.strptime(date_str, '%Y-%m-%d').isoformat() -

浮点数精度调整:

def adjust_precision(value, precision=2): return round(value, precision)

批量写入与分页处理

为了提高数据写入效率,轻易云支持批量写入功能。可以通过批量请求接口,将多个记录一次性写入MongoDB,从而减少网络延迟和IO操作次数。

{

"api": "/batchInsert",

"method": "POST",

"request": [

{"field":"documents","value":"[{...}, {...}, ...]"},

{"field":"collectionName","value":"PurchasePlan"}

]

}对于分页处理,可以通过设置分页参数来逐页获取数据,并在每页处理完成后进行下一页的请求。

{

"api": "/yonbip/scm/applyorder/list",

"method": "GET",

"request": [

{"field":"pageNumber","value":"1"},

{"field":"pageSize","value":"100"}

]

}异常处理与错误重试机制

在数据集成过程中,可能会遇到网络故障、接口超时等问题。轻易云提供了完善的异常处理和错误重试机制,以确保数据传输的可靠性。例如,当请求失败时,可以自动进行重试,并记录错误日志以便后续分析和处理。

def retry_request(api_call, retries=3):

for attempt in range(retries):

try:

response = api_call()

if response.status_code == 200:

return response.json()

except Exception as e:

log_error(e)

if attempt < retries - 1:

time.sleep(2 ** attempt) # 指数退避算法

else:

raise e实时监控与日志记录

为了确保整个ETL过程透明可控,轻易云提供了实时监控和日志记录功能。通过集中监控系统,可以实时跟踪每个数据集成任务的状态和性能,并及时发现和处理异常情况。

{

"monitoring": {

"enable": true,

"logLevel": "INFO"

}

}通过上述步骤,我们可以高效地将YS请购单的数据从用友BIP系统转换并写入MongoDB,确保数据集成过程中的高效性和可靠性。