畅捷通T+数据集成到聚水潭的技术案例分享

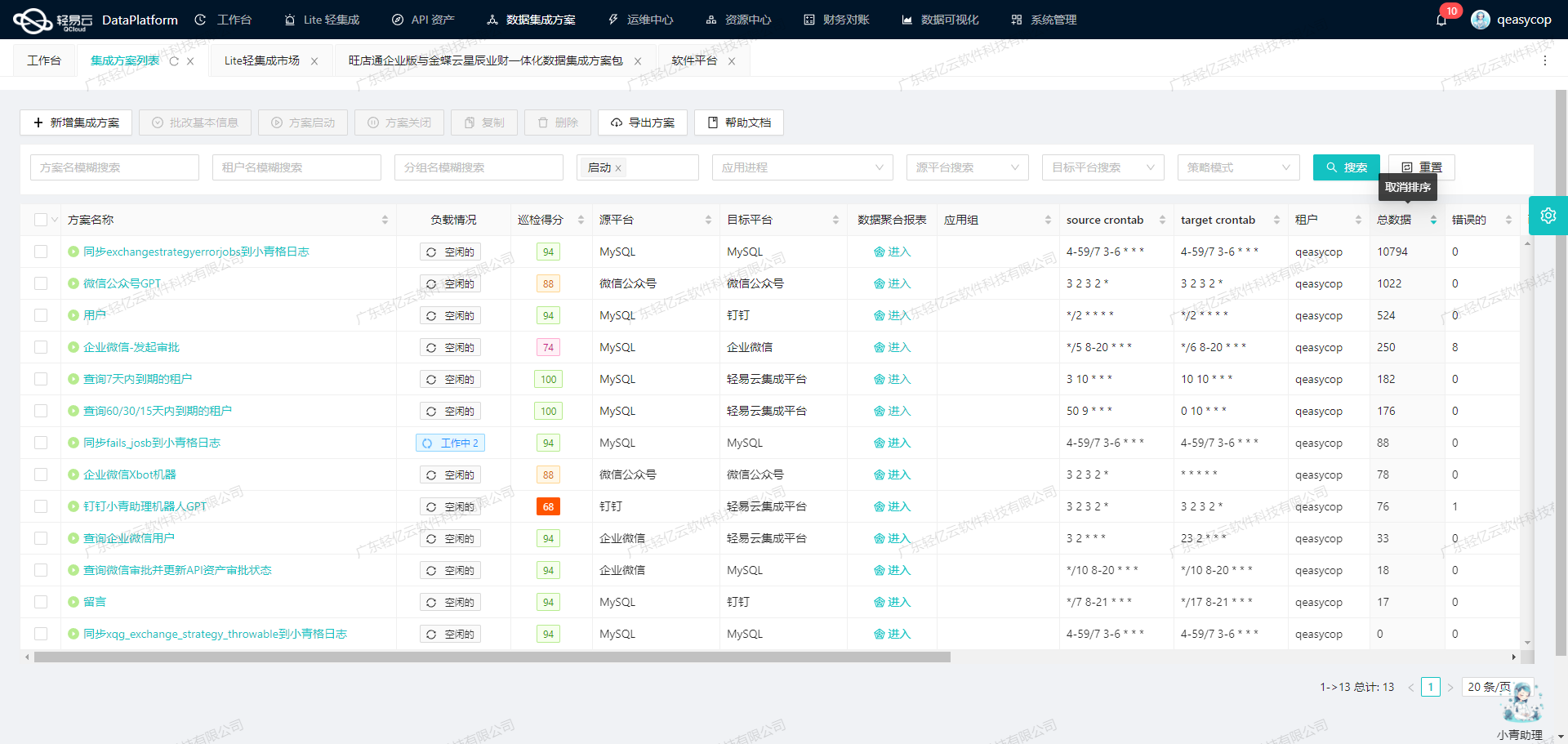

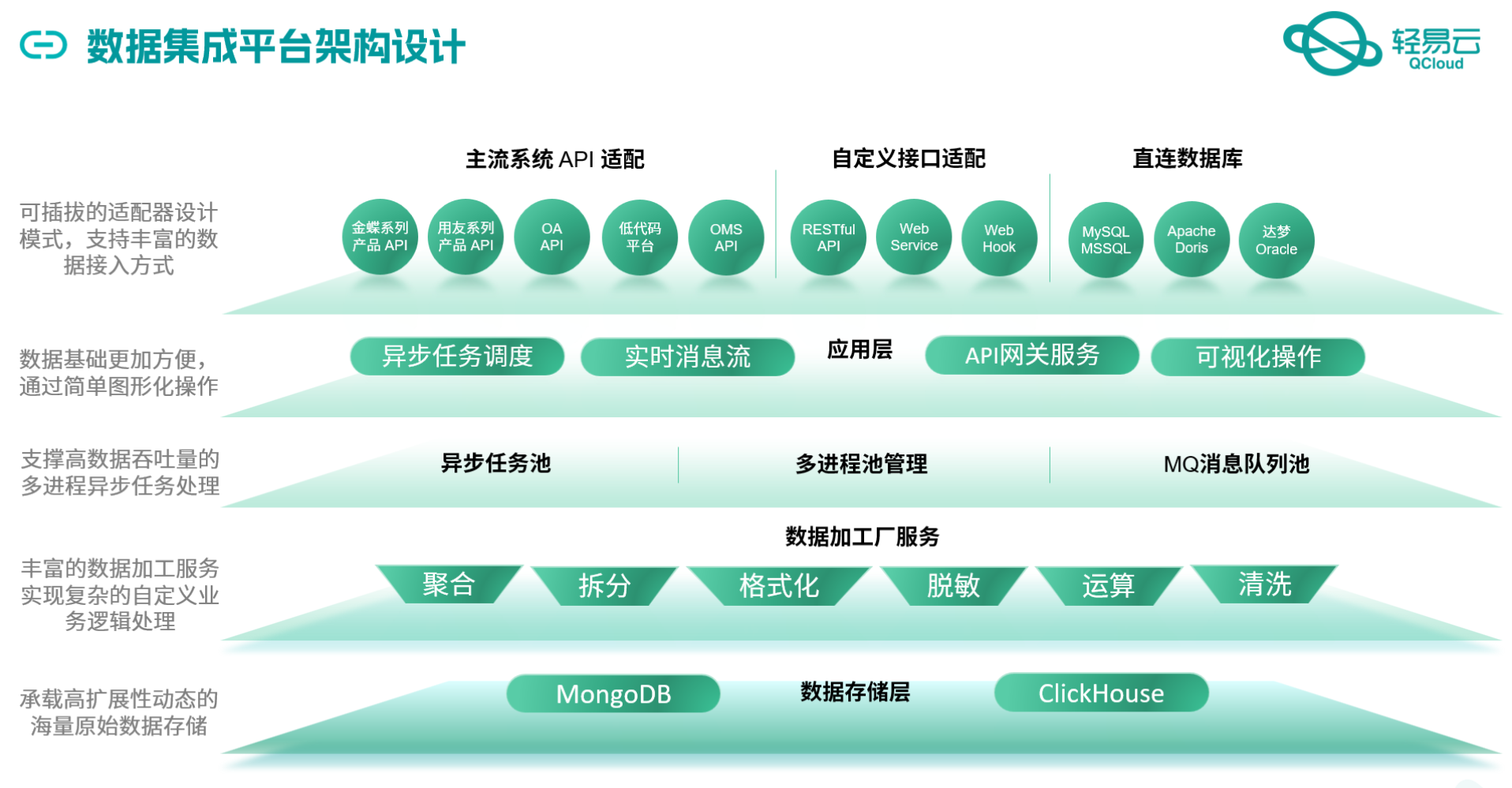

在企业信息化管理中,数据的高效流动和准确对接是业务顺利运行的关键。本文将聚焦于一个具体的系统对接集成案例:如何通过轻易云数据集成平台,将畅捷通T+中的其他出库单数据无缝集成到聚水潭系统中。本次方案名称为“T+其他出库单-->聚水潭其他出库单--ikk”。

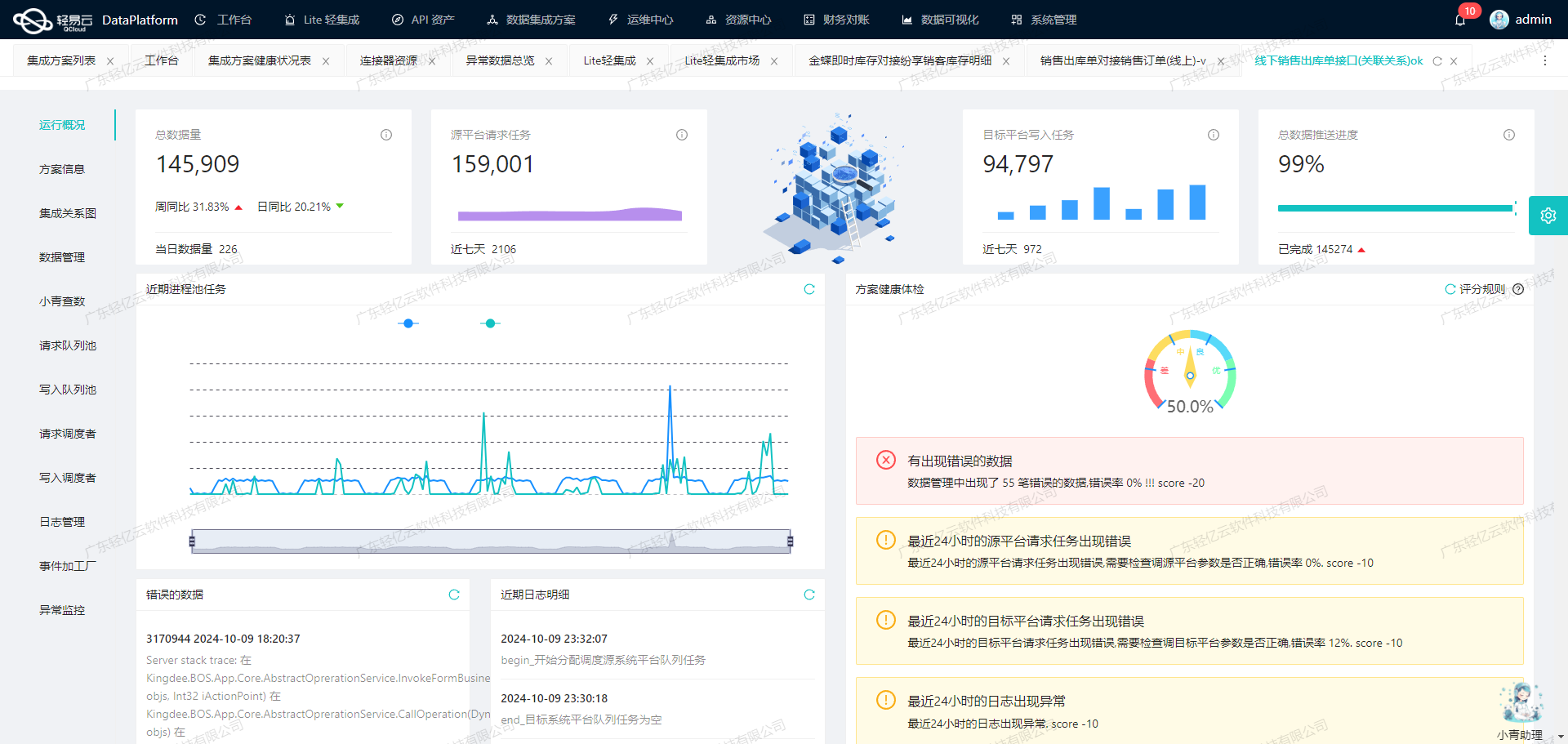

为了实现这一目标,我们利用了轻易云平台的一系列强大特性,包括高吞吐量的数据写入能力、实时监控与告警系统、自定义数据转换逻辑以及可视化的数据流设计工具。这些特性确保了我们能够快速、高效地处理大量数据,并且在整个过程中保持高度透明和可控。

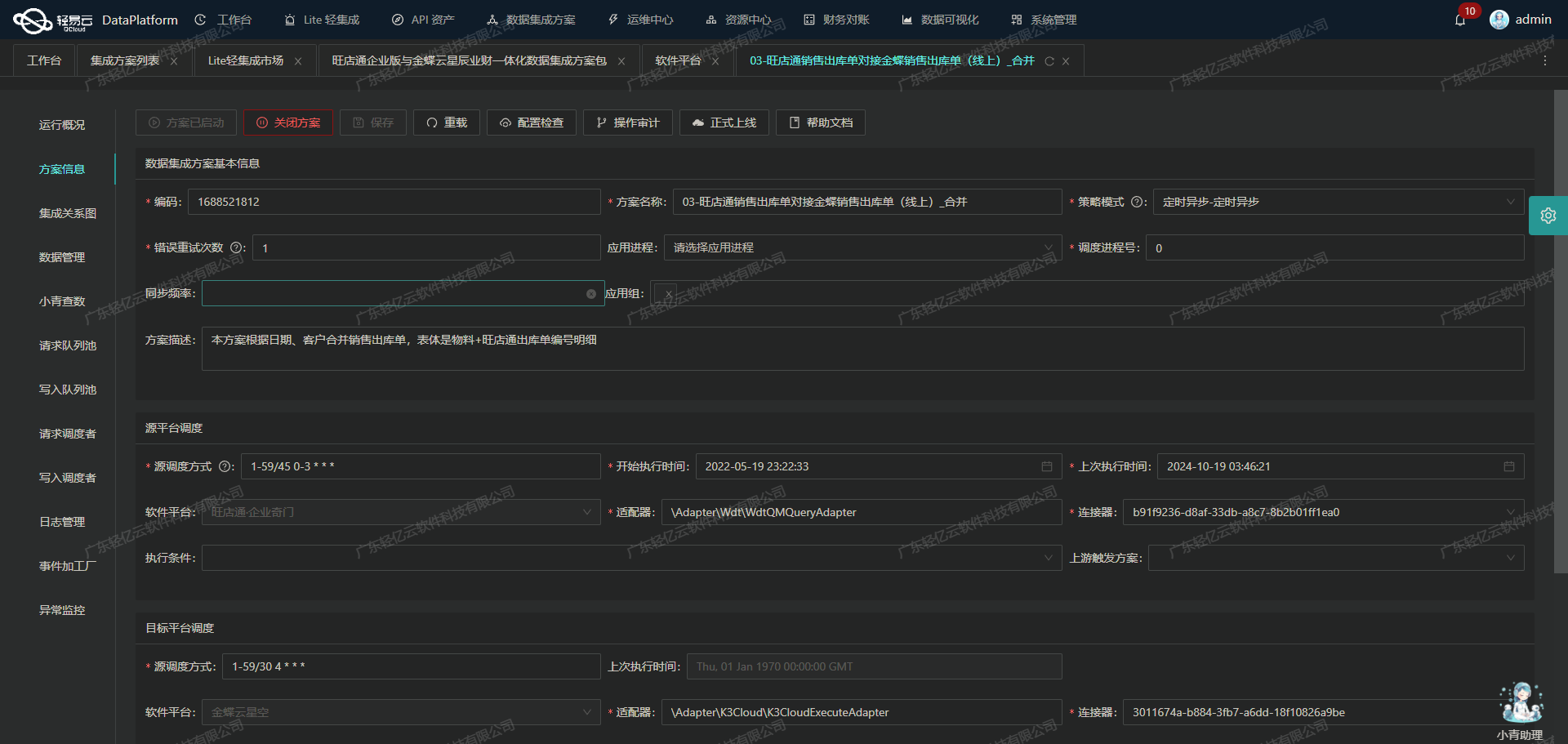

首先,畅捷通T+提供了丰富的API接口,其中获取其他出库单数据的API为/tplus/api/v2/OtherDispatchOpenApi/FindVoucherList。通过定时可靠地抓取该接口的数据,我们能够确保不会遗漏任何一条重要记录。同时,为了解决分页和限流问题,我们设计了一套智能调度机制,以保证数据抓取过程的稳定性和连续性。

在数据传输到聚水潭之前,需要进行一定的数据转换和映射,以适应目标平台的结构要求。轻易云平台支持自定义的数据转换逻辑,使得这一过程变得更加灵活和高效。此外,通过其提供的可视化设计工具,我们可以直观地构建和管理整个数据流,极大简化了复杂操作。

最后,针对聚水潭系统,我们使用其开放API /open/jushuitan/otherinout/upload 进行批量数据写入。在这个过程中,集中监控与告警系统发挥了重要作用,它实时跟踪每个任务的状态和性能,一旦出现异常情况,可以及时采取措施进行错误重试,从而保障了整体流程的可靠性。

通过上述步骤,我们成功实现了畅捷通T+与聚水潭之间的数据无缝对接,不仅提升了业务效率,还确保了数据处理过程中的准确性和完整性。后续章节将详细介绍具体实施方案及技术细节。

调用畅捷通T+接口获取并加工数据的技术实现

在数据集成过程中,调用源系统接口是关键的一步。本文将详细探讨如何通过轻易云数据集成平台调用畅捷通T+接口/tplus/api/v2/OtherDispatchOpenApi/FindVoucherList来获取并加工数据。

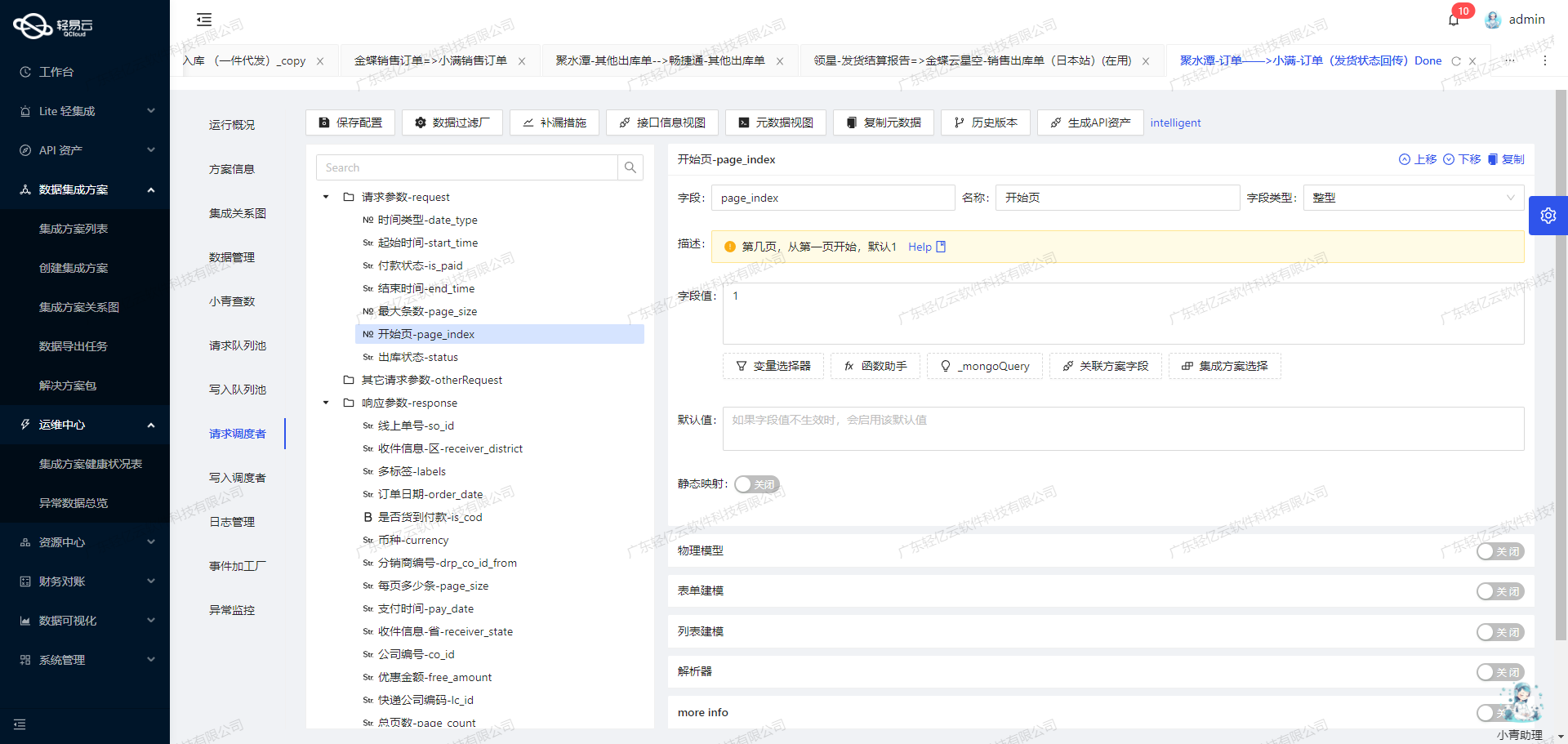

接口配置与请求参数

首先,我们需要配置元数据以便正确调用接口。以下是关键的元数据配置:

{

"api": "/tplus/api/v2/OtherDispatchOpenApi/FindVoucherList",

"method": "POST",

"request": [

{"field": "selectFields", "value": "VoucherCode"},

{"field": "pageIndex", "value": "1"},

{"field": "pageSize", "value": "10"},

{

"field": "paramDic_1",

"children": [

{"field": "key", "value": "RDRecord__VoucherDate"},

{"field": "value",

"value":"{{LAST_SYNC_TIME|date}},{{CURRENT_TIME|date}}"}

]

},

{

"field": "paramDic_2",

"children":[

{"field":"key","value":"RDRecord__VoucherState__Code"},

{"field":"value","value":"01,01"}

]

}

],

...

}这些参数定义了我们需要从畅捷通T+系统中查询的数据字段、分页信息以及过滤条件。

数据请求与清洗

在发起请求时,我们使用POST方法向指定API发送请求。为了确保高效的数据处理和避免漏单,需要特别注意分页和限流问题。通过设置pageIndex和pageSize,可以逐页获取数据,并根据返回结果判断是否需要继续请求下一页。

例如,初始请求可能如下:

{

selectFields: 'VoucherCode',

pageIndex: '1',

pageSize: '10',

paramDic_1: { key: 'RDRecord__VoucherDate', value: '{{LAST_SYNC_TIME|date}},{{CURRENT_TIME|date}}' },

paramDic_2: { key: 'RDRecord__VoucherState__Code', value: '01,01' }

}响应结果会包含多个凭证记录,我们需要对这些记录进行清洗和转换,以适应目标系统(如聚水潭)的需求。

数据转换与写入

在清洗过程中,可以利用轻易云平台提供的自定义数据转换逻辑,将原始数据格式转化为目标格式。例如,将日期格式统一、字段名称映射等操作。这一步骤至关重要,因为不同系统之间的数据结构往往存在差异。

举例来说,如果源系统返回的日期格式为"YYYY-MM-DD",而目标系统要求"DD/MM/YYYY",则需进行相应的转换。此外,还需确保所有必填字段都已正确填充,并且没有遗漏任何重要信息。

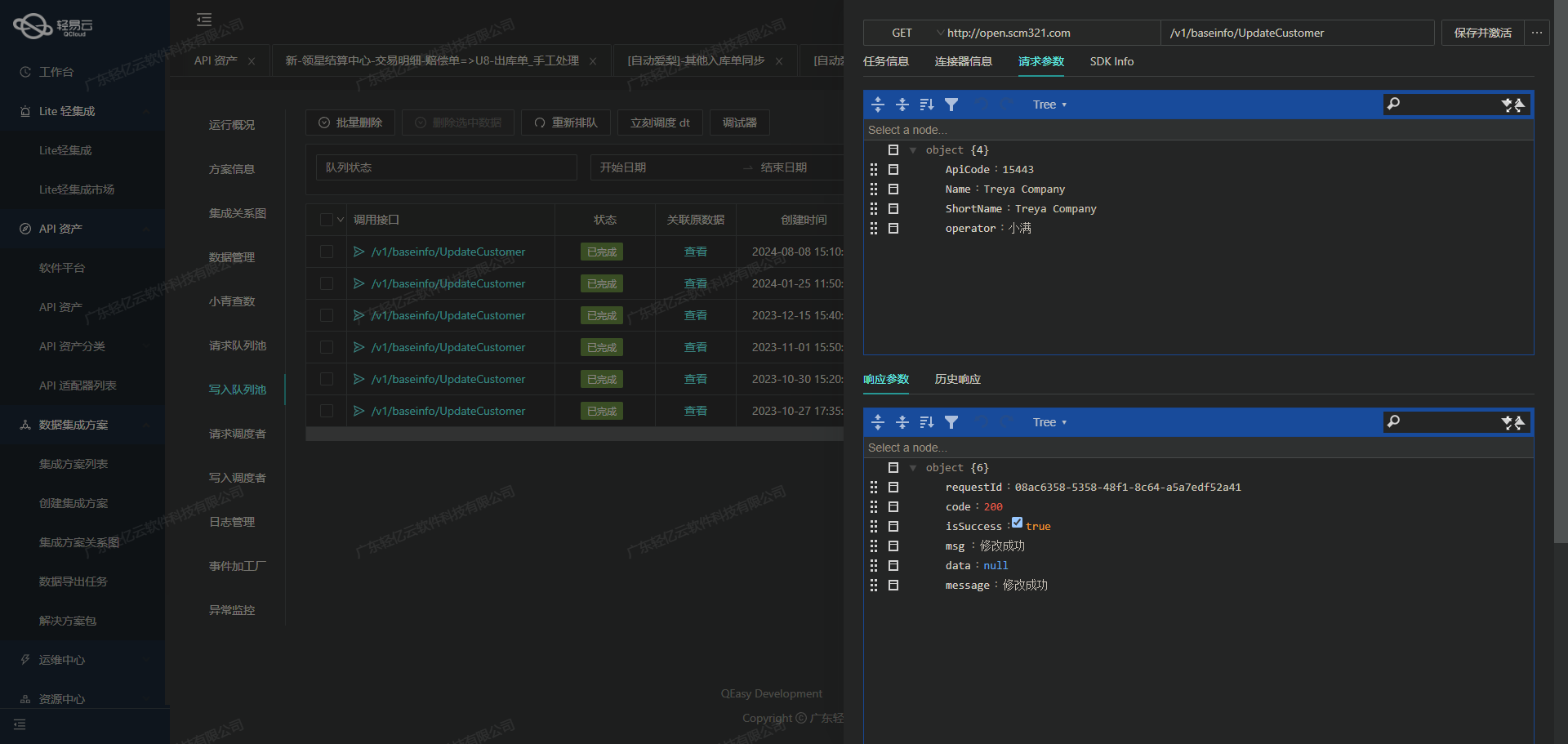

实时监控与异常处理

轻易云平台提供了强大的实时监控和告警功能,可以帮助我们及时发现并处理任何异常情况。在调用API时,可能会遇到网络延迟、接口限流等问题,这些都可以通过平台内置的重试机制来解决。同时,通过日志记录功能,可以追踪每次API调用的详细信息,为后续排查问题提供依据。

例如,当检测到某次API调用失败时,可以自动触发重试机制,并记录失败原因及重试次数。如果多次重试仍然失败,则发送告警通知给相关运维人员,以便及时采取措施。

总结

通过上述步骤,我们能够高效地从畅捷通T+系统中获取所需的数据,并经过清洗和转换后写入目标系统。这不仅提高了数据处理的效率,也确保了数据的一致性和完整性。在整个过程中,轻易云平台提供的可视化工具、实时监控及异常处理机制发挥了重要作用,使得复杂的数据集成任务变得更加简单直观。

集成方案:T+其他出库单-->聚水潭其他出库单

在实现T+其他出库单到聚水潭其他出库单的集成过程中,ETL(Extract, Transform, Load)转换是关键步骤。本文将详细探讨如何将从T+系统中提取的数据通过轻易云数据集成平台进行转换,并最终通过聚水潭API接口上传至目标平台。

数据提取与转换

首先,从畅捷通T+系统提取数据。假设我们已经通过API /tplus/api/v2/OtherDispatchOpenApi/FindVoucherList 获取了相关的出库单数据。接下来,我们需要将这些数据进行清洗和转换,以符合聚水潭API接口的要求。

以下是元数据配置中的关键字段及其转换规则:

is_confirm和excute_confirming:这两个字段用于标识是否确认和审核单据,分别设置为固定值 "1" 和 "true"。warehouse:仓库编号需要根据T+系统中的值进行映射。例如,当 T+ 的仓库编号为 '2' 时,映射为 '4',否则映射为 '1'。type:固定为 "out",表示出库类型。external_id:对应于 T+ 出库单的外部单号{Code}。remark:备注信息,对应于 T+ 系统中的{Memo}字段。

数据结构映射

为了确保数据能够被正确写入聚水潭系统,需要对数据结构进行适当的映射和转换。元数据配置中定义了具体的字段映射规则:

{

"field": "items",

"label": "items",

"type": "array",

"value": "RDRecordDetails",

"children": [

{

"field": "sku_id",

"label": "商品编码",

"type": "string",

"value": "{{RDRecordDetails.Inventory.Code}}"

},

{

"field": "qty",

"label": "入库数量",

"type": "string",

"value": "{{RDRecordDetails.Quantity}}"

},

{

"field": "sale_price",

"label": "单价",

"type": "bool",

"value": "{{RDRecordDetails.Price}}"

}

]

}在这个配置中,items 字段是一个数组,每个元素包含商品编码、数量和单价。这些字段需要从 T+ 系统中的 RDRecordDetails 对象中提取并转换。

数据写入

完成上述数据转换后,通过调用聚水潭API接口 /open/jushuitan/otherinout/upload 将处理后的数据写入目标平台。请求方法为 POST,并且需要确保请求体符合 API 的格式要求。

{

"is_confirm": true,

"excute_confirming": true,

...

}异常处理与重试机制

在实际操作中,可能会遇到各种异常情况,例如网络问题或接口限流。为了确保数据能够可靠地写入,需要实现异常处理与重试机制。当检测到错误时,可以记录日志并触发重试逻辑,以保证任务最终成功完成。

数据质量监控

为了保证集成过程中的数据质量,可以利用平台提供的数据质量监控和异常检测功能。在每个步骤都进行检查,及时发现并处理任何潜在的问题。这不仅提高了集成过程的可靠性,也确保了最终的数据准确性。

总结

通过上述步骤,我们可以有效地将从畅捷通T+系统中提取的数据进行ETL转换,并通过聚水潭API接口上传至目标平台。这个过程不仅包括基础的数据清洗和格式转换,还涉及到复杂的数据结构映射、异常处理与重试机制,以及全面的数据质量监控。这些技术手段共同保证了整个集成过程的高效性和可靠性。