案例分享:聚水潭数据集成到轻易云集成平台之刷新token方案

在数据密集型运营环境中,如何高效、稳定地实现多个系统间的数据对接成为企业面临的关键挑战。本文将通过一个实际案例——将聚水潭的数据集成到轻易云数据集成平台,详细解析整个技术过程与解决方案。

实现定时可靠的抓取聚水潭接口数据

为了确保从聚水潭获取的数据不漏单且及时更新,我们首先需要处理的是API接口调用问题。在本案例中,我们通过调用refresh.token接口来定期刷新和获取新的访问令牌,以保障我们的请求能够持续有效。同时,实现了自动化调度,以确保定时可靠地抓取所需数据。

处理分页和限流问题

由于周知的分页和限流策略,为避免一次性请求过多数据导致失败,我们采用了对返回结果进行分页处理的方式。每次仅抓取一定数量条目,并逐页递进,既提升了操作效率,也保障了API服务端的稳定性。

批量快速写入到轻易云集成平台

当成功从聚水潭获取了一系列业务数据后,下一个关键任务是如何高效地将这些大批量数据导入轻易云平台。我们使用其提供的写入空操作API,通过批量发送,一方面提高了传输速率,另一方面借助并行写入机制,加快整体流程速度。

数据格式差异及映射处理

不同系统间的数据结构通常存在一定差异,需要进行转换或映射。在此案例中,我们针对聚水潭输出的数据格式,与轻易云接受标准进行了比对和转换,通过自定义脚本或者配置映射关系菜单项,使得这部分工作更为简便直观。

以上构建了整个流程中的主要节点及其具体实施步骤,在后续内容里,将深入探讨每个模块的技术细节与优化策略。

调用聚水潭接口refresh.token获取并加工数据的技术案例

在数据集成过程中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用聚水潭接口refresh.token来获取并加工数据。

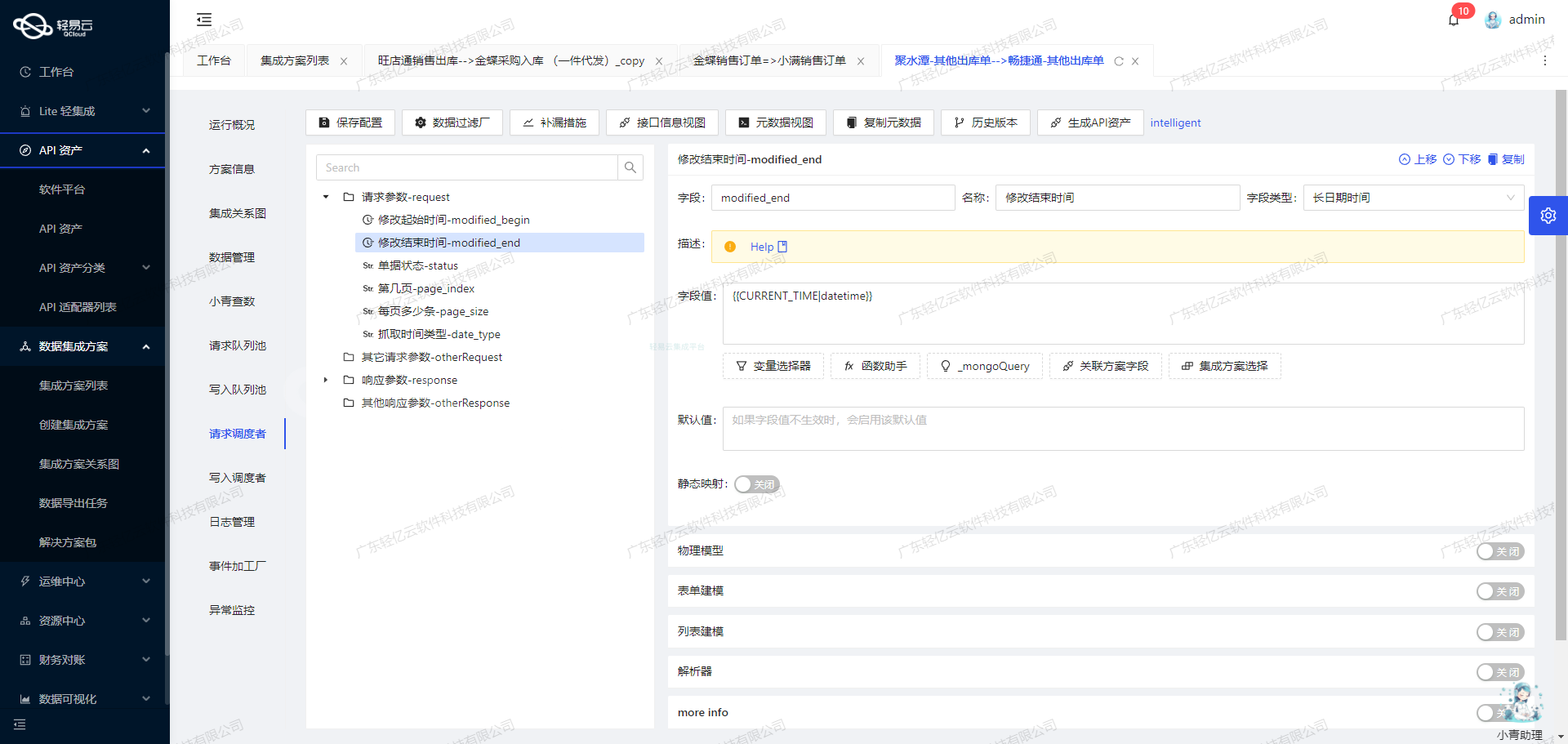

接口调用配置

首先,我们需要配置元数据以便正确调用聚水潭的refresh.token接口。以下是关键的元数据配置:

{

"api": "refresh.token",

"method": "POST",

"number": "msg",

"id": "msg",

"pagination": {

"pageSize": 50

},

"idCheck": true

}- api: 指定要调用的API名称,这里是

refresh.token。 - method: HTTP请求方法,使用POST。

- number: 用于标识返回消息中的数量字段。

- id: 用于标识返回消息中的ID字段。

- pagination: 分页配置,设置每页返回的数据量为50条。

- idCheck: 启用ID检查,确保数据唯一性。

数据请求与清洗

在生命周期的第一步中,我们需要发送HTTP POST请求到聚水潭的refresh.token接口。以下是一个示例请求:

POST /api/refresh.token HTTP/1.1

Host: jushuitan.com

Content-Type: application/json

Authorization: Bearer <your_access_token>

{

// 请求体内容,根据具体需求填写

}通过轻易云平台,我们可以在可视化界面中配置上述请求,并设置必要的认证信息和请求参数。平台会自动处理HTTP请求和响应,确保数据请求过程透明且高效。

数据转换与写入

收到响应后,需要对数据进行清洗和转换,以便后续处理。假设我们收到以下响应:

{

"msg": [

{

"id": "12345",

"token": "new_token_value",

// 其他字段...

}

// 更多记录...

]

}根据元数据配置,我们可以提取出关键字段,如id和token,并进行必要的转换。例如,将token值存储到指定的数据仓库或缓存系统中,以便后续使用。

实践案例:刷新Token并存储

假设我们需要定期刷新Token并将其存储到数据库中,可以按照以下步骤操作:

- 配置HTTP请求:在轻易云平台中配置HTTP POST请求,目标为聚水潭的

refresh.token接口。 - 处理响应数据:解析响应中的Token值,并进行必要的数据清洗和转换。

- 写入数据库:将新的Token值写入数据库表中,确保后续API调用能够使用最新的Token。

以下是一个示例代码片段,用于处理上述过程:

import requests

import json

# 配置API URL和Headers

url = 'https://jushuitan.com/api/refresh.token'

headers = {

'Content-Type': 'application/json',

'Authorization': 'Bearer <your_access_token>'

}

# 发起POST请求

response = requests.post(url, headers=headers, json={})

data = response.json()

# 提取Token值并存储到数据库(伪代码)

for item in data['msg']:

token_id = item['id']

new_token = item['token']

# 假设有一个函数save_to_db用于保存Token到数据库

save_to_db(token_id, new_token)通过这种方式,我们可以高效地实现Token刷新和存储操作,确保系统能够持续稳定地访问聚水潭API。

小结

本文详细介绍了如何通过轻易云数据集成平台调用聚水潭接口refresh.token获取并加工数据。从元数据配置、HTTP请求、响应处理到最终的数据存储,每一步都进行了深入探讨。这种全生命周期管理的方法极大提升了业务透明度和效率,为复杂的数据集成任务提供了可靠保障。

数据集成生命周期第二步:ETL转换与写入目标平台

在数据集成过程中,ETL(Extract, Transform, Load)转换是至关重要的一环。本文将深入探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入目标平台。我们将重点关注API接口的技术实现和元数据配置。

API接口与元数据配置

在进行数据写入时,我们需要特别注意API接口的配置。以下是一个典型的元数据配置示例:

{

"api": "写入空操作",

"method": "POST",

"idCheck": true

}这个配置文件定义了我们将使用的API接口以及相关的HTTP方法和参数验证要求。具体来说:

api: 指定了目标API接口,这里是“写入空操作”。method: 定义了HTTP请求方法,这里是POST。idCheck: 表示是否需要进行ID检查,这里设置为true。

ETL转换过程

-

数据提取(Extract):从源系统中提取原始数据。这一步通常涉及到对源系统API的调用,获取所需的数据集。

-

数据清洗与转换(Transform):对提取的数据进行清洗和格式转换,使其符合目标系统API的要求。例如,将日期格式统一、处理缺失值、规范化字段名称等。

-

数据加载(Load):将清洗和转换后的数据通过目标API接口写入到目标平台。在我们的案例中,使用的是“写入空操作”接口。

实现步骤

-

配置API接口

根据提供的元数据配置,首先需要在轻易云平台上配置好目标API接口。确保

api字段指向正确的目标接口,并且HTTP方法设置为POST。 -

编写ETL脚本

编写一个ETL脚本,用于执行数据提取、清洗和转换。以下是一个简单的Python示例:

import requests import json # 数据提取 def extract_data(source_api): response = requests.get(source_api) if response.status_code == 200: return response.json() else: raise Exception("Failed to fetch data from source") # 数据清洗与转换 def transform_data(raw_data): transformed_data = [] for item in raw_data: transformed_item = { "id": item["source_id"], "name": item["source_name"], # 添加更多字段映射和转换逻辑 } transformed_data.append(transformed_item) return transformed_data # 数据加载 def load_data(api_url, data): headers = {'Content-Type': 'application/json'} for item in data: response = requests.post(api_url, headers=headers, data=json.dumps(item)) if response.status_code != 200: raise Exception(f"Failed to write data: {response.text}") # 主函数 if __name__ == "__main__": source_api = "http://source-system/api/data" target_api = "http://target-system/api/写入空操作" raw_data = extract_data(source_api) cleaned_data = transform_data(raw_data) load_data(target_api, cleaned_data) -

执行ETL流程

在轻易云平台上部署并执行上述ETL脚本,确保每个步骤都能顺利完成。可以利用平台提供的实时监控功能,跟踪每个环节的数据流动和处理状态。

注意事项

- 确保在进行ID检查时,源系统和目标系统中的ID字段一致,以避免重复或冲突。

- 在实际应用中,需要根据具体业务需求,对ETL脚本中的字段映射和转换逻辑进行调整。

- 利用轻易云平台提供的可视化界面,可以更直观地监控和管理整个ETL流程,提高效率和透明度。

通过上述步骤,我们可以高效地将源平台的数据进行ETL转换,并成功写入到目标平台。这不仅简化了复杂的数据集成过程,还提升了业务处理的准确性和可靠性。