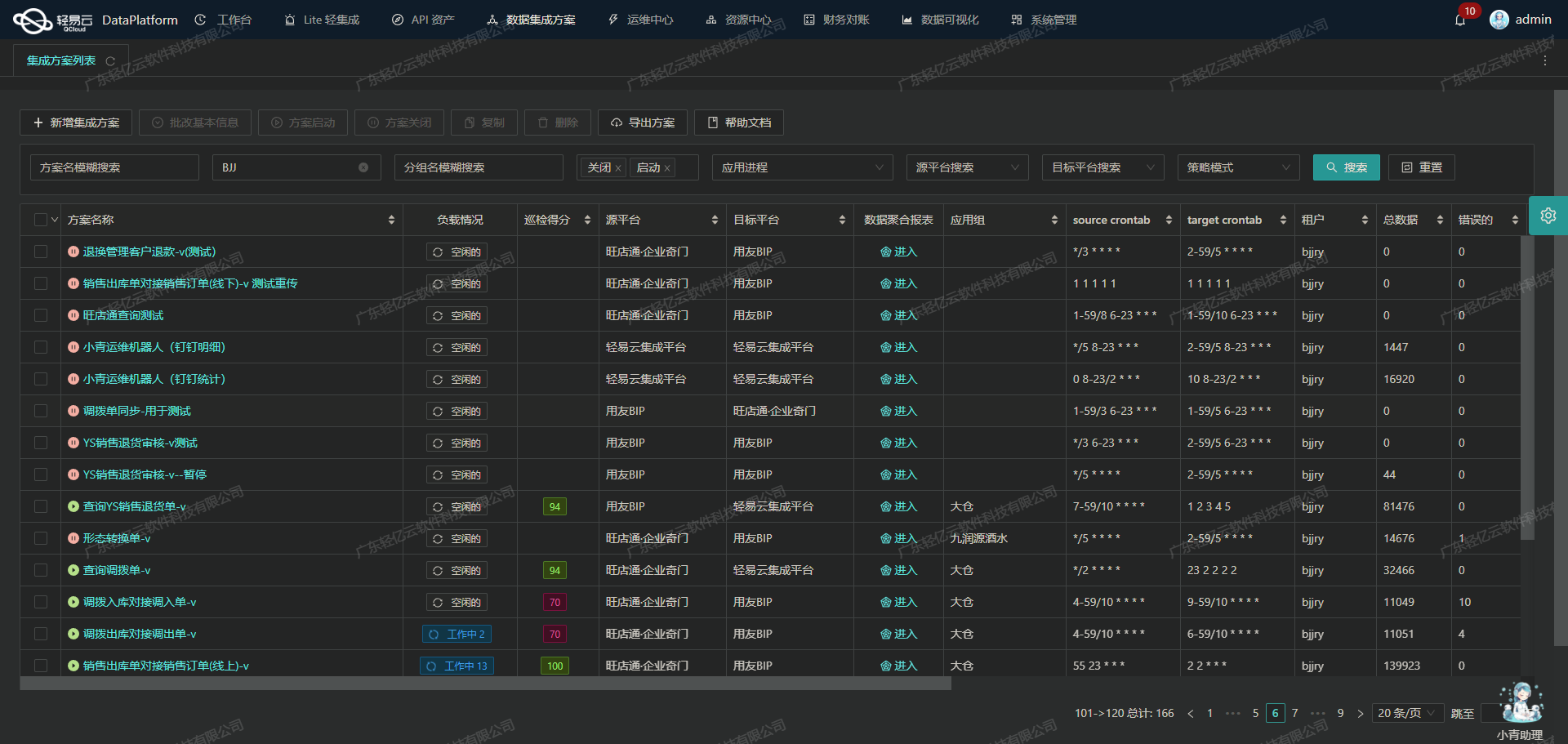

批量查询订单(总部)-ok:有赞云数据集成到敦煌种业先锋的技术实现

在企业数据集成的实际应用中,如何高效、准确地将有赞云平台的数据批量导入到敦煌种业先锋系统,是一个极具挑战性的任务。本文将分享一个具体的技术案例——“批量查询订单(总部)-ok”,详细探讨从有赞云获取订单数据并集成到敦煌种业先锋的全过程。

首先,我们利用有赞云提供的API接口 /youzan.trades.sold.get.4.0.4 来定时可靠地抓取订单数据。为了确保数据不漏单,我们设计了一套分页和限流处理机制,能够有效应对大规模数据请求中的各种异常情况。同时,通过轻易云平台强大的高吞吐量数据写入能力,我们可以快速将大量订单数据写入到敦煌种业先锋系统中。

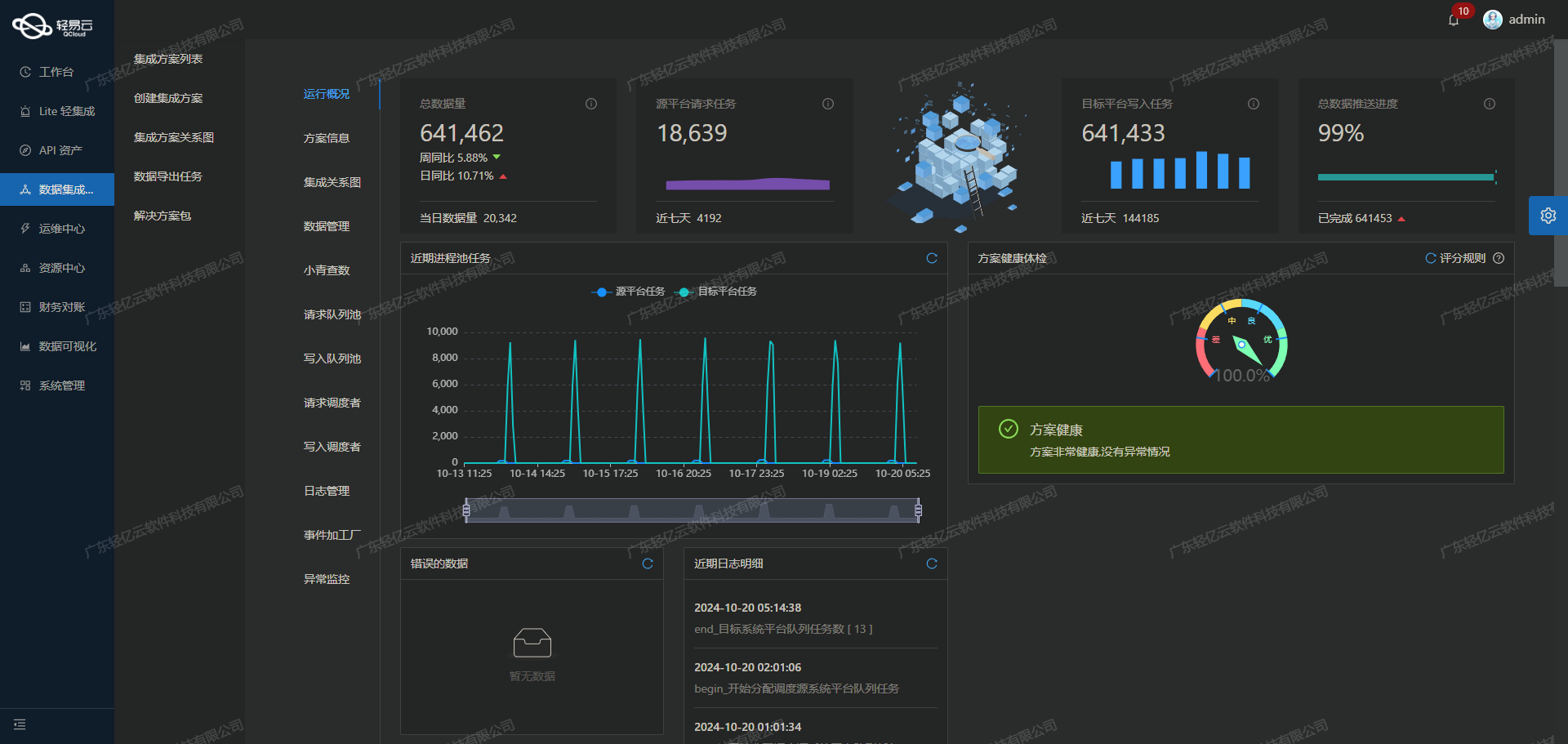

在整个集成过程中,实时监控与日志记录是至关重要的一环。我们通过集中监控和告警系统,实时跟踪每个数据集成任务的状态和性能,确保任何异常情况都能被及时发现和处理。此外,为了适应不同业务需求和数据结构,我们还支持自定义的数据转换逻辑,使得整个流程更加灵活和高效。

最后,在将数据写入敦煌种业先锋时,我们调用其API接口 /Api/QEasyCloud/OtOOrder 并进行定制化的数据映射对接。这不仅保证了数据格式的一致性,还提升了资源的利用效率,实现了真正意义上的无缝衔接。

通过上述技术手段,本方案成功实现了有赞云与敦煌种业先锋之间的数据高效集成,为企业提供了一套可靠、灵活且高效的数据解决方案。

调用有赞云接口/youzan.trades.sold.get.4.0.4获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过有赞云接口/youzan.trades.sold.get.4.0.4批量查询订单,并对数据进行初步加工处理。

接口调用配置

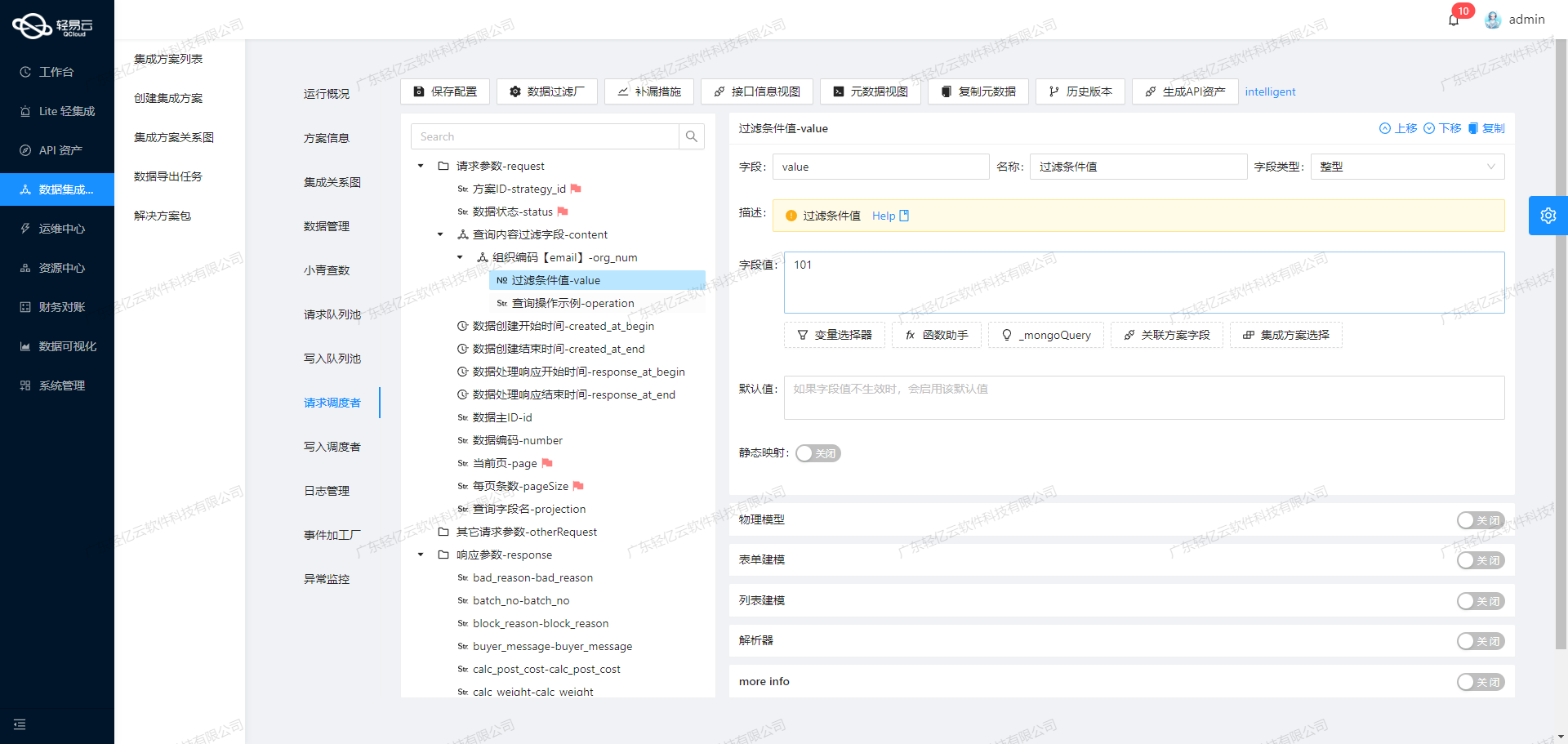

首先,我们需要配置元数据,以便正确调用有赞云的API。以下是关键的元数据配置项:

- API路径:

/youzan.trades.sold.get.4.0.4 - 请求方法:

GET - 分页参数:

page_no和page_size - 时间范围参数:

start_update和end_update - 状态过滤参数:

status

这些参数确保我们能够按需查询指定时间段内、特定状态的订单信息。

数据请求与清洗

-

构建请求参数

- 使用

start_update和end_update来限定查询时间范围。 - 设置分页参数

page_no为1,page_size为100,以便分批次获取大量订单数据。 - 通过状态过滤参数

status=WAIT_SELLER_SEND_GOODS,仅获取等待卖家发货的订单。

- 使用

-

发送请求

- 利用轻易云平台提供的可视化工具,配置上述请求参数并发送HTTP GET请求到有赞云API。

-

处理响应

- 响应结果包含多个订单记录,我们需要提取其中的核心字段,如订单号(tid)、创建时间等。

- 平台支持自动填充响应(autoFillResponse),可以简化这一过程。

{

"api": "/youzan.trades.sold.get.4.0.4",

"method": "GET",

"request": [

{"field": "start_update", "value": "{{LAST_SYNC_TIME|datetime}}"},

{"field": "end_update", "value": "{{CURRENT_TIME|datetime}}"},

{"field": "page_no", "value": "1"},

{"field": "page_size", "value": "100"},

{"field": "status", "value": "WAIT_SELLER_SEND_GOODS"}

],

...

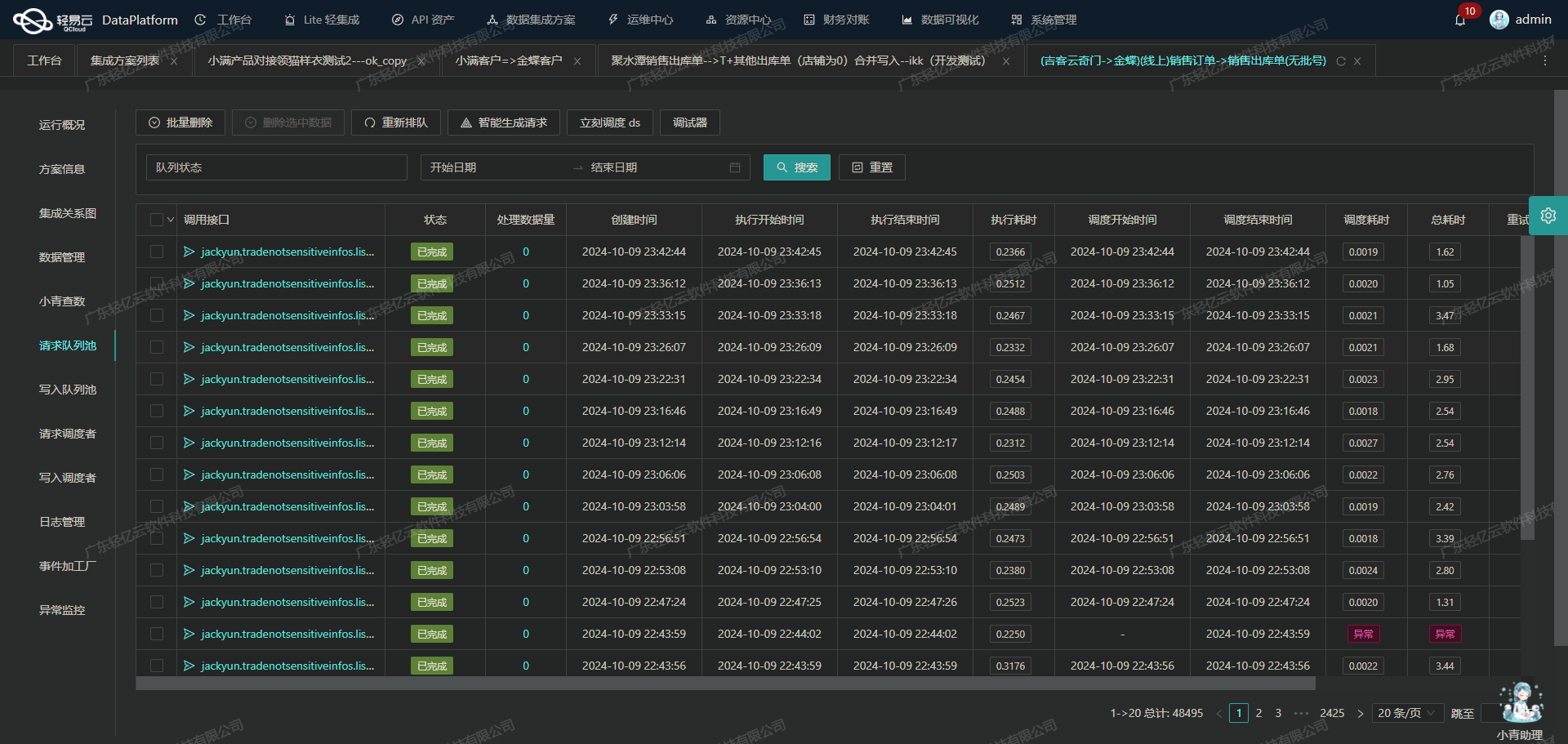

}分页与限流处理

由于一次性获取所有订单可能导致超时或限流问题,我们需要实现分页机制:

-

初始化分页

- 设置初始页码为1,每页大小为100条记录。

-

循环请求

- 在每次成功获取一页数据后,检查是否还有更多页面。如果有,则递增页码继续请求下一页。

-

限流控制

- 有赞云API可能会对频繁请求进行限流。我们可以设置适当的重试机制和间隔时间,以避免触发限流限制。

数据转换与写入准备

在完成数据获取后,需要对原始数据进行初步清洗和转换,以适应目标系统的数据结构。例如,将日期格式统一转换为标准ISO格式,将金额字段转换为浮点数等。这一步骤可以利用轻易云平台提供的数据转换功能,通过自定义脚本或规则实现。

{

...

"beatFlat":["orders"],

...

}异常处理与监控

为了确保整个流程的可靠性,我们还需要设置异常处理和监控机制:

-

异常捕获

- 对于每个API调用,如果发生错误(如网络超时、无效响应等),记录错误日志并尝试重试一定次数。

-

实时监控

- 利用平台提供的集中监控系统,实时跟踪每个任务的执行状态,包括成功率、失败次数、平均响应时间等指标。

-

告警通知

- 当检测到严重异常或连续多次失败时,触发告警通知相关人员及时处理。

通过以上步骤,我们能够高效地从有赞云接口批量查询订单,并对数据进行初步加工,为后续的数据集成打下坚实基础。这不仅提升了业务透明度和效率,也确保了数据质量和一致性。

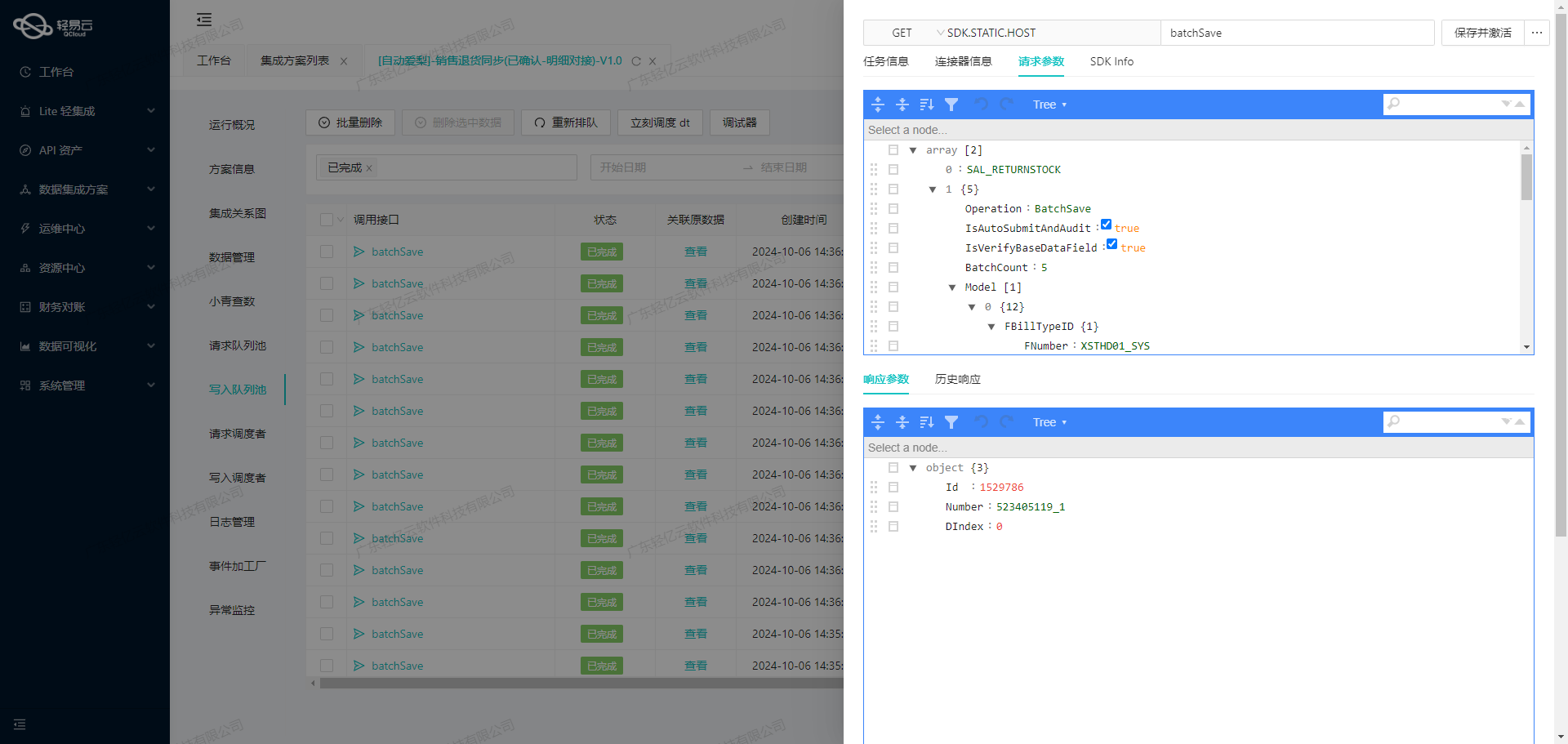

集成平台生命周期第二步:ETL转换与数据写入

在数据集成过程中,将源平台的数据转换为目标平台可接收的格式是关键的一步。本文将详细探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL(Extract-Transform-Load)转换,并将其转为敦煌种业先锋API接口所能够接收的格式,最终写入目标平台。

数据请求与清洗

在ETL转换之前,首先需要从源平台(如有赞云)获取订单数据。通过调用有赞云提供的API接口(如youzan.trades.sold.get.4.0.4),可以定时可靠地抓取订单信息。为了确保数据不漏单,可以利用分页机制和限流策略,批量查询订单并存储到临时数据库中。

数据转换

接下来,我们进入ETL生命周期的核心部分:数据转换。在这个阶段,需要根据目标平台敦煌种业先锋API接口的要求,对源数据进行格式转换和字段映射。

以下是元数据配置示例:

{

"api": "/Api/QEasyCloud/OtOOrder",

"effect": "EXECUTE",

"method": "POST",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

"request": [

{"field":"OrderNo","label":"订单号","type":"string","value":"{bfn_num}"},

{"field":"OrderTime","label":"下单时间","type":"string","value":"{{order_info.created}}"},

{"field":"StoreId","label":"门店id","type":"string","value":"{{order_info.node_kdt_id}}"},

{"field":"CustomerId","label":"客户id","type":"string","value":"{{buyer_info.yz_open_id}}"},

{"field":"ProductName","label":"产品名称","type":"string","value":"{orders_newtitle}"},

{"field":"ProductSPec","label":"产品编码","type":"string","value":"{orders_newSpecNo}"},

{"field":"Num","label":"数量","type":"string","value":"{orders_num}"},

{"field":"Amount","label":"金额","type":"string","value":"{orders_price}"},

{"field":"Name","label":"收货人姓名","type":"string","value":"{{address_info.receiver_name}}"},

{"field":"MobilePhone","label":"收货人电话","type":"string","value":"{{address_info.receiver_tel}}"},

{"field":"ProvinceName","label":"省","type":"string","value":"{{address_info.delivery_province}}"},

{"field":"CityName","label":"市","type":"string","value":"{{address_info.delivery_city}}"},

{"field":"DistrictName","label":"区","type":"string","value":"{{address_info.delivery_district}}"},

{"field": "Address", "label": "详细地址", "type": "string", "value": "{{address_info.delivery_address}}"}

]

}在这个配置中,每一个字段都被映射到对应的目标字段。例如,OrderNo(订单号)从源数据中的bfn_num字段提取,而OrderTime(下单时间)则从order_info.created提取。这种映射确保了源数据能够准确地转化为目标系统所需的格式。

数据写入

完成数据转换后,下一步是将处理后的数据写入到敦煌种业先锋系统。轻易云数据集成平台支持高吞吐量的数据写入能力,可以实现大量订单信息的快速传输和存储。

通过POST方法将转换后的数据发送到指定API端点/Api/QEasyCloud/OtOOrder。为了确保每一条记录都成功写入,可以使用轻易云的数据质量监控和异常检测功能。如果发生错误,系统会自动触发重试机制,保证数据传输的可靠性和完整性。

实时监控与日志记录

在整个ETL过程执行期间,通过集中的监控和告警系统,可以实时跟踪每个任务的状态和性能。一旦出现异常情况,系统会及时发出告警通知,并记录详细日志以便后续排查。这些日志不仅包括成功的数据传输记录,还涵盖了所有失败和重试操作的信息,为问题定位和解决提供了有力支持。

自定义逻辑与优化配置

为了适应特定业务需求,可以在轻易云平台上自定义数据转换逻辑。例如,对于某些特殊字段,可以编写自定义函数进行处理。此外,通过统一视图和控制台管理API资产,可以全面掌握API调用情况,实现资源的高效利用和优化配置。

以上就是使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入敦煌种业先锋系统的详细步骤和技术要点。在实际操作中,通过合理配置元数据、精确映射字段、实时监控任务状态以及自定义业务逻辑,可以高效、可靠地完成复杂的数据集成任务。