BDS对账班牛返款表_update: 从班牛到MySQL的数据集成实战

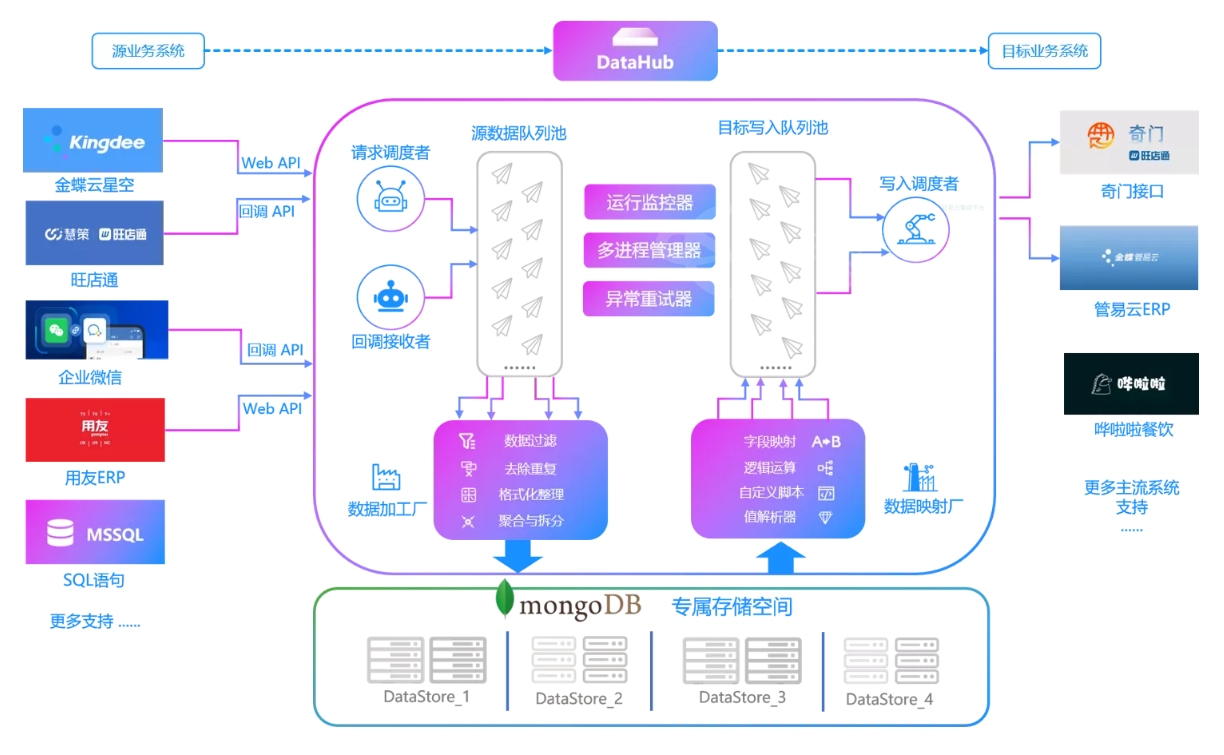

在实际操作中,如何高效地将班牛系统中的数据准确无误地对接到MySQL数据库,是许多数据工程师面临的重要挑战。本案例分享一个具体的技术方案,展示如何使用轻易云数据集成平台实现从班牛系统(通过task.list API获取)抓取对账返款表并批量写入到MySQL数据库(通过executeReturn API)的全过程。

本方案命名为“BDS对账班牛返款表_update”,旨在确保每一笔数据都能稳定、快速且准确地进行传输和转换。我们主要关注以下几个核心技术细节:

-

调度与实时监控:借助集中化的监控和告警系统,全程跟踪任务状态及性能。在出现异常时,及时通知相关人员,并自动触发重试机制以保证任务的连续性。

-

API接口调用及分页处理:通过调用

task.list接口获取班牛数据,针对接口返回结果支持分页请求,以应对大规模数据传输过程中的限流问题。同时,通过自定义了一套健壮的逻辑来处理可能存在的数据格式差异。 -

高吞吐量写入:为了提升整体效率,在 MySQL 数据库侧采用了批量写入策略,将大量抓取的数据一次性导入目标数据库。此过程中,对事务控制进行了精细管理,避免因单个记录失败而导致整体操作回滚的问题。

-

自定义转换与映射:针对业务需求,我们设计了特定的数据映射规则,使得从源端(班牛)到目标端(MySQL)的字段匹配更加合理。这不仅提高了灵活性,也减少了后续手动校正工作量。

-

异常检测与错误处理:在整个流程中嵌入了完善的数据质量监控模块,用于捕获异常情况。一旦发现不一致或错误,会立即记录日志并触发预定义措施,包括但不限于报警通知、暂停任务以及人工介入力干预等,以确保最终存储的数据完整且准确。

综上所述,本案例涵盖从原始API数据提取,到逐步清洗、转换直至最终保存到 MySQL 数据库的一整套解决方案。如果你也正在面对类似需求,希望本次分享能为你提供参考和帮助。

调用源系统班牛接口task.list获取并加工数据

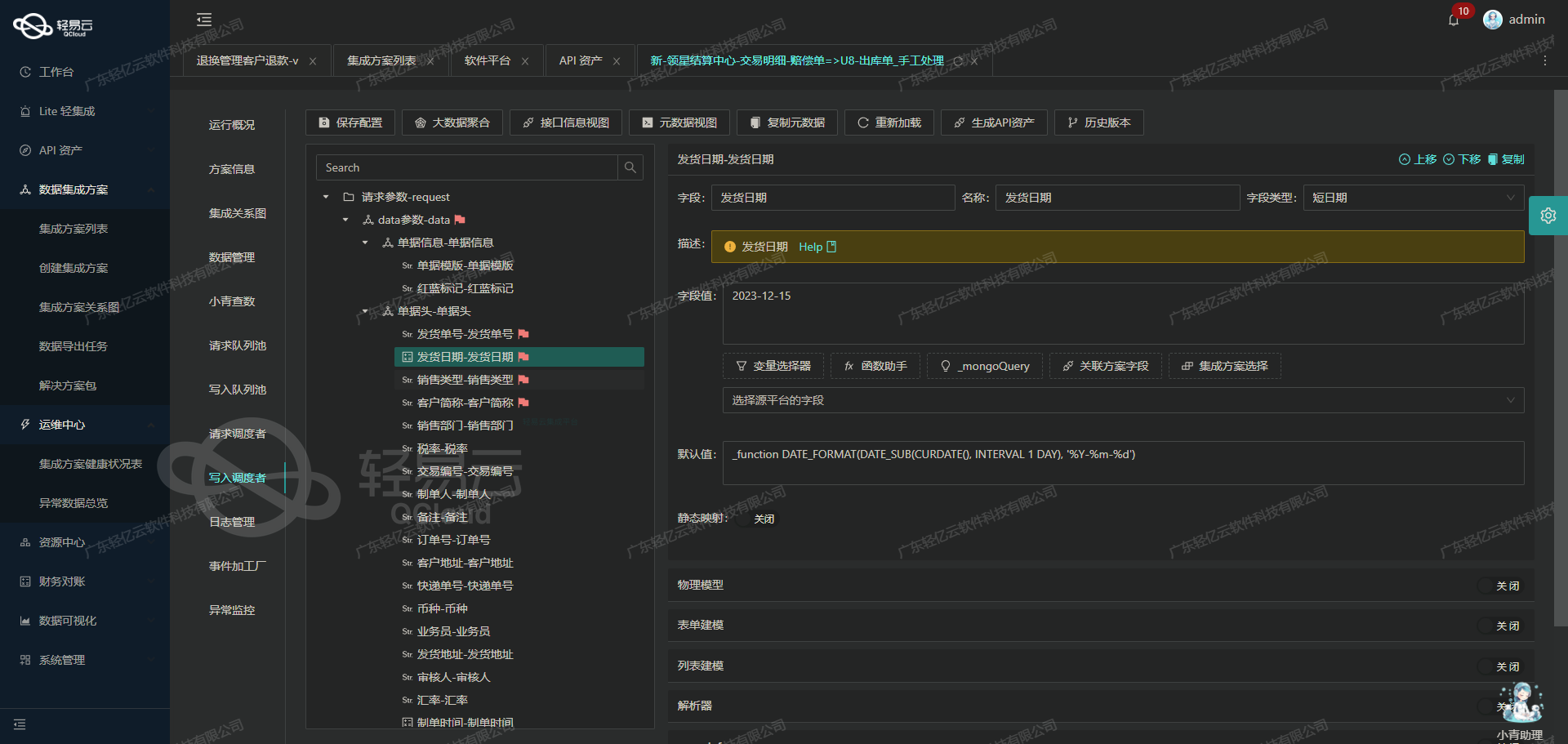

在数据集成的生命周期中,调用源系统接口是至关重要的一步。本文将深入探讨如何通过轻易云数据集成平台调用班牛接口task.list,并对获取的数据进行加工处理。

接口配置与请求参数

首先,我们需要配置接口和请求参数。根据提供的元数据配置,我们使用GET方法调用task.list接口,以下是具体的请求参数:

project_id: 群组ID,固定值为"64028"。page_size: 每页记录数,固定值为"50"。page_num: 页码,初始值为"1"。star_created: 起始时间,可选参数,用于筛选创建时间范围内的数据。end_created: 结束时间,可选参数,用于筛选创建时间范围内的数据。star_modified: 修改时间起始时间,默认值为24小时前的当前时间。end_modified: 修改时间结束时间,默认值为当前时间。

这些参数确保我们能够灵活地获取所需的数据,并且可以根据实际需求调整筛选条件。

数据请求与清洗

在发起请求后,我们会收到一批原始数据。为了确保数据质量和一致性,需要对这些数据进行清洗和预处理。以下是一些常见的清洗步骤:

- 字段校验:检查每个字段是否符合预期格式和类型。例如,确保日期字段符合标准的日期格式。

- 缺失值处理:对于缺失值,可以选择填充默认值、删除记录或标记异常。

- 重复数据处理:检测并移除重复记录,以保证数据唯一性。

通过这些步骤,我们可以得到一份干净且结构化的数据,为后续的转换和写入打下基础。

数据转换与写入

在清洗完毕后,需要对数据进行转换,以适应目标系统的要求。这可能包括字段映射、单位转换等操作。例如,将班牛系统中的任务状态字段映射到目标系统中的对应状态字段。

转换完成后,将数据写入目标系统。在轻易云平台上,可以通过配置相应的目标接口和写入规则,实现自动化的数据写入过程。

实时监控与异常处理

轻易云平台提供了实时监控功能,可以随时查看数据流动和处理状态。一旦出现异常,如接口调用失败或数据不一致,可以及时采取措施进行修正。例如,通过重试机制重新发起请求,或手动修正错误数据。

条件过滤与逻辑判断

元数据配置中还包含了一些条件过滤和逻辑判断,例如:

"condition_bk":[[{"field":77212,"logic":"eqv2","value":"76615"},{"field":5,"logic":"eqv2","value":"1"},{"field":"77248","logic":"gt","value":"0"}]]这些条件用于进一步筛选符合特定逻辑的数据。例如,上述条件表示字段77212等于76615且字段5等于1且字段77248大于0。通过这种方式,可以精确控制要处理的数据范围,提高效率和准确性。

综上所述,通过合理配置接口参数、进行有效的数据清洗与转换,并结合实时监控和条件过滤功能,我们可以高效地实现班牛系统与其他异构系统之间的数据集成。

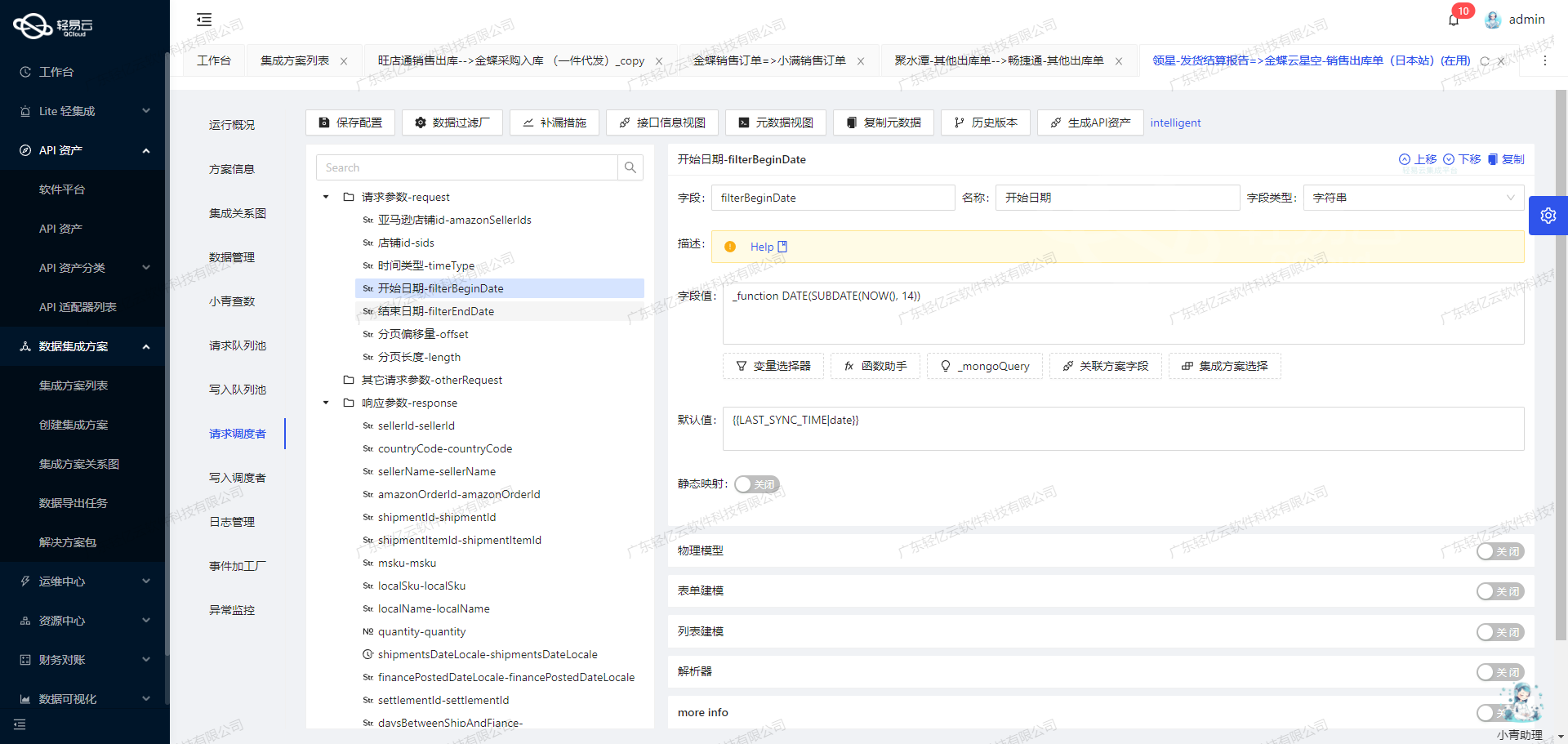

轻易云数据集成平台生命周期第二步:ETL转换与写入MySQL API接口

在数据集成过程中,ETL(Extract, Transform, Load)是一个关键步骤。本文将深入探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入目标平台MySQL API接口。

数据请求与清洗

首先,我们需要从源系统中提取原始数据。轻易云提供了强大的数据请求和清洗功能,可以通过配置元数据来实现。这一步骤主要包括定义API请求参数、设置过滤条件和执行初步的数据清洗。

在我们的案例中,假设我们需要对接BDS对账班牛返款表,并将其更新到目标平台MySQL数据库中。我们可以通过以下元数据配置来实现:

{

"api": "executeReturn",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{

"field": "bill_no",

"label": "单据编号",

"type": "string",

"value": "{{-1}}"

},

{

"field": "shop_name",

"label": "销售渠道名称",

"type": "string",

"value": "_mongoQuery e697d435-6a50-3792-a326-33a0cf78fd9b findField=content.options_title where={\"$or\":[{\"content.options_id\" :\"{{64030}}\"},{\"content.options_id\" :\"{{64031}}\"}]}"

}

]

}

],

"otherRequest": [

{

"field": "main_sql",

"label": "主语句",

"type": "string",

"value": "UPDATE `lhhy_srm`.`supplier_rebate` SET `shop_name` = <{shop_name: }> \nWHERE `bill_no` = <{bill_no}>;"

}

],

"buildModel": true

}数据转换

在完成数据提取和清洗之后,我们需要对数据进行转换,以确保其符合目标平台的格式要求。在本案例中,我们需要将提取到的bill_no和shop_name字段转换为MySQL API接口能够接受的格式。

通过元数据配置中的main_sql字段,我们定义了一个SQL更新语句,用于将转换后的数据写入目标数据库:

UPDATE `lhhy_srm`.`supplier_rebate`

SET `shop_name` = <{shop_name: }>

WHERE `bill_no` = <{bill_no}>;这里,<{shop_name: }>和<{bill_no}>是占位符,将在实际执行时被相应的字段值替换。

数据写入

最后一步是将转换后的数据写入目标平台。在我们的配置中,通过API调用实现这一过程。我们使用了HTTP POST方法,并指定了API端点为executeReturn。

为了确保数据的准确性和完整性,轻易云平台支持ID检查(idCheck),即在写入之前验证记录是否存在或是否符合特定条件。这一步骤极大地提高了数据处理的可靠性。

以下是API调用的详细配置:

{

"api": "/executeReturn",

"method": "POST",

...

}实际应用案例

假设我们从源系统中提取到如下记录:

{

"-1" : {"bill_no":"20231001",

"_mongoQuery e697d435-6a50-3792-a326-33a0cf78fd9b findField=content.options_title where={\"$or\":[{\"content.options_id\" :\"64030\"},{\"content.options_id\":\"64031\"}]}":"渠道A"}

}根据配置,这些记录会被转换为如下SQL语句并执行:

UPDATE `lhhy_srm`.`supplier_rebate`

SET `shop_name` = '渠道A'

WHERE `bill_no` = '20231001';通过上述步骤,我们成功地将源系统的数据进行了ETL处理,并将其无缝写入到了目标MySQL数据库中。这不仅提升了业务流程的自动化程度,还确保了数据的一致性和准确性。

总结来说,通过轻易云的数据集成平台,我们可以高效地完成从数据提取、清洗、转换到最终写入的全过程管理,实现不同系统间的数据无缝对接。