MySQL数据集成案例:从returnorder_z到returnorder

在我们的业务场景中,高效地实现MySQL数据库之间的数据集成对于保证系统的稳定性和实时性至关重要。本文将分享一个实际操作案例,展示如何通过轻易云数据集成平台,将MySQL中的returnorder_z表的数据准确无误地迁移到另一个MySQL实例的returnorder表。

数据流设计与方案概述

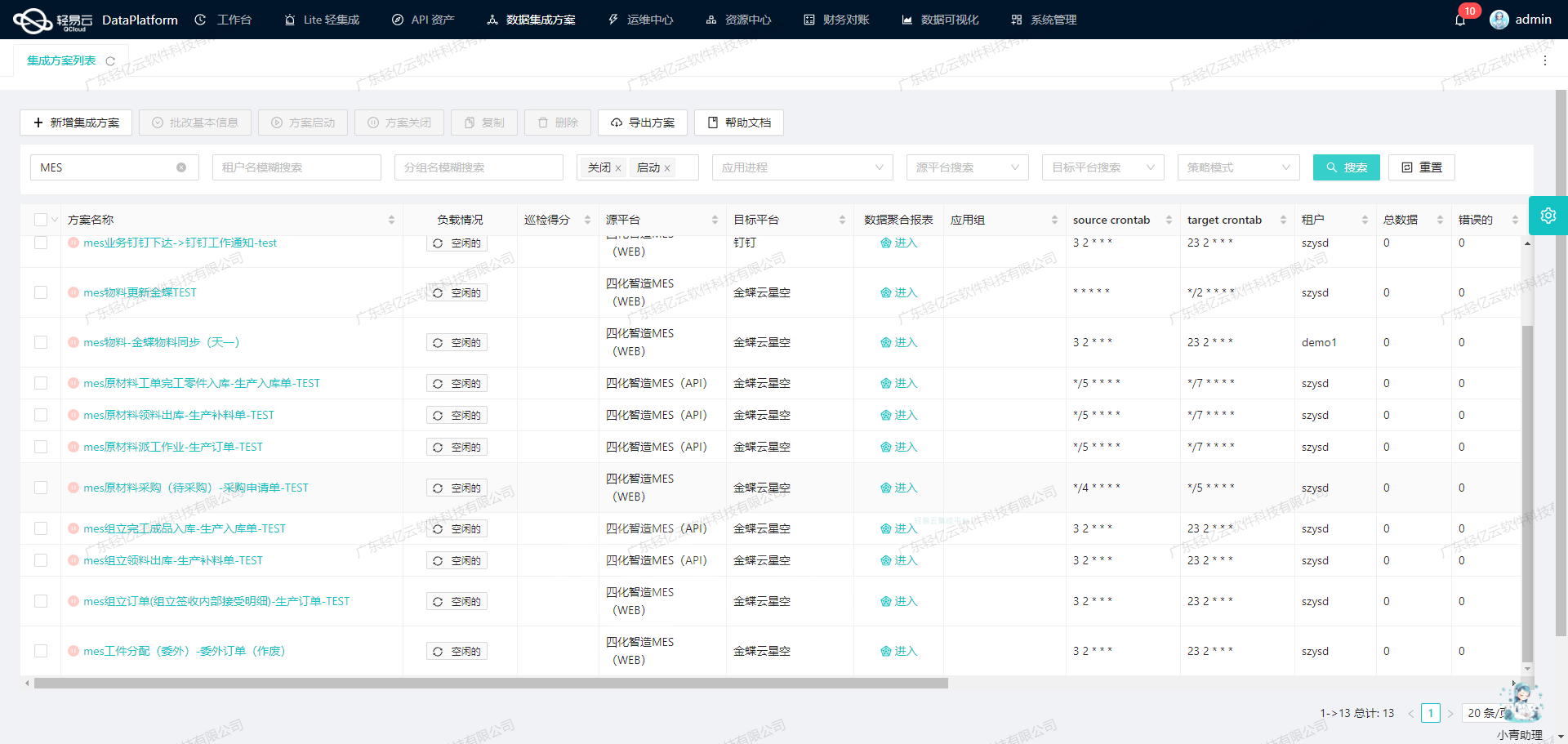

本次数据集成任务命名为“8--BI秉心-退换货单表”。整体流程包括从原始MySQL数据库中抓取退换货单信息,并通过高吞吐量的数据写入机制,将这些批量数据快速、安全、精准地导入目标MySQL数据库。

关键技术点解析:

-

API接口调用:

- 获取数据(select):我们使用标准的SELECT查询语句,从源数据库中获取所有需要同步的退换货单记录。

- 写入数据(batchexecute):为了提高效率,我们采用批量执行模式,每次处理大批量的数据插入/更新操作,确保高吞吐且低延迟。

-

自定义转换逻辑: 在某些业务需求下,我们需要对特定字段进行转换或映射。例如,在将订单状态字段从原有格式转化为新的枚举值时,被灵活配置以适应不同环境的自定义转换逻辑就显得尤为重要。

-

集中监控与告警系统: 实时监控平台能够持续跟踪整个数据流动过程,包括任务状态、性能指标等。如果出现任何异常情况,可以立即触发告警并记录详细日志,以便快速定位和解决问题,加速了调试与维护工作周期。

-

异常处理与重试机制: 数据同步过程中难免遇到网络抖动或服务不可用的问题。对此,内置了完善的错误检测机制,一旦发现失败事件,会自动进行多次重试,同时保持幂等性策略,避免重复写入导致的数据不一致现象发生。

-

分页和限流控制: 针对大表数据提取,我们特别设置了合理的分页策略和限流措施。这不仅能避免因一次性加载大量数据引起内存溢出,还有效防止目标数据库因瞬间大量请求而过载崩溃,实现平滑移植和负载均衡优化。

以上是对这次MySQL-to-MySQL 数据集成的一些主要技术点介绍。在接下来的章节里,将继续深入探讨每个环节及其具体实现方法,以及可能遇到的问题及应对策略。

使用轻易云数据集成平台从MySQL接口获取并加工数据的技术案例

在数据集成的生命周期中,第一步是从源系统调用接口获取数据。本文将详细探讨如何使用轻易云数据集成平台从MySQL数据库中调用select接口获取并加工数据。

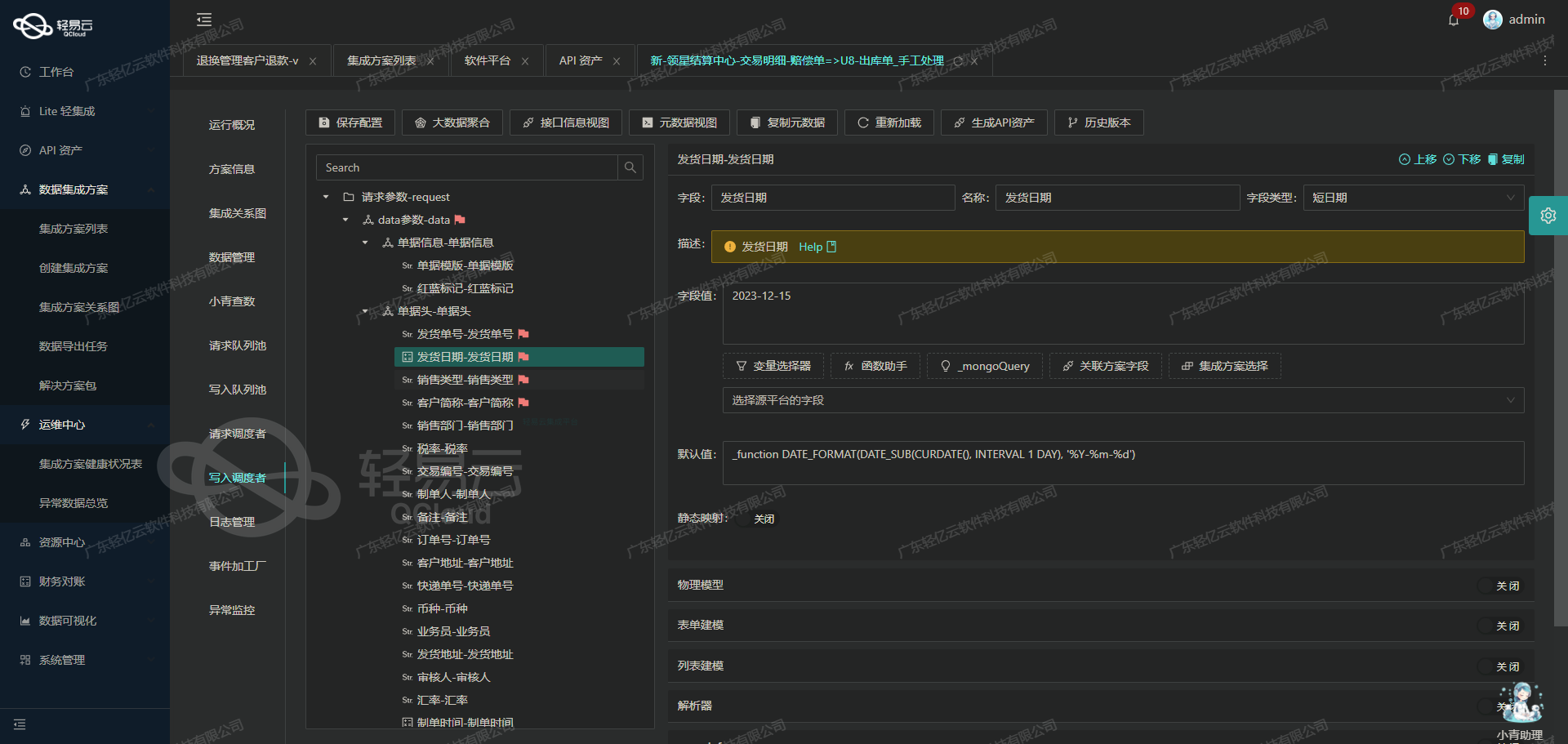

元数据配置解析

在进行实际操作之前,我们需要理解元数据配置中的各个字段及其作用。以下是元数据配置的详细解析:

- api: "select" - 表示我们将使用

select语句从MySQL数据库中查询数据。 - effect: "QUERY" - 该操作的效果是查询。

- method: "SQL" - 使用SQL语句进行查询。

- number: "Id" - 数据表中的唯一标识字段。

- id: "Id" - 同样是唯一标识字段。

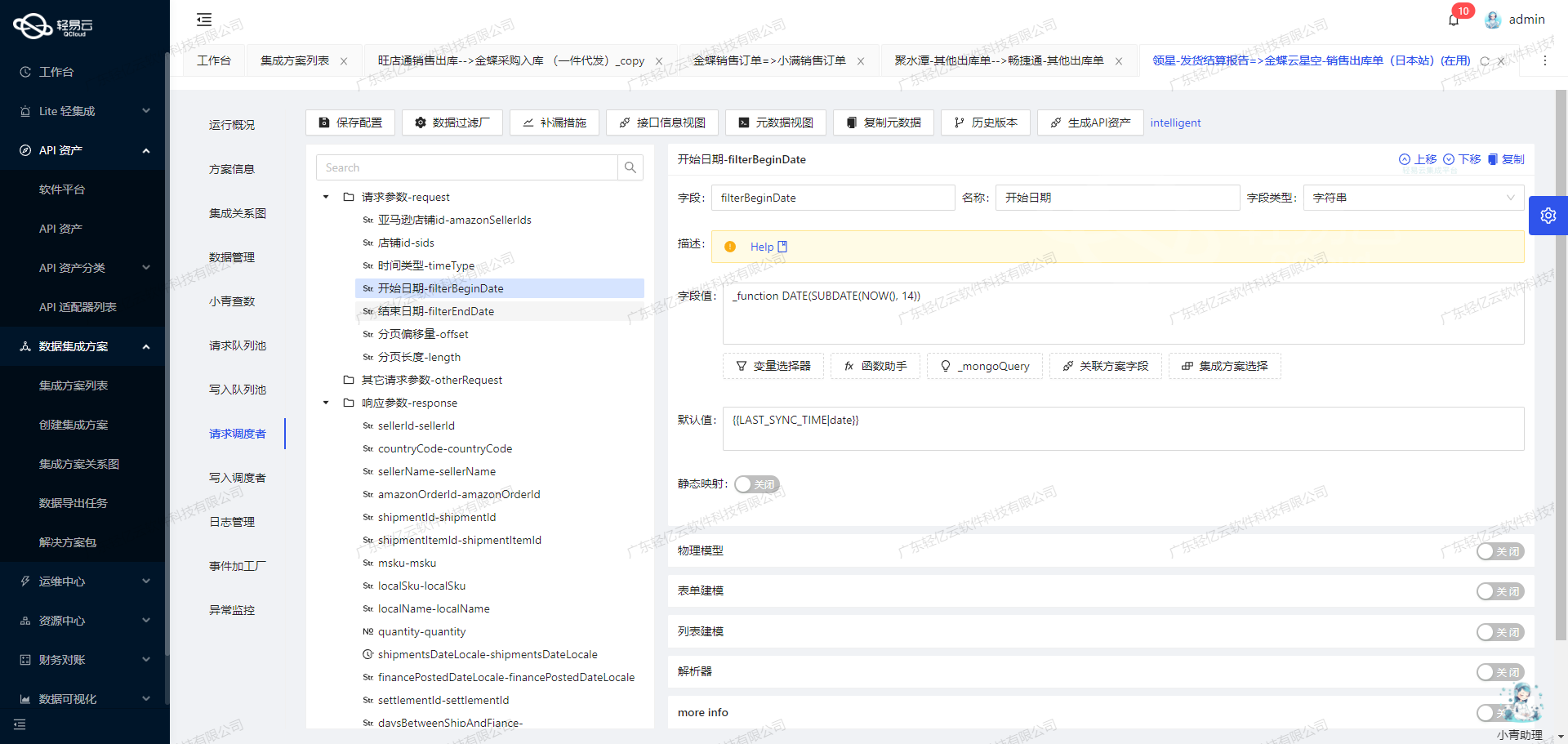

请求参数(request)

请求参数定义了SQL查询所需的主参数:

- limit: 限制结果集返回的行数,类型为int,值为5000。用于分页查询,每次返回最多5000行数据。

- offset: 偏移量,类型为int。指定查询结果的起始位置,用于分页。

- ModifyDateBegin: 修改时间的开始时间,类型为string,值为动态变量

{{LAST_SYNC_TIME|datetime}}。 - ModifyDateEnd: 修改时间的结束时间,类型为string,值为动态变量

{{CURRENT_TIME|datetime}}。

其他请求参数(otherRequest)

- main_sql: 主SQL语句,类型为string。该语句包含动态字段

:limit、:offset、:ModifyDateBegin和:ModifyDateEnd,这些字段将在执行时被实际参数替换。

select * from returnorder_z

where ModifyDate >= :ModifyDateBegin

and ModifyDate <= :ModifyDateEnd

limit :limit offset :offset实际操作步骤

-

配置主SQL语句

在轻易云平台上,我们首先需要配置主SQL语句。在这个例子中,我们将使用如下SQL语句:

select * from returnorder_z where ModifyDate >= :ModifyDateBegin and ModifyDate <= :ModifyDateEnd limit :limit offset :offset -

绑定请求参数

接下来,我们需要将请求参数与SQL语句中的占位符进行绑定。这一步骤确保了动态字段能够正确地被实际值替换,提高了查询的准确性和安全性。

-

执行查询

配置完成后,我们可以执行查询。平台会自动将动态变量替换为实际值,并生成最终的SQL语句。例如,如果当前时间是2023年10月1日,最后同步时间是2023年9月30日,那么生成的SQL语句可能如下:

select * from returnorder_z where ModifyDate >= '2023-09-30 00:00:00' and ModifyDate <= '2023-10-01 23:59:59' limit 5000 offset 0 -

处理结果集

查询执行后,我们会得到一个结果集。此时可以对结果集进行进一步处理,例如清洗、转换等,以便后续的数据写入阶段。

技术要点

-

动态参数绑定

动态参数绑定提高了查询的灵活性和安全性。通过使用占位符和绑定实际值,可以避免SQL注入攻击,并且使得代码更具可读性和维护性。

-

分页查询

使用LIMIT和OFFSET实现分页查询,可以有效地控制每次返回的数据量。这对于处理大规模数据非常重要,有助于提高系统性能和响应速度。

-

时间范围过滤

通过设置修改时间范围,可以确保只获取在特定时间段内修改的数据。这对于增量同步非常有用,可以减少不必要的数据传输,提高效率。

通过上述步骤和技术要点,我们可以高效地从MySQL数据库中调用接口获取并加工数据,为后续的数据转换与写入打下坚实基础。

数据转换与写入目标平台 MySQL 的技术实现

在轻易云数据集成平台的生命周期中,第二步是将已经集成的源平台数据进行ETL转换,转为目标平台 MySQL API 接口所能够接收的格式,并最终写入目标平台。本文将详细探讨这一过程中的技术细节和实现方法。

元数据配置解析

我们使用的元数据配置如下:

{

"api": "batchexecute",

"effect": "EXECUTE",

"method": "SQL",

"idCheck": true,

"request": [

{"field":"Id","label":"Id","type":"int","value":"{Id}"},

{"field":"CreateDate","label":"CreateDate","type":"datetime","value":"{CreateDate}","default":"1970-01-01 00:00:00"},

{"field":"CreateUserName","label":"CreateUserName","type":"string","value":"{CreateUserName}"},

{"field":"Code","label":"Code","type":"string","value":"{Code}"},

{"field":"ApproveUser","label":"ApproveUser","type":"string","value":"{ApproveUser}"},

{"field":"ApproveDate","label":"ApproveDate","type":"datetime","value":"{ApproveDate}","default":"1970-01-01 00:00:00"},

{"field":"AuditUser","label":"AuditUser","type":"string","value":"{AuditUser}"},

{"field":"AuditDate","label":"AuditDate","type":"datetime","value":"{AuditDate}","default":"1970-01-01 00:00:00"},

{"field":"ExpressNo","label":"ExpressNo","type":"string","value":"{ExpressNo}"},

{"field":"ExpressName","label":"ExpressName","type":"string","value":"{ExpressName}"},

{"field":...},

...

],

"otherRequest": [

{

"field": "main_sql",

"label": "主语句",

"type": "string",

"describe": "111",

"value": "REPLACE INTO returnorder (Id, CreateDate, CreateUserName, Code, ApproveUser, ApproveDate, AuditUser, AuditDate, ExpressNo, ExpressName, MemberId, MemberName, MemberCode, StoreId, StoreName, WarehouseInId, WarehouseInCode, WarehouseInName, WarehouseOutId, WarehouseOutCode, WarehouseOutName, Status, TradeId,..."

},

{

"field": "limit",

"label": "limit",

"type": "string",

"value": "1000"

}

],

"buildModel": true

}数据请求与清洗

在数据请求阶段,我们从源系统获取原始数据。这些数据通常是非结构化或半结构化的,需要经过清洗和预处理,以确保其质量和一致性。例如,将日期字段格式化为标准的 yyyy-MM-dd HH:mm:ss 格式,处理缺失值等。

数据转换与写入

在数据转换阶段,我们使用元数据配置中的字段映射关系,将源数据字段转换为目标 MySQL 表中的相应字段。以下是具体步骤:

-

字段映射:根据元数据配置中的

request部分,将每个源字段映射到对应的目标字段。例如:{"field": "Id", "label": "Id", "type": "int", "value": "{Id}"}表示将源数据中的

Id字段映射到目标表中的Id字段。 -

默认值处理:对于某些可能为空的字段,我们可以设置默认值。例如:

{"field": "CreateDate", ... , "default": "1970-01-01 00:00:00"}如果

CreateDate字段为空,则使用默认值1970-01-01 00:00:00。 -

构建 SQL 语句:根据

otherRequest部分中的main_sql字段,构建批量插入或更新的 SQL 语句。这里我们使用REPLACE INTO来确保如果记录已存在则更新,不存在则插入。REPLACE INTO returnorder (Id, CreateDate, CreateUserName, Code,...) VALUES (?, ?, ?, ?, ...) -

执行 SQL:通过 API 调用执行构建好的 SQL 语句,将转换后的数据批量写入 MySQL 数据库。API 配置如下:

{ "api": "/batchexecute", ... ... ... ... ... }

示例代码

以下是一个示例代码片段,用于展示如何利用上述元数据配置完成 ETL 转换并写入 MySQL:

import requests

import json

# 定义 API URL 和头部信息

api_url = 'http://your-api-endpoint/batchexecute'

headers = {'Content-Type': 'application/json'}

# 构建请求体

payload = {

'main_sql': 'REPLACE INTO returnorder (Id,... ) VALUES ',

'data': [

{'Id': 1,...},

{'Id': 2,...},

...

]

}

# 将请求体转为 JSON 格式

payload_json = json.dumps(payload)

# 发起 POST 请求

response = requests.post(api_url, headers=headers, data=payload_json)

# 检查响应状态码和内容

if response.status_code == 200:

print('Data successfully written to MySQL.')

else:

print('Failed to write data:', response.text)通过上述步骤,我们可以高效地将源平台的数据转换并写入到目标 MySQL 平台,实现不同系统间的数据无缝对接。这不仅提升了业务透明度和效率,还确保了数据的一致性和完整性。